一站式 LLM入门

1. Introduction:人工智能概述

1.1 人工智能概念与分支

-

人工智能(Artificial Intelligence)是让各类机器载体上模拟并拥有类似生物的智能,让机器可以进行感知、学习、识别、推理等行为的计算机科学��技术。

-

人工智能是计算机科学的分支,涉及领域包括计算机视觉(Computer Vision,CV)、自然语言处理(Natural Language Processing,NLP)、语音识别(Voice Recognition)、语音生成(Text to Speech,TTS)、知识图谱(Knowledge Graph)等。本文档系大语言模型入门材料,因此主要关注NLP领域的技术。

-

从学术角度来看,人工智能有三大学派:符号主义(Symbolicism)、联结主义(Connectionism)、行为主义(Actionism)。

-

机器学习是人工智能的核心,现在最前沿的AI技术的主流算法都是基于神经网络和强化学习。

| 学派分类 | 符号主义 | 连结主义 | 行为主义 |

|---|---|---|---|

| 思想起源 | 数理逻辑:基于统计方法,通过建模预测让机器通过计算来模拟人的智能,实现识别、预测等任务 | 仿生学:生物智能是由神经网络产生的,可以通过人工方式构造神经网络,训练神经网络产生智能。 | 生物的智能来自对外界的复杂环境进行感知和适应,通过与环境和其他生物之间的相互作用,产生更强的智能。 |

| 代表算法 | 朴素贝叶斯,逻辑回归,决策树,支持向量机 | 神经网络 Neural Network | 强化学习 Reinforcement Learning |

1.2 机器学习

-

机器学习(Machine Learning,ML)是实现人工智能的核心方法,是从有限的观测数据中“学习”(or“猜测”)出一个具有一般性的规律,并利用这些规律对未知数据进行预测的方法。

-

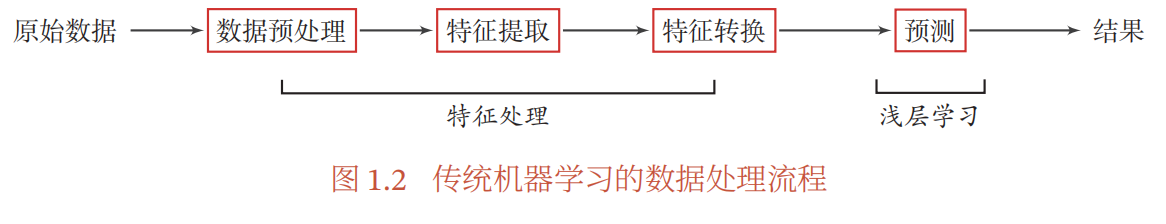

传统的机器学习主要关注如何学习一个预测模型,一般需要首先将数据表示为一组特征(Feature),特征的表示形式可以是连续的数值/离散的符号等形式。而后将这些特征输入到预测模型,并输出预测结果。这类机器学习可以看作是浅层学习(Shallow Learning),其重要特点是不涉及特征学习,其特征主要靠人工经验或者特征转换方法来提取。

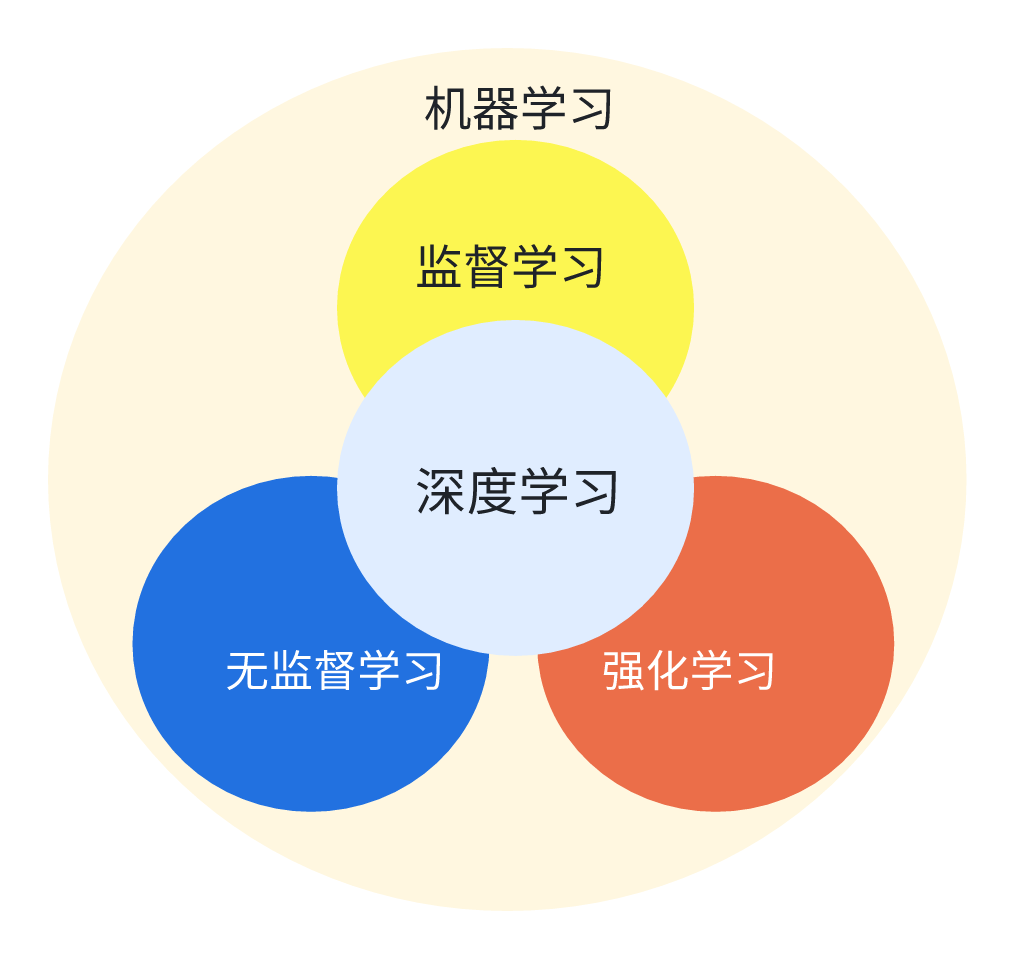

1.3 机器学习的分类:根据学习范式分类

根据学习范式的不同,机器学习可分为有监督学习、无监督学习、自监督学习和强化学习

1.3.1 有监督学习 Supervised Learning

1.3.1.1 有监督学习的基本定义

-

**有监督学习(Supervised Learning):机器学习中一种常见的学习范式,其基本思想是利用带有标签的训练数据来训练模型,从而使其能够从输入数据中学习到输入与输出之间的映射关系,然后可以利用这个映射关系对新的未标签数据进行预。 <***是不是很像人通过刷题的学习过程?带了标准答案的习题集去刷题,如果做错了就根据错误的原因反思改进。当新的题目到来时,便可根据过去刷题的经验来去写新的题目。*>

-

有监督学习的训练集要包括输入(特征)****输出(目标),其中,输出是人工标注的。

-

有监督学习的例子:训练一个模型用于识别一个公司的财务报表是否有财务舞弊:有1000份财务报表,每份报表上体现了资产负债率、现金流量等关键数据,我们用X指代。报表有500份舞弊的和500份没有舞弊的。

-

那么,我们就有一个1000个样本的训练数据集;X是每个训练样本的输入或者特征;样本是否舞弊则是由人工标注的输出或者**目标。**于每一份输入的训练数据,都是有一个确定的预期输出结果的,因此称为“有监督”。我们可以称这样的训练样本为“带标签的输入、输出对”。

-

利用这个训练数据集,我们对算法进行训练。整体而言,训练出了一个函数f(X),他“学习”了训练集中f(X1) = 舞弊,f(X2) = 正常,f(X3)=正常,f(X4) = 舞弊, ……,f(X1000)=舞弊的信息。当我们给出一份新的报表时,他也可以帮我们判断这个报表是舞弊的还是正常的了。

-

有监督学习的步骤如下:

1.3.1.2 有监督学习的典型应用

分类(Classification):预测输入样本属于哪个类别或者类别的概率分布。典型的例子包括垃圾邮件分类、图像分类等。

回归(Regression):预测输入样本的数值输出,通常是连续的实数值。典型的例子包括房价预测、股票价格预测等。

目标检测(Object Detection):在图像或者视频中检测出目标物体的位置和类别。例如自动驾驶中识别出道路上的车辆、行人、交通标志等;或者人脸识别中判断出哪一部分是人脸。

序列生成(Sequence Generation):根据输入的序列生成输出的序列,如机器翻译、音乐生成等。

序列标注(Sequence Labeling):序列标注是一种常见的机器学习任务,其中输入数据通常是序列数据,例如文本、语音、生物信息学等。有监督学习可以对输入的序列中的每个元素进行标签预测,如命名实体识别(Named Entity Recognition,NER,指自然语言处理中,能从文本中提取如人名、地名、组织名、日期、时间、金额等具有特定意义的实体或实体类别)、语音识别(Speech Recognition)等。

1.3.1.3 常见的有监督学习的算法

-

常见的有监督学习算法包括线性回归(Linear Regression)、逻辑回归(Logistic Regression)、决策树(Decision Trees)、支持向量机(Support Vector Machines)、随机森林(Random Forests)等。

-

这里提到的大多数算法我们都不��需要看,关注神经网络即可。

1.3.2 无监督学习 Unsupervised Learning

1.3.2.1 无监督学习的基本定义

-

**无监督学习(Unsupervised Learning)**机器学习中一种常见的学习范式,其目标是从未标记的数据中自动地发现数据中的结构、模式、关联或者表示,而无需使用人工标签或者先验知识的指导。

-

在无监督学习中,算法需要从数据中自动地进行学习,无需先知道数据的标签或者类别信息。无监督学习面临的挑战在于缺乏带有标签的训练样本来指导学习过程,因此需要自动地从数据中发现模式和结构。

-

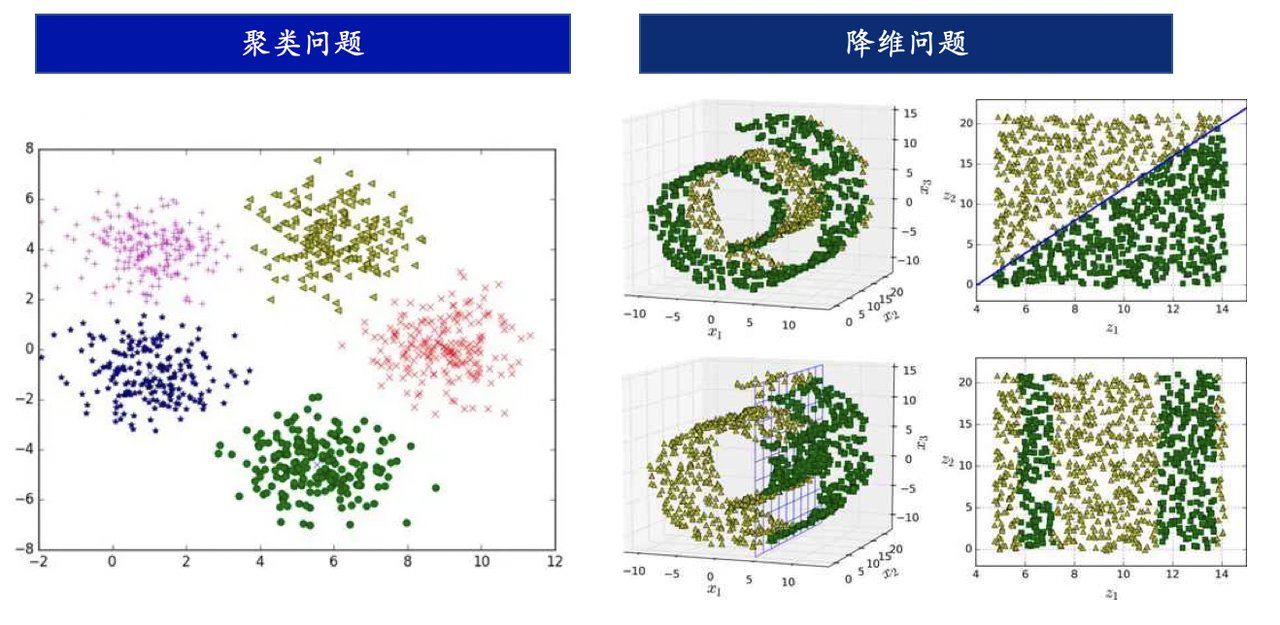

无监督学习的例子:根据购物习惯,对客户进行分类。假设有一大组顾客的购物数据,包括他们的购买金额、购买时间、购买商品等信息。这些数据并没有被事先标记或分类。通过应用无监督学习算法,如k-means聚类算法或层次聚类算法,我们可以自动识别出具有相似购物行为的顾客群体,并将他们分为不同的簇。这些簇可以对应于不同的消费习惯、购买偏好或市场细分,从而可以帮助企业了解顾客行为并作出相应�的业务决策。<这么听起来,无监督学习和数据挖掘是不是有一点像?>这里是一个聚类问题。

-

无监督学习的例子:压缩图片。图像通常由大量的像素点组成,每个像素点包含了图像的颜色信息。图像压缩的目标是通过减少图像中的冗余信息,从而减小图像的存储空间或传输带宽,同时尽量保持图像的质量。数据降维是图像压缩的一种方式,通过减少图像数据的维度来达到压缩的目的。无监督学习中的数据降维技术,如主成分分析(Principal Component Analysis, PCA)****自编码器(Autoencoder),可以用于图像压缩中。例如,PCA可以通过将图像数据投影到低维空间中的主成分上来实现图像的降维压缩。自编码器则可以通过学习图像的低维表示和重构图像来实现数据的降维和压缩。<图片压缩不是非得机器学习,但无监督学习确实可以实现图片压缩!>这里是一个降维问题。

1.3.2.2 无监督学习的典型应用

无监督学习的应用非常广泛,包括但不限于以下几个方面:

聚类(Clustering):将数据集中的样本根据相似性进行自动分类,形成不同的簇。典型的例子包括顾客分群、社交网络用户聚类等。

异常检测(Anomaly Detection):识别数据中的异常样本,这些样本与正常样本不同,可能是潜在的异常事件或异常行为。典型的例子包括反洗钱、信用卡欺诈检测等。

降维(Dimensionality Reduction):将高维数�据映射到低维空间,保留数据的主要信息,去除冗余和噪音。典型的例子包括图像压缩等。

关联规则挖掘(Association Rule Mining):从大规模数据集中发现频繁出现的关联规则,用于发现数据中的潜在关联关系。典型的例子包括购物篮分析、推荐系统等。

1.3.2.3 常见的无监督学习的算法

这里提到的大多数算法我们都不需要看。

常见的无监督学习算法包括聚类算法如K均值聚类(K-means clustering),降维算法如主成分分析(PCA)、t-SNE等,异常检测算法如基于密度的异常检测(Density-based Anomaly Detection)、基于距离的异常检测(Distance-based Anomaly Detection)等。无监督学习在许多实际应用中都有广泛的应用,如图像处理、自然语言处理、推荐系统等领域。

后文会重点提及以下的无监督学习算法类型:

- 嵌入学习(Embedding Learning):例如词嵌入(Word Embedding)。

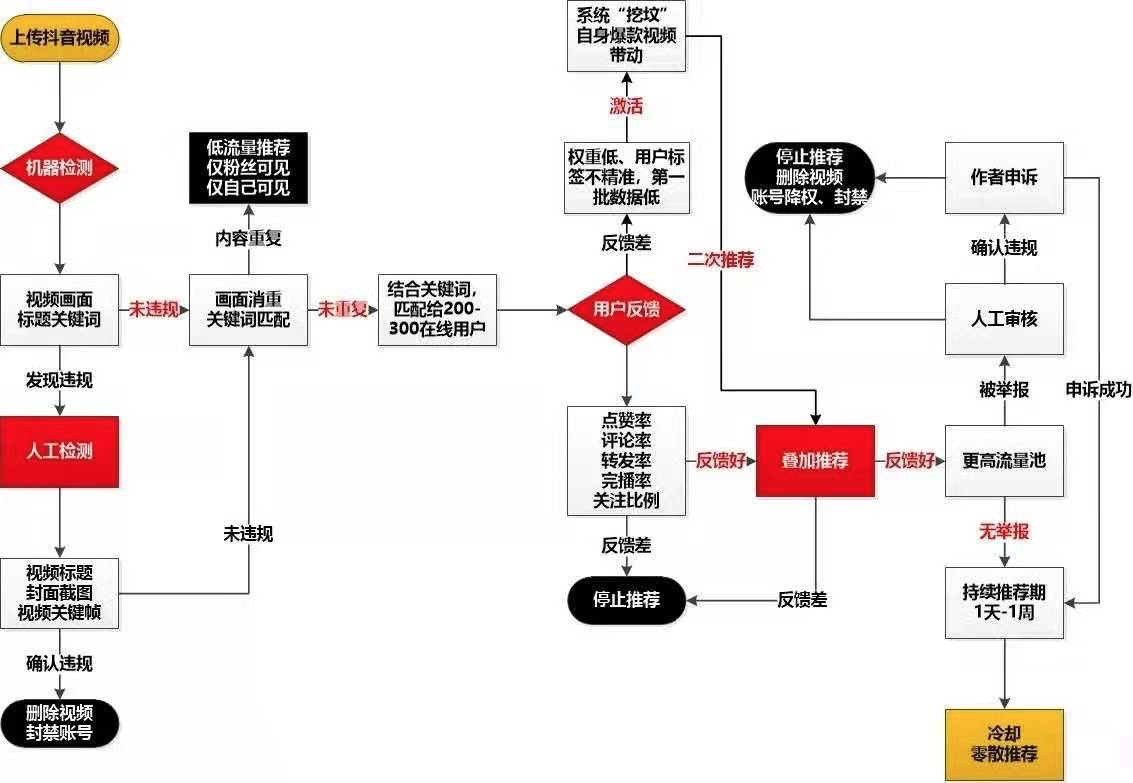

1.3.3 Tik Tok推荐算法:一个有监督学习与无监督学习并用的例子

无监督学习和有监督学习都是机器学习的范式,两者经常在同一个算法��中被一同使用。

-

TikTok等产品中使用的推荐算法通常是基于机器学习技术,包括了一系列的无监督学习和监督学习方法。

-

**在推荐系统中,无监督学习方法可以用于从大量的未标记数据中学习用户行为模式、内容特征等信息,从而为用户提供个性化的推荐。**如,TikTok的推荐算法可能通过无监督学习方法,如聚类(Clustering)、降维(Dimensionality Reduction)等,对用户上传的大量视频数据进行分析和处理,从中提取出视频的特征,如视频的内容、情感、时长等,并根据用户的观看历史、行为偏好等信息,将相似的视频聚类在一起,从而实现相似内容的推荐。

-

***监督学习方法也常常用于推荐算法中,通过使用标记的样本数据,***用户的历史行为数据(如点击、点赞、评论等)和用户的反馈(如用户的喜好、兴趣等),来训练模型进行推荐预测。

<上图中,哪些部分需要用到有监督学习,哪些部分要用到无监督学习,哪些部分需要人工介入呢?>

综上,TikTok等产品中使用的推荐算法通常是综合应用了多种机器学习技术,包括无监督学习和监督学习方法,通过从大量数据中学习用户兴趣和内容特征,为用户提供个性化的推荐体验。

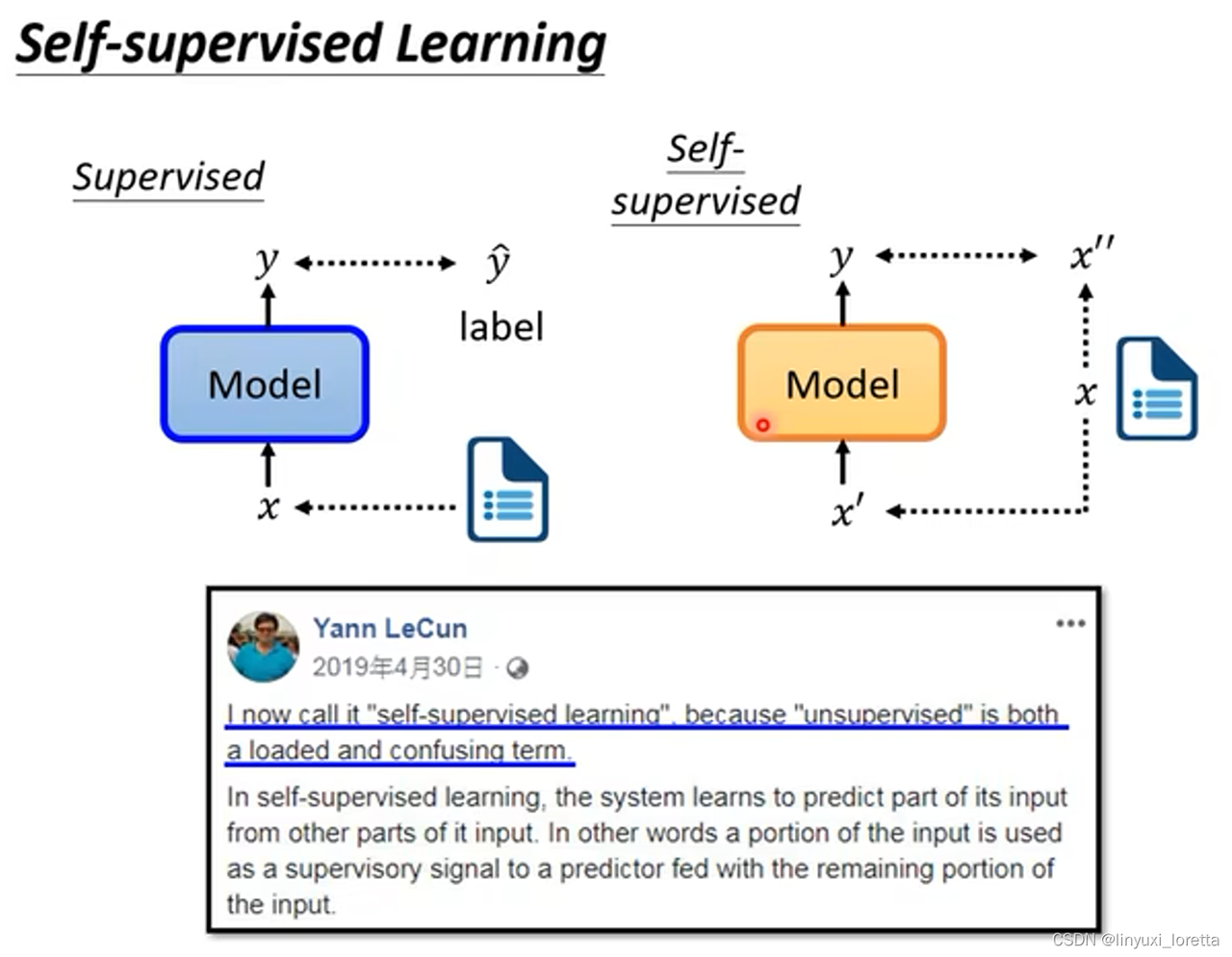

1.3.4 自监督学习 Self-supervised Learning

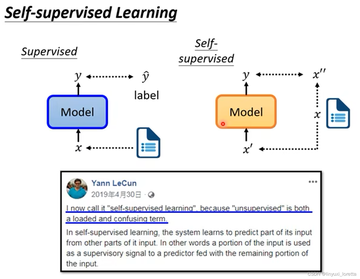

自监督学习本身是无监督学习��的一种范式,因为它也不需要人工去打标签;但在体现出来的能力上,自监督学习和无监督学习非常不一样,因此在这里做单独介绍。

- 自监督学习主要是利用辅助任务(Pretext)从大规模的无监督数据中挖掘自身的监督信息,通过这种构造的监督信息对网络进行训练,从而可以学习到对下游任务有价值的表征。

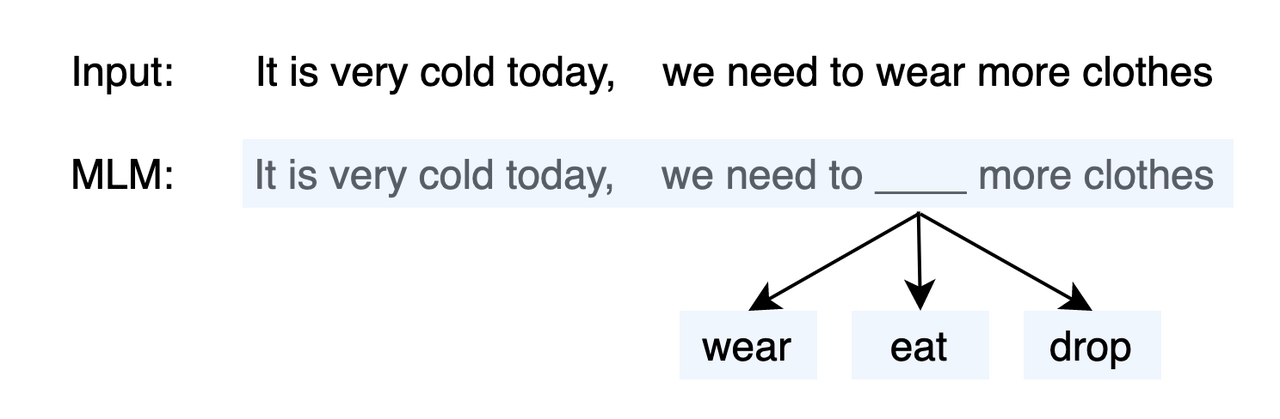

这样写会比较抽象,但可以参考下图:

左图展示了自监督学习和有监督学习的区别:例如,一段文字:“白银说的话就像是一位癌症晚期患者说的话。他都已经这样了,你为什么不顺从他,你总得给人留一段美好的回忆吧,最后的时光里。”,一个有监督任务就是判断这句话是否有害。这句话当然有害,但机器不可能自动学习出它有害,我们需要人工给他打上“有害”的标签。

但如果是无监督学习任务,例如完形填空,机器就可以这么做:把上面这段文字先变成“白银说的话就像是一位癌症晚期患者说的话。他都【Masked】经这样了,你为什么【Masked】顺从他,你总得给人留一段美好的回忆吧,最后的时光里。”输入给模型,要求模型去预测两个被遮掩的词是什么。而被遮住的这两个词是一个Ground Truth,它不需要任何人做判断,根据输入给机器的原文我们就知道这两个Masked标识对应的得是“已”和“不”。这样一来,机器就可以根据一个预训练任务,对输入的样本自动产生新的输入x',自动产生标注x'',并且用于学习了。

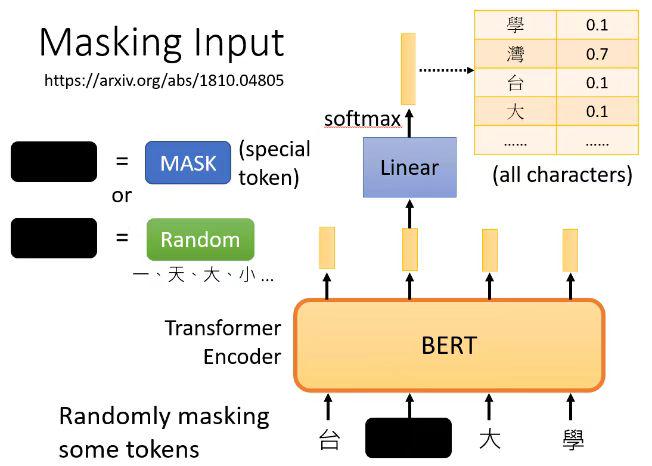

右图是BERT中的一个自监督学习的应用:输入“台湾大学”后,机器随机的遮住了一个词,这里遮住了“湾”。而后机器要去做“预测这个被遮住的词应该是什么”的任务,而且任务的标准答案机器当然知道,就是“湾”字。因此,机器就可以自动比较自己输出的答案和标准答案差在哪儿,从而去更正自己了。

不要看自监督学习好像很容易理解,事实上它是一个非常天才的想法。这件事后续的第八章中,我们会首次接触到自监督学习。

1.3.5 强化学习 Reinforcement Learning

后面会有一个专门的章节介绍强化学习,所以这里只需要了解一个大概!

1.3.5.1 强化学习的基本定义

-

强化学习(Reinforcement Learning)是一种机器学习方法,用于通过玩家(Agent)与环境(Environment)的交互来学习如何做出合适的决策,以最大化预期的累积奖励。

-

在强化学习中,Agent通过与环境的相互作用,观察环境的状态(State),执行不同的动作(Action),接收环境的反馈(奖励信号,奖励Reward),并根据反馈来调整其行为策略(Policy),从而逐渐学习如何在不同的环境中做出最优的决策。

强化学习的关键��特点包括以下几点:

-

**Environment和State:**化学习中的Agent与Environment进行交互,Agent通过观察Environment的State来感知环境的变化并进行决策。(eg. 我们开车的时候与我们所看到的路况进行交互,根据路上的行人、其他汽车、指示牌等的状态,选择怎么去打方向盘。那么整个汽车所在的公路就是Environment,公路上具体的路况就是State)

-

Action和Policy:Agent可以采取不同的Action来影响Environment的State。那么在什么样的State下,Agent要采取什么样的Action?Agent是基于一定的策略Policy来选择要执行的Action的,而这个Policy往往是一个以当前State为自变量,要执行的Action为输出的一个函数。(eg. 我们在路上怎么打方向盘,就是Action。在什么样的路况下我们会怎么去打方向盘,就是Policy。我们打方向盘这件事情会影响环境的状态;而环境的状态改变又会返回来决定我们该怎么打方向盘。)

-

Reward和Goal:环境向Agent提供奖励信号,用于反馈Agent的行为质量。Agent的目标是通过最大化预期的累积奖励,以此来学习如何做出最佳决策。(eg. 路边的其他车会向你打鸣告诉你你开的不好,违规了的话交警会对你处罚,这就是一个负的Reward。你的Goal可能是以最快的速度最安全、不违规的到达目的地,你通过不断的与环境交互,学习出一个最佳的开车Policy,从而实现这个目标。)

-

试错学习和优化:强化学习中的Agent通过与环境的交互来不断学习和优化其策略,这是一个不断试错的过程,State和Action之间的往复交互是强化学习的主体部分,所以是Trial and Error Learning。强化学习的最终目标是一个好的策略。

-

价值决定策略:价值,就是预期将来会得到的所有奖励之和。(eg. 下围棋的时候,如果一步棋决定了胜局,那么这步棋就特别有价值!)<价值有两个函数——State Value Function和Action Value Function, 这里先不细说,后面有专门的章节来介绍强化学习及其简单的数学表示!>

强化学习不要求预先给定任何数据,而是通过接收环境对动作的奖励(反馈)获得学习信息并更新模型参数。

强化学习是除了监督学习和非监督学习之外的第三种基本的机器学习方法。与监督学习不同的是,**强化学习不需要带标签的输入输出对,同时也无需对非最优解的精确地纠正。**关注点在于寻找探索(对未知领域的,Exploration)和利用(对已有知识的,Exploitation)的平衡。后文会详细去讲Exploration vs Exploitation的Trade-off,此处先快速跳过。

1.3.5.2 强化学习的典型应用

-

自动驾驶车辆:强化学习在自动驾驶领域中也得到了广泛应用,例如通过训练智能车辆在不同道路条件下学习驾驶策略,包括避免碰撞、减少能耗等。(自动驾驶中既要用有监督学习的图像识别技术去理解当前的State,又要用RL的技术去不断优化驾驶策略)

-

游戏与游戏玩家:强化学习被广泛用于电子游戏中,例如通过训练智能代理在复杂的游戏环境中进行游戏策略决策,如围棋、国际象棋等。同时,强化学习还可以用于训练游戏中的虚拟角色,使其能够自主学习和优化其行为策略。(eg. AlphaGo)

-

机器人控制:强化学习在机器人领域中有广泛的应用,包括自主导航、机器人手臂控制、�无人机控制等。通过强化学习,机器人可以从与环境的交互中学习控制策略,以完成复杂的任务。

1.3.5.3 常见的强化学习的算法

强化学习的算法整体分为价值学习、策略学习、Actor-Critic Method. 后面再讲!

1.4 机器学习的分类:根据网络的深度和复杂性分类

1.4.1 浅层学习(Shallow Learning)

浅层学习通常指的是使用较少层次、较简单结构的机器学习模型,例如传统的线性回归、逻辑回归、决策树、支持向量机等。这些模型通常只有一层或者很少的层,且每一层的特征表示较为简单和浅显,不具备较强的抽象能力。

1.4.1.1 浅层学习的基本定义

-

浅层学习(Shallow Learning),也称为表面学习或者传统学习,是一种机器学习方法,其主要通过构建浅层的、较简单的模型来进行模式识别、分类、回归等任务。

-

浅层学习方法通常包括传统的统计学习方法,如逻辑回归(Logistic Regression)、决策树(Decision Tree)、支持向量机(Support Vector Machine)、朴素贝叶斯(Naive Bayes)等,以及一些非线性模型,如K近邻(K-Nearest Neighbors)和随机森林(Random Forests)等。这些方法通常基于人工设计的特征(即特征工程),通过对特征进行处理和选择来构建模型,并利用这些模型进行预测和分。**

-

相对于深度学习(Deep Learning)而言,浅层学习通常采用较简单的模型架构和较少的层次结构,不涉及复杂的深层神经网络结构。

浅层学习最大的特点就是特征是人工设计的,通过特征工程,去依据原始数据,决定模型的输入。

1.4.1.2 特征(Feature)

-

特征(Feature),是指从原始数据中提取出的、用于表示样本的属性或信息。(eg. 想起有监督学习任务里我们提到的财务舞弊识别的例子了吗?一份财务报表有一堆信息,机器是看不懂的。我们可能会利用财务报表,计算出资产负债率、流动比率指标,作为浮点数输入给机器。那么资产负债率和流动比率就是我们选出来的财务报表的特征!)

-

在机器学习模型中,特征被用作模型的输入,用于表示样本的不同属性,从而�帮助模型进行学习和预测。因此,首先要将数据表现为一组特征,而后才能将其输入,进行机器学习。

-

特征说白了就是你基于原始信息,具体给机器喂了些什么。

1.4.1.3 特征工程(Feature Engineering)

特征工程(Feature Engineering)是指在机器学习和数据挖掘中,通过对原始数据进行处理、转换和提取,生成新的特征或选择合适的特征,从而改进模型性能和提高预测准确性的过程。

Eg. 如果想要建立起一个识别财务报表是否舞弊的模型:f(财报的特征)=是否舞弊,那么输入给模型的参数的选择有很多:资产负债率、盈利质量、流动比率、速动比率等等。

那么选择哪些参数、输入多少参数输入给模型,其实都会对模型最后的识别性能有很高的影响。这个挖掘和选择特征的过程就是特征工程。

1.5 深度学习(Deep Learning)

在解释什么是深度学习之前,我希望先讲清楚表征与表征学习。

1.5.1 表示/表征(Representation)

表示(Representation)则通常指的是将数据以某种形��式进行编码或者表示的方式,可以是在特征空间中的表示,也可以是在其他空间中的表示。在深度学习中,表征通常是由模型自动学习得到的,例如通过神经网络的隐藏层进行特征提取和表示学习(后面讲MLP的时候就会提到)。这种自动学习的表现通常比手工设计的特征更能够捕捉数据中的复杂模式和关系,从而提升模型的性能。

1.5.2 局部表示 Local Representation

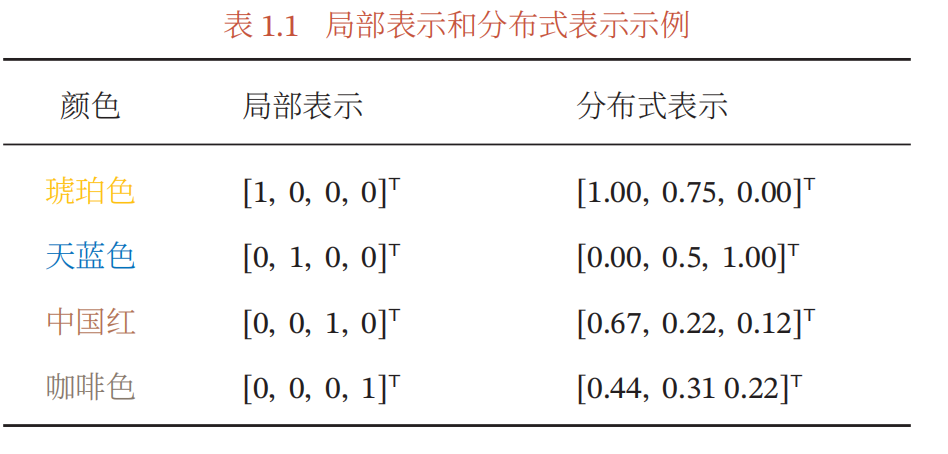

局部表示,也称为离散表示或符号表示。 以颜色表示为例,我们可以用很多词来形容不同的颜色1,除了基本的“红” “蓝”“绿”“白”“黑”等之外,还有很多以地区或物品命名的,比如“中国红”“天蓝色”“咖啡色”“琥珀色”等.如果要在计算机中表示颜色,一般有两种表示方法.如果以不同名字来命名不同的颜色,这种表示方式叫作局部表示。

局部表示通常可以表示为One-hot向量的形式,假设假设所有颜色的名字构成一个词表 𝒱,词表大小为 |𝒱|.我们可以用一个|𝒱|维的one-hot向量来表示每一种颜色.在第𝑖种颜色对应的one-hot向量中,第𝑖 维的值为1,其他都为0.

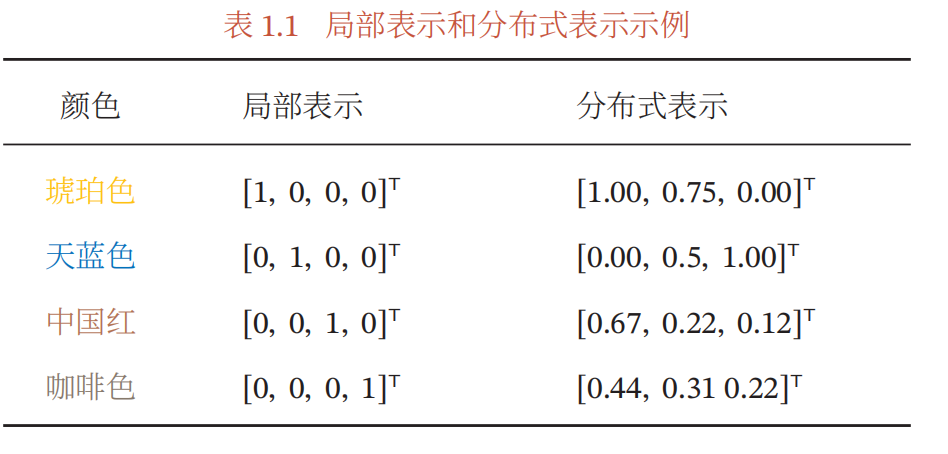

例子参考下表,展示了琥珀色、天蓝色、中国红、咖啡色的局部表示方式。

在后续讲到自然语言处理时,就会提到,早期的语言模型中我们主要用one-hot向量来作为词汇的表征。

局部表示有两个优点:

1)这种离散的表示方式具有很好的解释性,有利于人工归纳和总结特征,并通过特征组合进行高效的特征工程��;

2)通过多种特征组合得到的表示向量通常是稀疏的二值向量,当用于线性模型时计算效率非常高.

但局部表示有两个不足之处:

1)one-hot向量的维数很高(维度爆炸),且不能扩展.如果有一种新的颜色,我们就需要增加一维来表示;

2)*不同颜色之间的相似度都为0,因为这些向量全部正交。*我们无法知道“红色”和“中国红”的相似度要高于“红色”和“黑色”的相似度。

1.5.3 分布式表**(Distributed Representation)**

分布式表示是一种将数据表示为多维向量的方法,其中每个维度都包含有关数据的一部分信息。

例如,我们用RGB值来表示颜色,不同的颜色对应到R、G、B三维空间中一个点,这种表示方法即为分布式表示。分布式表示通常可以表示为低维的稠密向量,参考上图。

分布式表示在深度学习中得到广泛应用,例如在神经网络中使用嵌入层(Embedding Layer)对输入数据进行分布式表示(嗯,后面学到词向量的时候就会用到了)。

相比于让所有颜色的名字构成一个词表 𝒱,我们现在用一个三维的向量就可以表示出所有的颜色了。

此外,不同的颜色之间的相似度也变得很容易计算,只需要去算他们的余弦相似度/欧式距离等就可以了。

分布式表示具有许多优势,例如能够更好地捕捉数据的多样性、泛化性能较好、能够处理未知数据等。例如,在自然语言处理中,分布式词向量(如Word2Vec、GloVe等)将单词表示为多维向量,每个维度都包含了单词在不同语义和语法属性上的信息,从而在词汇表很大的情况下,能够更好地表示单词之间的语义和语法关系。

1.5.4 表征学习(Representation Learning)

-

**表征学习(Representation Learning)是一种自动化地从原始数据中学习有效的特征表示的方法。**通过深度神经网络等模型,从原始数据中自动学习层次化、抽象化的特征表示,而无需手工设计特征。表征学习能够从数据中提取出更丰富、更高级的特征,从而更好的描述数据,有助于提高模型的性能和泛化能力。

-

要学到一种好的高层语义表示(一般是分布式表示),通常需要从底层特征开始,经过多步骤的非线性转换才能得(之所以要是非线性,是因为连续多次的线性转换归根到底还是等价于一次线性转换)。表征学习与深度学习天然相关,因为深度神经网络所具有的深层结构的优点是可以增加特征的重用性,从而指数级的增加表示能力。因此,表征学习的关键是构建具有一定深度的多层次特征表示。

1.5.5 深度学习的定义

-

深度学习是一种使用深层次、复杂结构的神经网络模型进行学习的方法。深度学习模型通常有多个层次(通常超过3层)的神经元组成,每一层的输出作为下一层的输入,从而形成层层叠加的结构。深度学习模型可以通过在多个层次上学习到更加抽象和高级的特征表示,从而能够更好地捕捉数据中的内在结构和特性。

-

为了学习一种好的表示,需要构建具有一定“深度”的模型,并通过学习算法来让模型自动学习出好的特征表示(从底层特征,到中层特征,再到高层特征),从而最终提升预测模型的准确率。所谓“深度”是指原始数据进行非线性特征转换的次数.如果把一个表示学习系统看作一个有向图结构,深度也可以看作从输入节点到输出节点所经过的最长路径的长度.

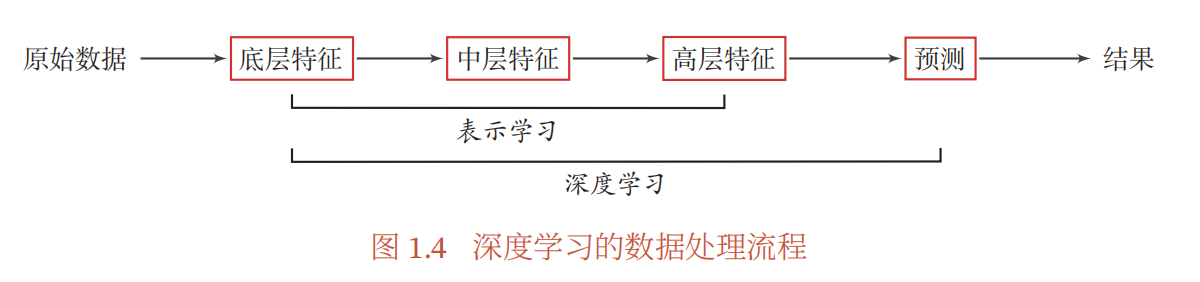

- 图1.4给出了深度学习的数据处理流程.通过多层的特征转换,把原始数据变成更高层次、更抽象的表示.这些学习到的表示可以替代人工设计的特征,从而避免“特征工程”.

嗯,按照邱锡鹏老师的说法,深度学习可以通过底层特征、中间特征、高层特征的表示学习,去避免浅层学习中在做特征处理(特征提取、特征选择)时的特征工程的。

1.5.6 端到端学习(End-to-End Learning)

1.5.6.1 传统机器学习:多个子模块

- 在一些复杂任务中,传统机器学习方法需要将一个任务的输入和输出之间人为地切割成很多子模块(或多个阶段),每个子模块分开学习。比如一个自然语言理解任务,一般需要分词、词性标注、句法分析、语义分析、语义推理等步骤。

这种学习方式有两个问题:

-

一是每一个模块都需要单独优化,并且其优化目标和任务总体目标并不能保证一致;

-

二是错误传播,即前一步的错误会对后续的模型造成很大的影响.这样就增加了机器学习方法在实际应用中的难度.

1.5.6.2 端到端学习(End-to-End Learning)的定义

端到端学习,也称端到端训练,是指在学习过程中不进行分模块或分阶段训练,直接优化任务的总体目标.在端到端学习中,一般不需要明确地给出不同模块或阶段的功能,中间过程不需要人为干预.端到端学习的训练数据为“输入-输出”对的形式,无须提供其他额外信息.因此,端到端学习和深度学习一样,都是要解决贡献度分配问题.目前,大部分采用神经网络模型的深度学习也可以看作一种端到端的学习.

简单的说,可以把端到端学习理解为,处理一��个复杂的任务时,我们不做任务拆分,而是把它整个作为一个巨大的黑箱,我们只关注输入和输出对,并基于输出情况对这个黑箱进行调整。

2. 入门:多层感知器 Multiple-Layer Perceiver, MLP

大量借鉴3Blue1Brown

2.1 神经网络概述:从MNIST手写数据集开始

2.1.1 语义鸿沟:为什么让机器产生智能这么难?

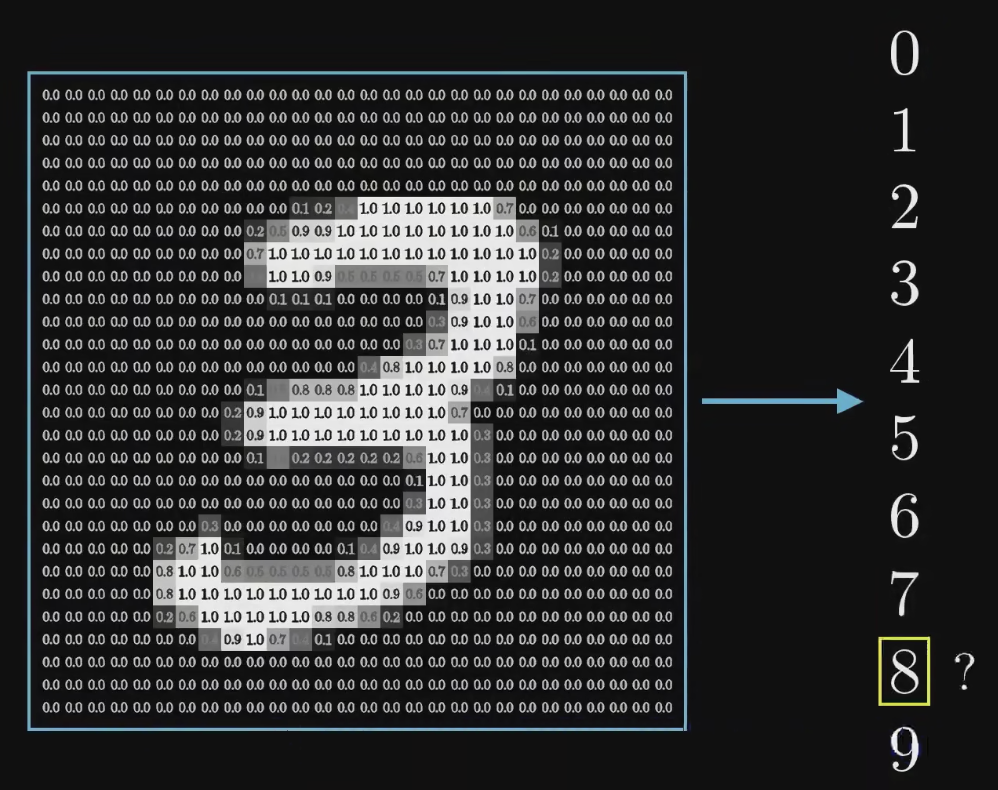

下面是几个手写的数字,像素非常低。人脑可以很轻易的看出来这些数字是3、7、6,但让计算机去识别出手写的数字和文字,却一直是个老大难题。

更鬼扯的事情是,上图中的两个数字3,投射到人的视网膜中之后,可以说是非常不一样,但人脑就是可以认识到,这两个手写的数字都是3。

尽管人眼可以很轻易的去手写的数字,但如果我们把随便一张由人来手写的个位数字扔给计算机,让计算机从0~9中判断出来我们写的数字是哪一张,这件事就会变得非常困难。人类通过视觉感知能够轻松地理解图像中的内容(一张手写的3;一张路况图里的指示灯,行人和汽车),包括物体、场景、语义信息等,并能够从图像中提取高级语义特征,如物体的形状、颜色、纹理、空间关系等;但是,计算机在处理图像时通常只能看到一些低级的视觉特征,如像素值、颜色直方图、边缘等,并且缺乏对图像高级语义信息的理解能力。我们称这种人机差异为“语义鸿沟(Semantic Gap)”。

2.1.2 MNIST手写数据集的特征:把一张图表示为一个784维的向量

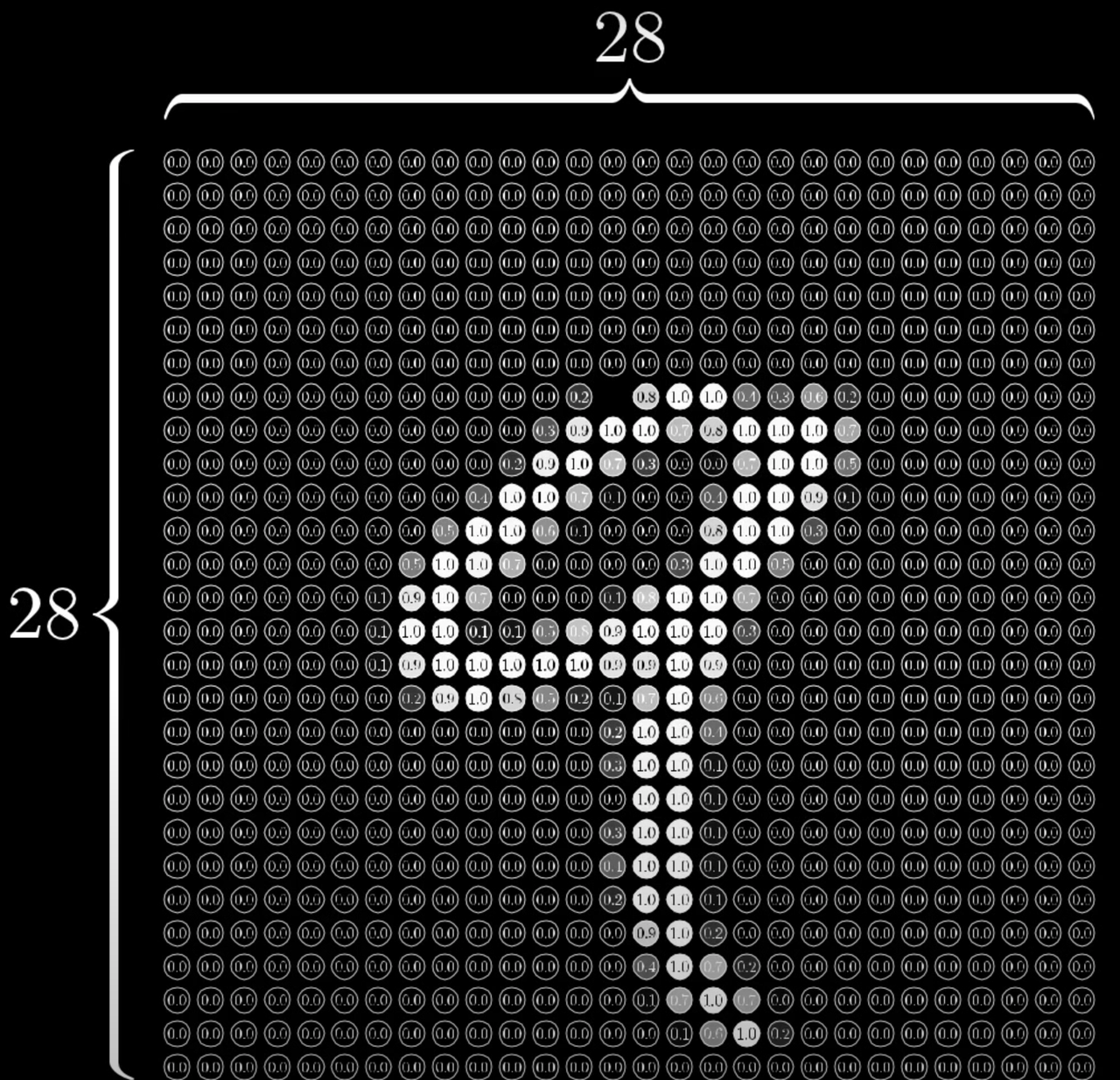

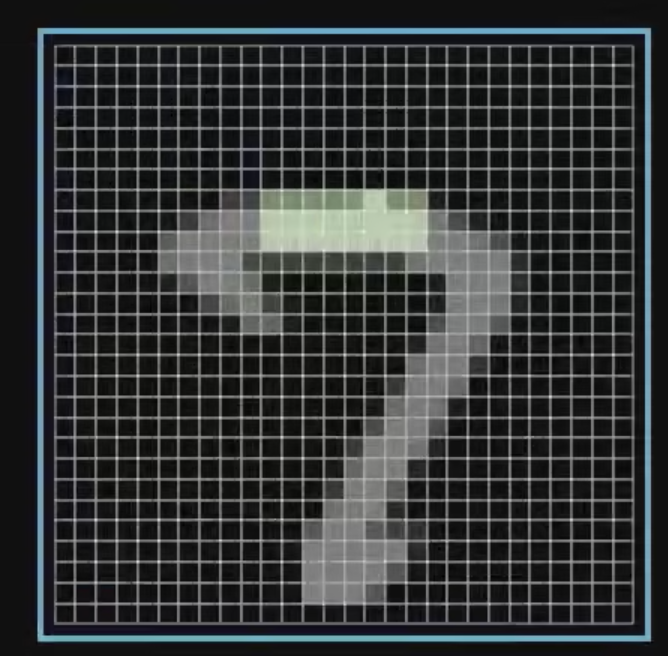

对于一张黑白的手写的数字,我们应该以什么作为它的特征,输入给机器让他学习呢?答案是,构成这张图的28*28=784个像素点的灰度!对于每一个像素,我们都给他赋一个从0到1的值。一个像素点越黑,他就越接近0;一个像素点越白,他就越接近1。那么……

图源是3Blue1Brown的视频。其实很多东西,不管是图像,还是语音,本质上都可以拆分为许多许多个小块。

当我们用机器学习来解决实际任务时,会面对多种多样的数据形式,比如声音、图像、文本等,不同数据的特征构造方式差异很大。对于图像这类数据,我们可以很自然的将其表示为一个连续的向量。对于这个手写数字的例子,我们就很自然的按照像素点,把图像表达成了一个784维、每个元素都是介于0到1之间的实数的向量!

嗯,结论就是,这一张图被我们表示为了一个784维的、每个元素都在0到1之间的向量,接下来我们会把这个向量输入给神经网络的第一层,后者相应的会有784个神经元!但是什么是神经元呢?

2.1.3 什么是神经元(Neuron)?

2.1.3.1 机器学习中的神经元是对人脑的神经细胞的一种模仿

大脑的神经细胞(也称为神经元)可以产生认知,因为它们通过复杂的网络连接和相互作用,形成��了高度结构化和动态的神经网络,能够处理和整合信息,产生复杂的认知功能。神经元和神经网络其实是对人脑结构的一种模仿。人脑中,神经元或神经细胞是构成大脑、脊髓和周围神经系统的基本单元,神经元通过在树突接收神经信号,经过细胞体的处理和集成,然后通过轴突传递神经信号到其他神经元或效应器,从而完成神经系统内的信息传递和处理,形成了复杂的神经网络。

2.1.3.2 神经元是人工神经网络的基本构成单位,本质上是一个函数的组合,包括了输入加权和求和操作以及激活函数(Activation Function)

-

神经元(或称为人工神经元,Artificial Neuron)是一种数学模型,用于模拟生物神经元的计算单元。神经元通常作为神经网络的基本组成单位,用于构建人工神经网络(Artificial Neural Networks, ANN)。在这个手写数字的案例中,我们可以先把神经元视为一个装着0~1的数字的容器。

-

在机器学习中,神经元通常表示为一个接收输入数据的函数,对输入数据进行处理,并生成输出。

-

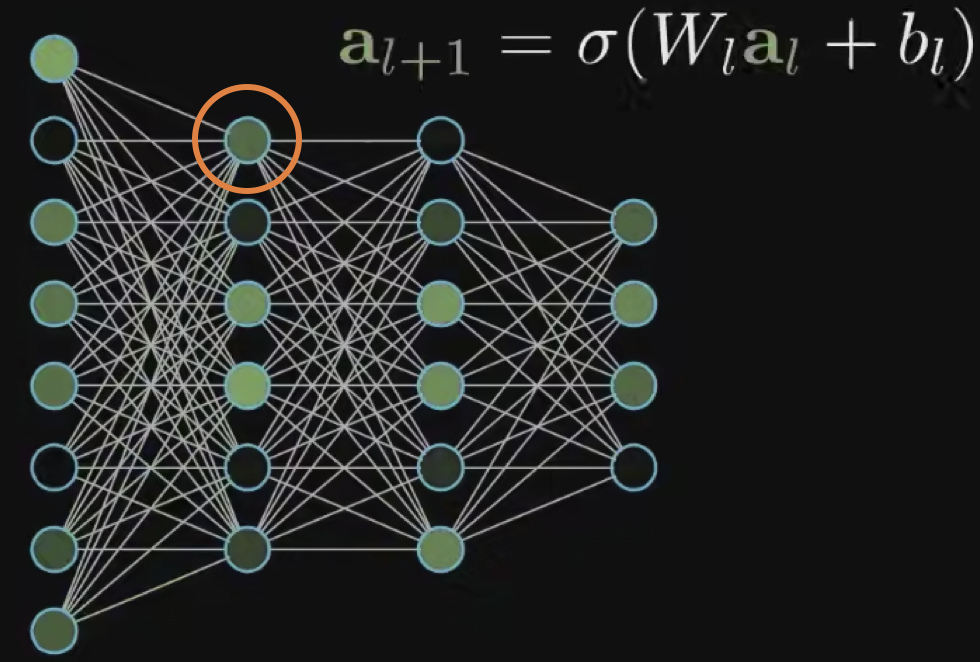

神经�元接收多个输入值(通常用向量表示),对输入值进行加权求和;然后通过一个激活函数(Activation Function)进行非线性映射,生成神经元的输出。

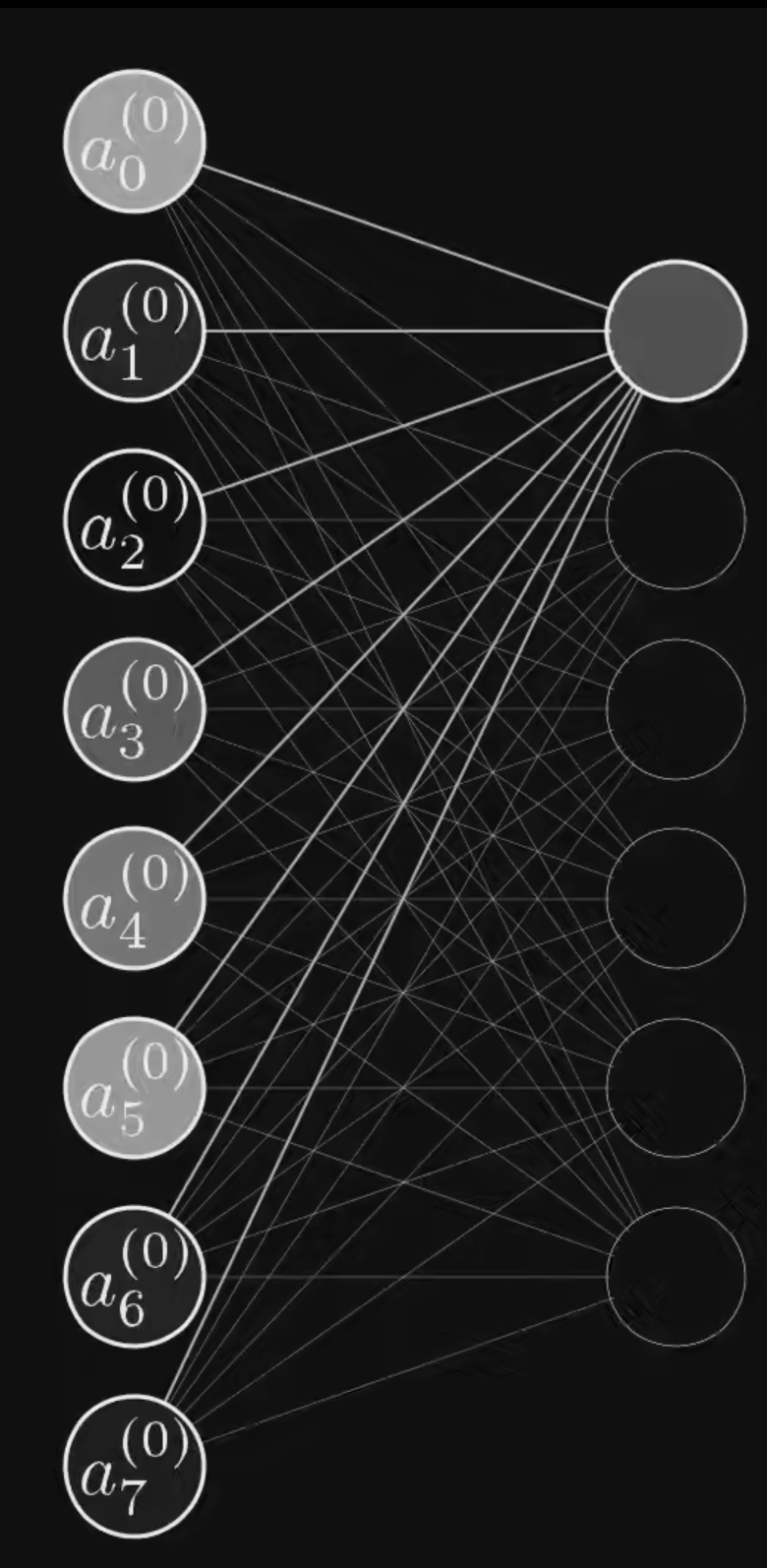

Q:什么是加权求和?

A:参考上面这张图,橙色的圈圈住了的这个神经元a9,连接了上一层的8个神经元a1~a8。那么,a1~a8里装着的数字都会被输入到a9里去。对于a1~a8的每一个值,神经元a9都会为其赋予一个权重w1~w8。那么,神经元a9的加权求和即为:。这称为神经的加权输入/激活前的值(Weighted sum)。

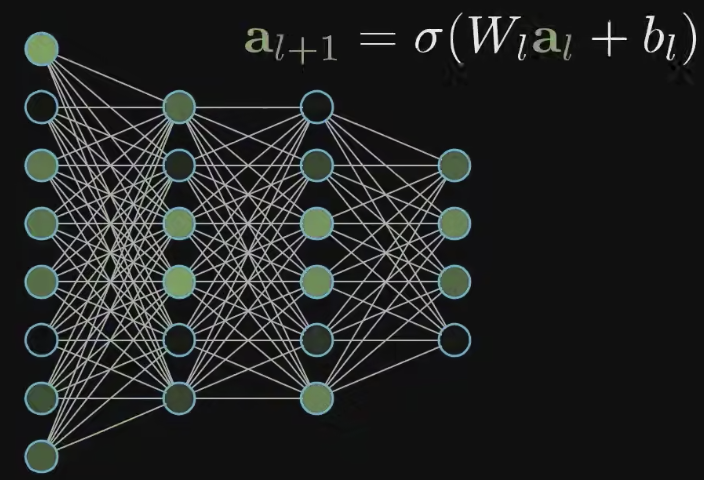

OK,现在回过头看看这张神经网络。上面的每条线,都代表一个权重!

这么看的话,每一个神经元都和其上一层的所有神经元相连;而权重的大小,则形容了连接的强弱!!

Q:什么是激活函数?

A:激活函数通常作用于神经元的加权输入/激活前的值(weighted sum),并产生一个非线性的输出值,作为神经元的激活状态,用于传递给下一层神经元或作为输出层的最终输出。

常用的非线性函数包括:

-

Sigmoid函数:将输入映射到[0, 1]之间,常用于二分类问题或者作为输出层的激活函数。

-

Tanh函数:将输入映射到[-1, 1]之间,也常用于二分类问题或者作为输出层的激活函数。

-

ReLU函数(Rectified Linear Unit):将负��数输入映射为0,保留正数输入,常用于隐藏层的激活函数。

-

Softmax函数:将输入映射为概率分布(输出的向量的每一个值都为正而且元素之和为一)。常用于多分类问题的输出层。

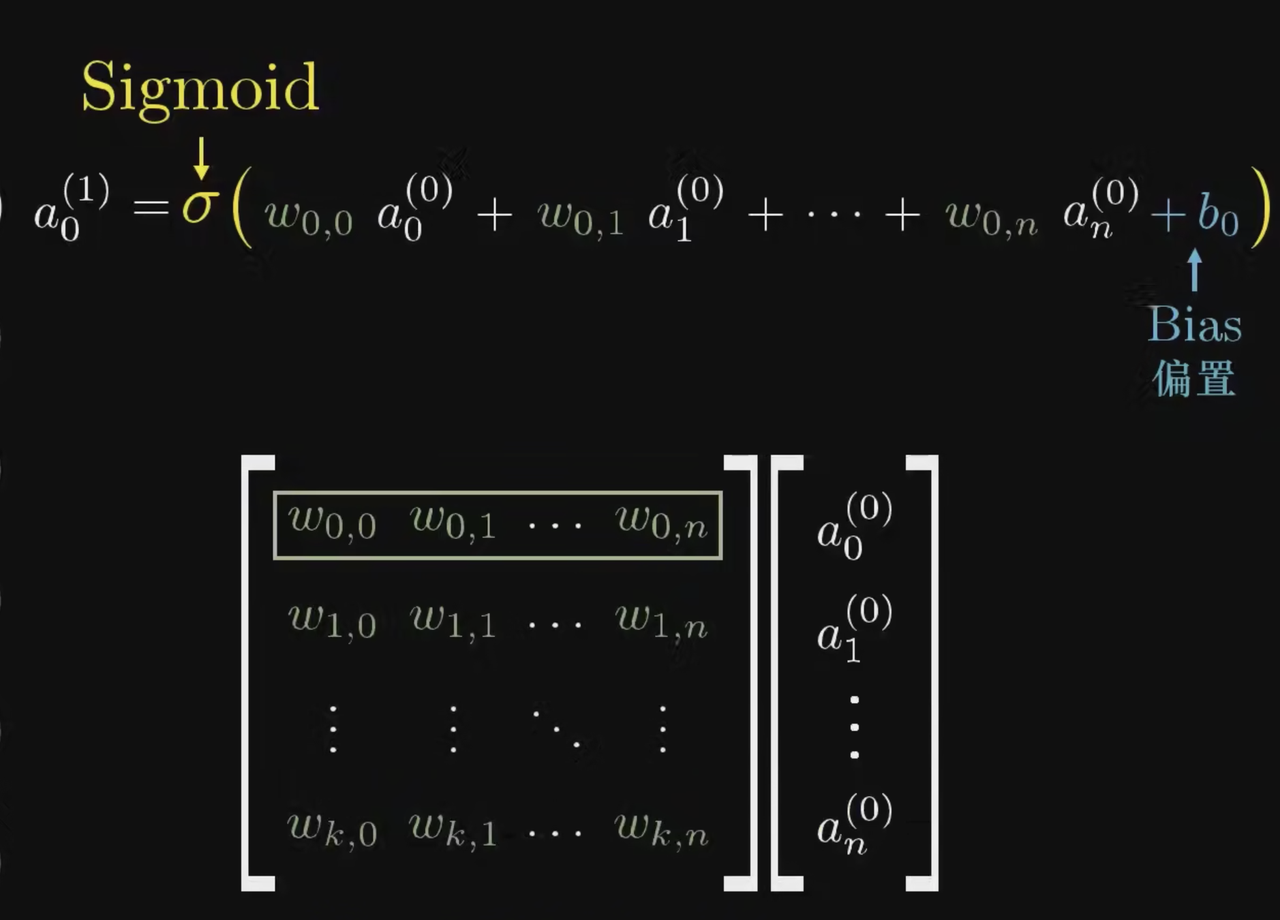

在手写的例子中,我们可以先用Sigmoid函数,那么神经元a9之中发生的事情就为:,其中

是对括号内的数字进行Sigmoid运算的意思。这里多出来了一个b,我们称之为偏置(Bias),因为我们希望加权之和足够大,才可以让一个神经元得到激活。

嗯,那么上图的神经网络中,除了第一层外的那16个神经元,每人都有一个自己的偏置!

Q:为什么一定要做非线性变换?

A:激活函数引入了非线性操作,使得神经网络可以更好地拟合复杂的非线性关系。如果神经网络只使用线性激活函数,那么整个网络将只是多个线性操作的组合,无法处理非线性数据或者学习非线性映射。

神经元的输出可以作为后续神经元的输入,从而构成了神经网络的层次结构。通过在神经网络中连接大量的神经元,并通过训练来优化神经元之间的连接权重,人工神经网络可以在大量数据上进行学习和预测,广泛应用于机器学习和深度学习任务,如图像识别、语音识别、自然语言处理等。

2.1.4 神经网络的结构

2.1.4.1 输入层和输出层:非常好理解

-

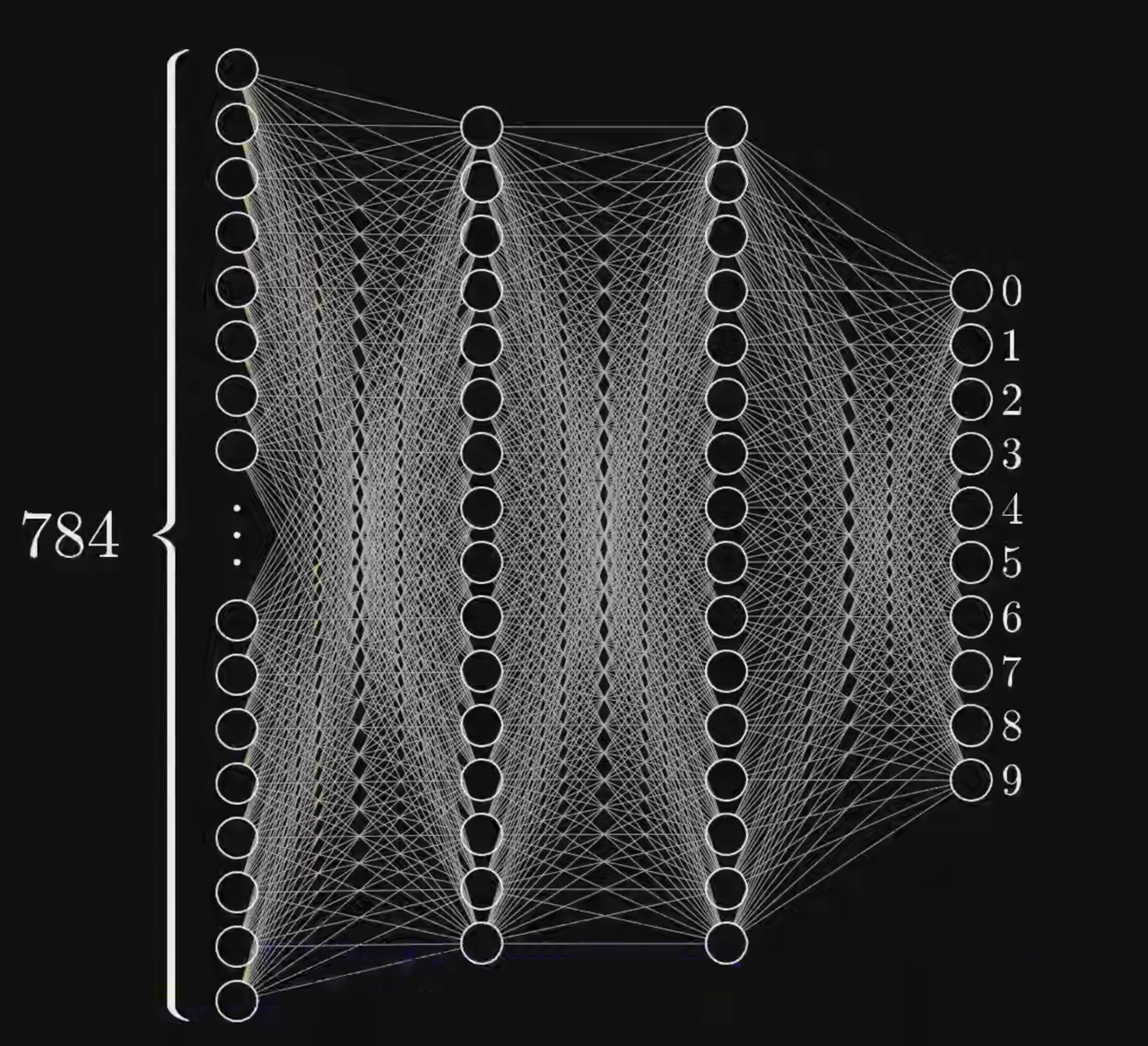

在前面的2.1.2里我们提到了,我们把一张手写的数字表示成了一个784维的向量,那么我们给向量的每一个元素都匹配一个神经元,那么输入层就有了784个神经元。输入层负责接收输入数据。

-

因为我们要做一个0~9的数字的输出,所以输出层有10个神经元。输出层负责产生网络的输出。对于上述的这个神经网络,最后0~9对应的每个神经元都会有一个值的大小,我们可以选择值最大的神经元对应的数字进行输出。

2.1.4.2 但是什么是隐层?

在人工神经网络 ANN中,**隐层(Hidden Layer)是位于输入层和输出层之间的一层或多层神经元的集合。**为神经网络中的中间层,隐层负责对输入数据进行特征提取和转换,从而实现复杂的非线性映射关系。

-

我们做了一个非常随意的设定:在输入层和输出层之间,加入两个隐层(Hidden Layer)。每一个隐层有16个神经元,然后我们让每层的每一个神经元都和上一层的所有神经元都相连,就形成了如图的网状结构。如果两层之间,每层的每一个神经元都和另一层的所有神经元都相连,那么我们便称之**“全连接层**”(Fully Connected Layer)。后面我们还会陆陆续续认识卷积层、池化层、循环层、嵌入层和规范化层,全连接层是我们我们认识的第一个神经网络的层!

-

图中这么多的线,每一条都代表了一个权重,一共有784*16+16*16+16*10=12960个权重参数!

-

图中除了输入层外,有42个神经元,所以一共有42个偏置参数!

-

上述的这12960+42个参数,在最开始都是随机初始化的,最终他们是神经网络在训练过程中,由模型自动学习得到的,而不是人为设置的。对于这些参数,我们称之为“模型参数(Model Parameters)”。与模型参数相对的是“超参数”,后面会讲!

2.1.4.3 我们指望隐层能做到什么?

我们希望隐层能够对输入的数据进行特征提取和转换,从而实现复杂的非线性映射关系。

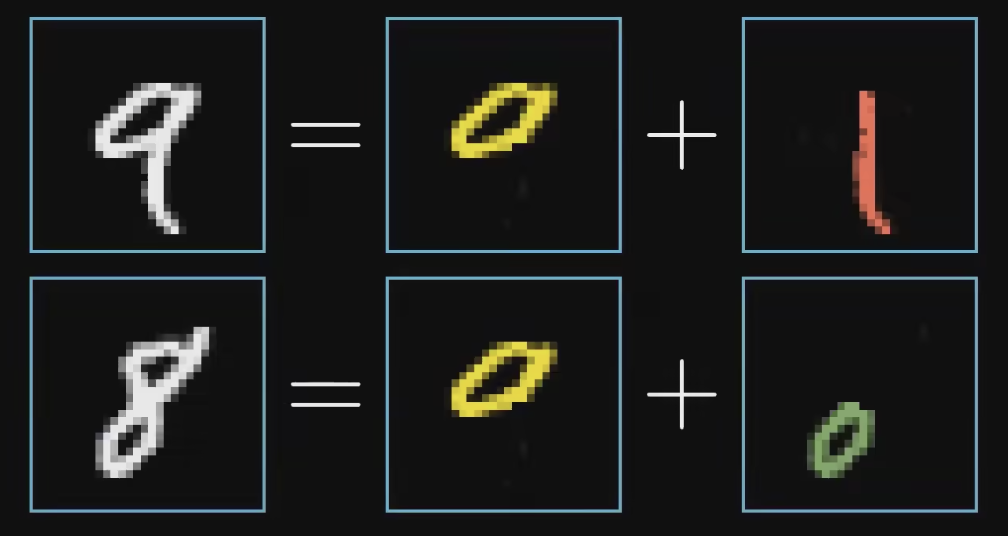

参考右图,我们可能认为,人之所以可以认识9和8,是因为9是由一个圈儿和一竖构成的;8是两个圈儿构成的。那如果要让机器去认识9和8,是不是也能让机器去识别、提取出这些特征呢?

理想情况下,我们希望第一个隐层可以先识别出圈圈、横、竖,第二个隐层可以对他们进行组装,从而知道这是哪一个数字,并且在输出层告诉我们。

对于左图的手写的“7”,我们可能会让机器去识别7的一条边(一横)。

有没有可能是这样:如果图中绿色的位置的像素对应的向量元素的大小都离1很接近,而绿色位置上下的像素对应的向量元素的大小都很接近0,那么我们就可以识别出来一条横边呢?

这样的话,我们就可以把那些我们希望离1近一些的像素对应的向量的权重赋值为正,把绿色区域上下的像素对应的向量的权重变成负的。

这样的话,如果真的写了一横,产生的加权

就最大了!

隐层的存在使得神经网络具有强大的表达能力,能够处理复杂的非线性关系,并从输入数据中自动提取有用的特征。隐层的神经元数量、激活函数的选择以及层次结构的设计等因素都会对神经网络的性能和学习能力产生影响,因此在设计和训练神经网络时,隐层的设置通常需要经验和调优。

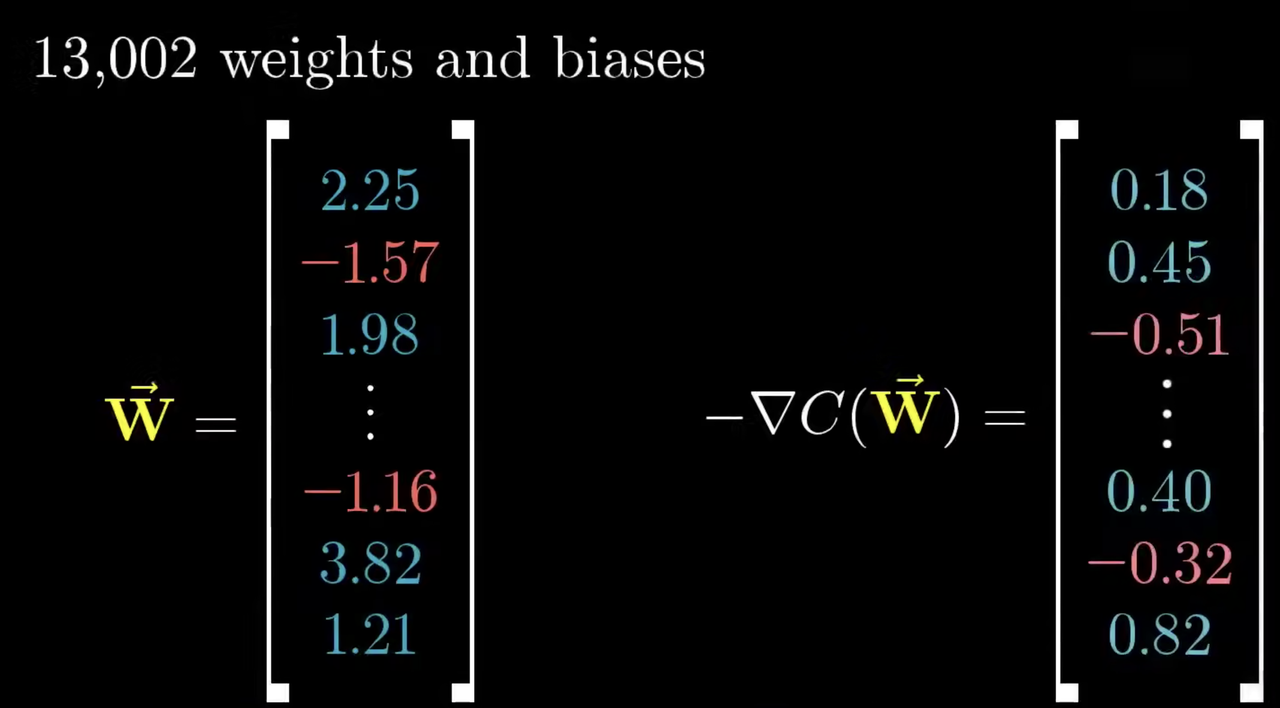

2.1.4.4 整个神经网络,就是一个有13002个可调节参数的超级大函数

因为每条线都代表一个权重参数,每一个非输入层的神经元又都有一个自己的偏置,所以光是这个�非常基础简单的神经网络,都有13002个参数可供调节。

所以,当我们讨论机器如何学习的时候,我们其实就是是在讨论:电脑怎么设置对这13002个参数,从而让他能够正确的帮我们解决问题,把一张手写的数字对应的784维向量转化为一个10维的向量的输出,并且输出的向量里最大的那个元素所对应的数字就是我们想要的数字?

OK,那我们现在来总结一下:

-

在手写数字识别的案例中,每一个神经元都是一个非线性的激活函数,输入值是输入的向量或者上一层神经网络中所有神经元所代表的数字(0~1)的加权和,对该加权和进行偏置的调节后送给激活函数,产生一个0~1的输出。

-

整个神经网络由784+16+16+10=826个神经元构成,共有13002个模型参数,整个函数输入一个784维向量,输出一个10维向量。#这个函数极为复杂,但其实仅仅也是个函数!大多数时候我们把他看成一个能够自动逼近我们想要的函数的黑箱就好了!

2.1.4.5 用线性代数的方法简洁表示层与层之间的权重:权重矩阵

-

下面的公式中,符号a代表一个神经元;a的上标代表了该神经元所在的层;下标��代表了该神经元是该层的第几个神经元。这边我们以上标0代表第输入层的784个参数,以上标1代表第一个隐层的16个参数.

-

w代表每两个神经元之间相连的权重,有两个下标,第一个下标是对第二层的神经元的标注,第二个下标是对第一层的神经元的标注。那么,有:

……

学过线性代数�的话就知道,像这样子的式子,如果先不去看外面的的和b的话,可以先表示为一个列向量:

和一个16*784的矩阵:

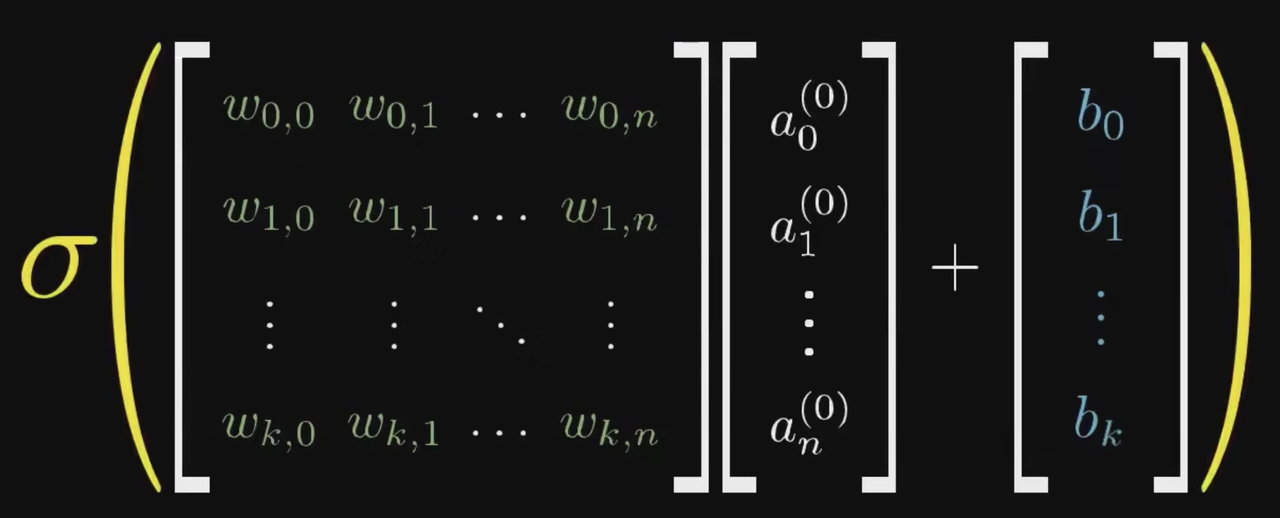

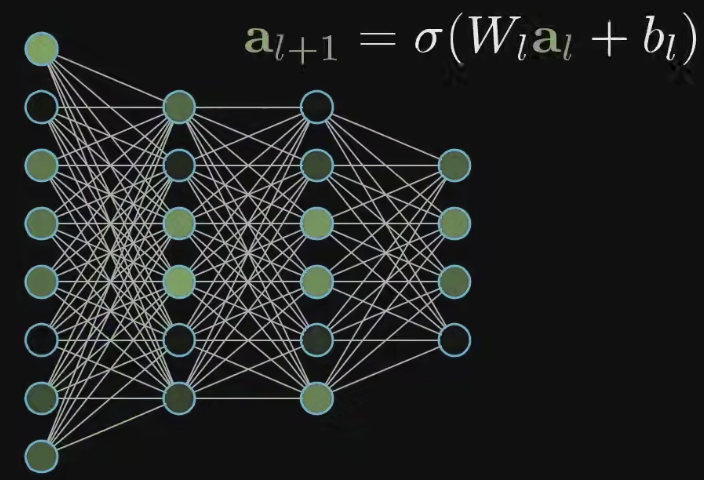

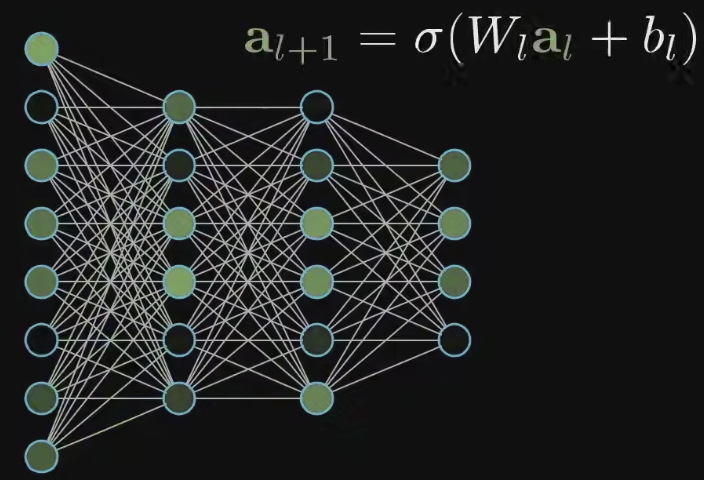

的乘积。那么,通解就参考下图:

这时候再把b和给算上,就得到下面的式子:

OK,最后我们再用大写的符号来表示左边的们构成的权重矩阵,用小写的和分别来表示两个列向量,用来表示新的一层神经元们�的值的列向量。这样,我们就就得到:

以后我们再看到任何一个大写的W,要知道:这就是一个权重矩阵,就像这里一样,没有什么特别的!

我们这边实现了对模型两个层之间的关系的表达,那么对于整个模型,我们应该怎么表达呢?我们�知道,整个模型中有多个模型参数:三个权重矩阵和多个偏置。我们常常把全部的参数都放在一个里,把模型表示为:。

模型(Model)是机器学习的三个基本要素(模型、学习准则、优化算法)之一!

2.2 神经网络的训练

2.2.1 前向传**(Forward Propagation)**

介绍完神经网络的大致结构,我们就已经对前向传播这件事有一定的了解了!一张图片变成784维向量输入给神经网络的输入层的784个神经元们,而后接下来的第一层隐层根据它的784*16个权重和16个偏置,产生了16个新的输出,送给了下一个隐层;下一个隐层则继续根据16*16个权重和16个偏置,输出16个标量给输出层。最后,输出层在根据自己的10*16个权重和10个偏置,输出10个数字。在神经网络的设计中,我们往往希望输出层输出的是一个概率分布函数,每个值都为正,而总和为1;然后对于值最大的一个神经元对应的内容(在上面的例子中是数字),就是我们的输出。这就是前向传播!

**前向传播(Forward Propagation)**一种在神经网络中进行信息传递的过程,它是神经网络训练的第一步。在前向传播中,输入数据通过神经网络的多个层(包括输入层、隐藏层和输出层)按照预定的权重和偏置进行计算,从输入层传递到输出层,最终得到神经网络的预测结果。

2.2.2 梯度下降(Gradient Descent)

我们已经搞懂了模型是怎么从输入到产生输出的,但我们真正要解决的机器学习问题在于,怎么让机器自己找到这13002个参数,实现学习的过程?

2.2.2.1 损��失函数(Loss Function)

首先,我们需要去评估模型的表现有多坏。

损失函数(Loss Function),也称为目标函数、成本函数或目标损失函数,是在监督式学习中用来度量模型预测值与真实标签之间差异的函数。

损失函数通常被定义为一个标量值,用于衡量模型的预测值与真实标签之间的误差或损失程度。一个常见的表示损失函数的公式为:

损失函数有很多种,例如:

- 平方损失函数(Quadratic Loss Function):预测值与真实值的差的平方的二分之一。这个函数不适用于分类问题,而适用于预测的输出值是一个实数值的任务中,所以整体而言我们不会和他打太多交道(但是在强化学习的TD算法里,我们会遇到它!!)

- 交叉熵损失函数(Cross-Entropy Loss Function):

交叉熵损失函数(Cross-Entropy Loss Function)是一种用于测量两个概率分布之间差异的数学函数,常常用于分类任务中,特别是在神经网络中作为损失函数。(我们后面讲的语言模型的损失函数几乎都是交叉熵损失函数!)

数学上,我们考虑模型的输出向量为一个概率分布函数的情况,定义为的输出向量的第C维。一般而言,我们希望正确的输出向量是一个one-hot向量,除了正确的标签对应的元素为1外,所有其他元素都是0.那么,

交叉熵损失函数定义如下:

***语言模型里,我们经常去依据前文的信息去预测下一个单词会是什么;神经网络最后输出的其实也是一个所有词的概率分布。***时,交叉熵损失函数可以帮助我们度量模型预测的概率分布与我们真正想要的概率分布之间的差异。

不过现在讲这些可能有点太**,**们还是先关注最简单的分类问题。

我们利用模型去判断一张手写的图片是什么数字(0,1,2,3,4,5,6,7,8,9)。假设对于一个手写的数字7,我们希望模型输出的向量就是:

<假设样本的标签是离散的,共有C个;那么我们可以用一个C维的one-hot向量来表示样本标签,这里C=10。假设正确的样本标签为K,那么只有第K维(这里是7)元素是1,其他都是0>

而模型实际输出的可能是:

=[0.1,0.2,0,0.1,0,0.3,0,0.1,0,0.2]

那么,交叉熵函数为:

<想不到吧,就这么简单!就是模型理应输出1的那一维向量的元素的负对数>

识别的越准,LOSS就会越小。

损失函数的input是什么呢?要想清楚这个问题!

-

在MNIST数据集中,损失函数的输入是13002个参数,即前面提到过的模型参数。

-

损失函数的输出是一个实数。

-

损失函数的大小取决于模型对训练数据的综合表现。

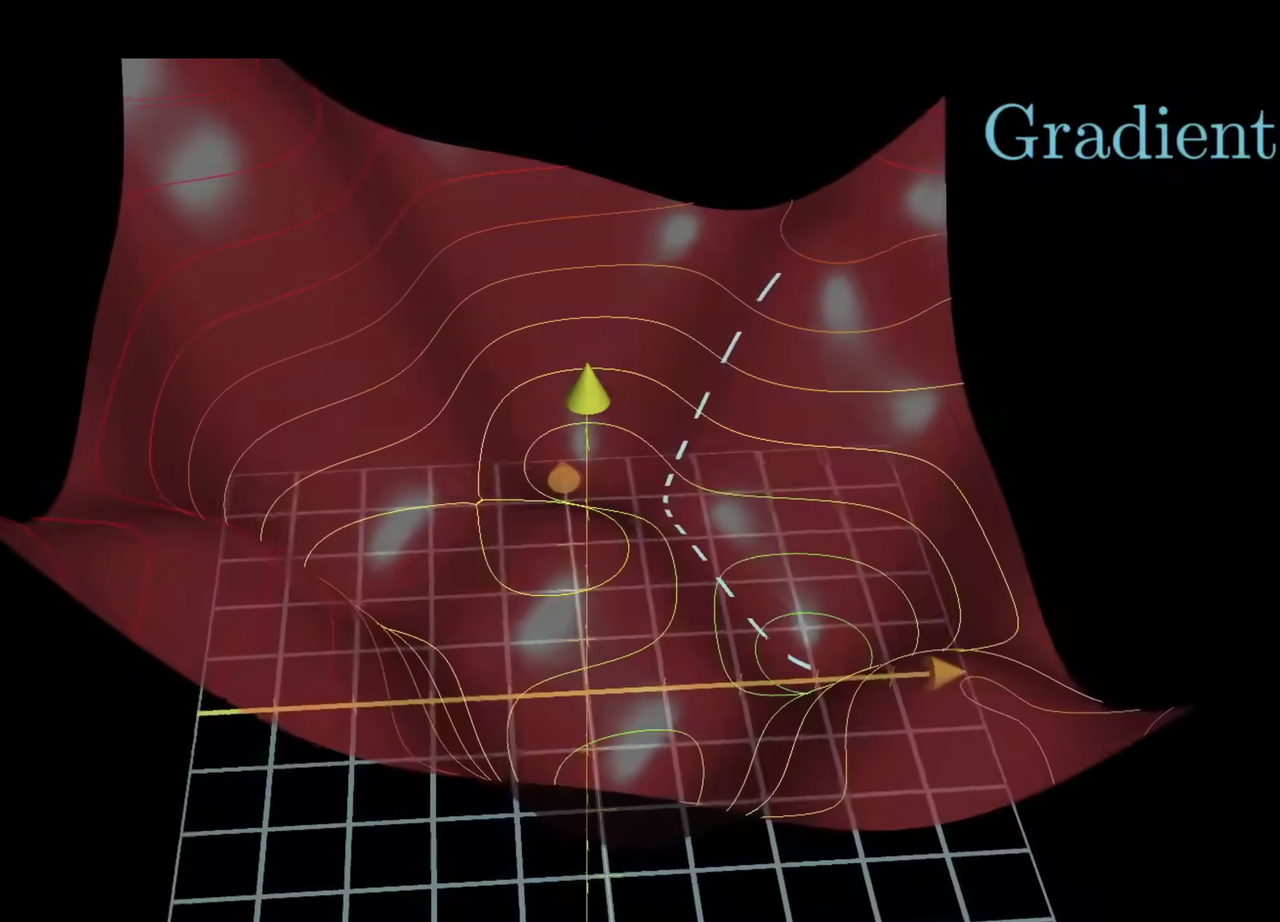

2.2.2.2 梯度下降 Gradient Descent

在确定了训练集(MNIST数据集,有60000张训练集图片和10000张测试集图片)、确定了模型并确定了损失函数后,我们要做的其实就是让损失函数最小化了!

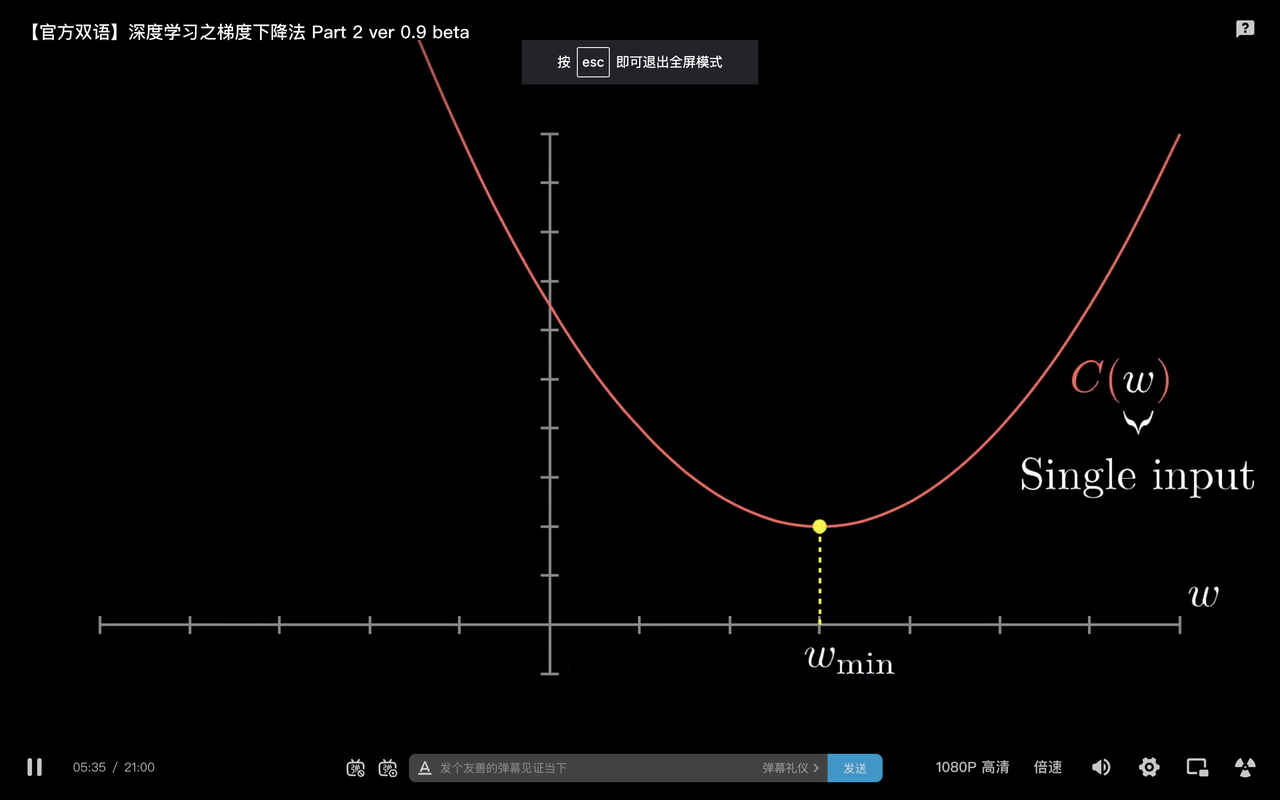

该怎么最小化损失呢?假设损失是一个的简单函数。学过微积分的朋友应该就可以联想到,想办法让这无非是一个求极小值的问题,看看哪里微分是0��就可以了。看看下图左边的,就是那里!

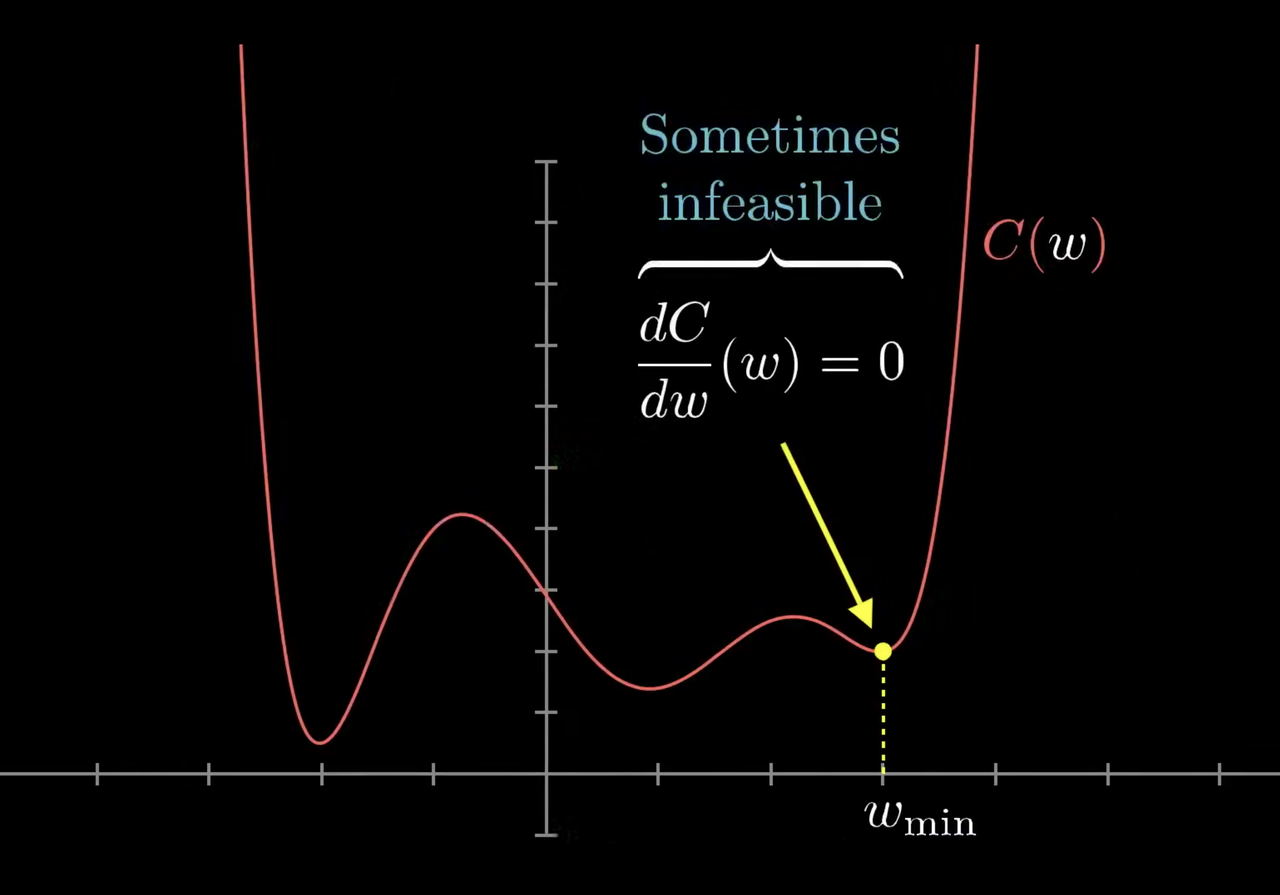

但是再看看右图,有时候一个函数稍微复杂一些的话,极小值就不一定好用了。何况我们的损失函数它有13002个参数,想要给这个函数求极小值,想想都会觉得很恐怖😨!

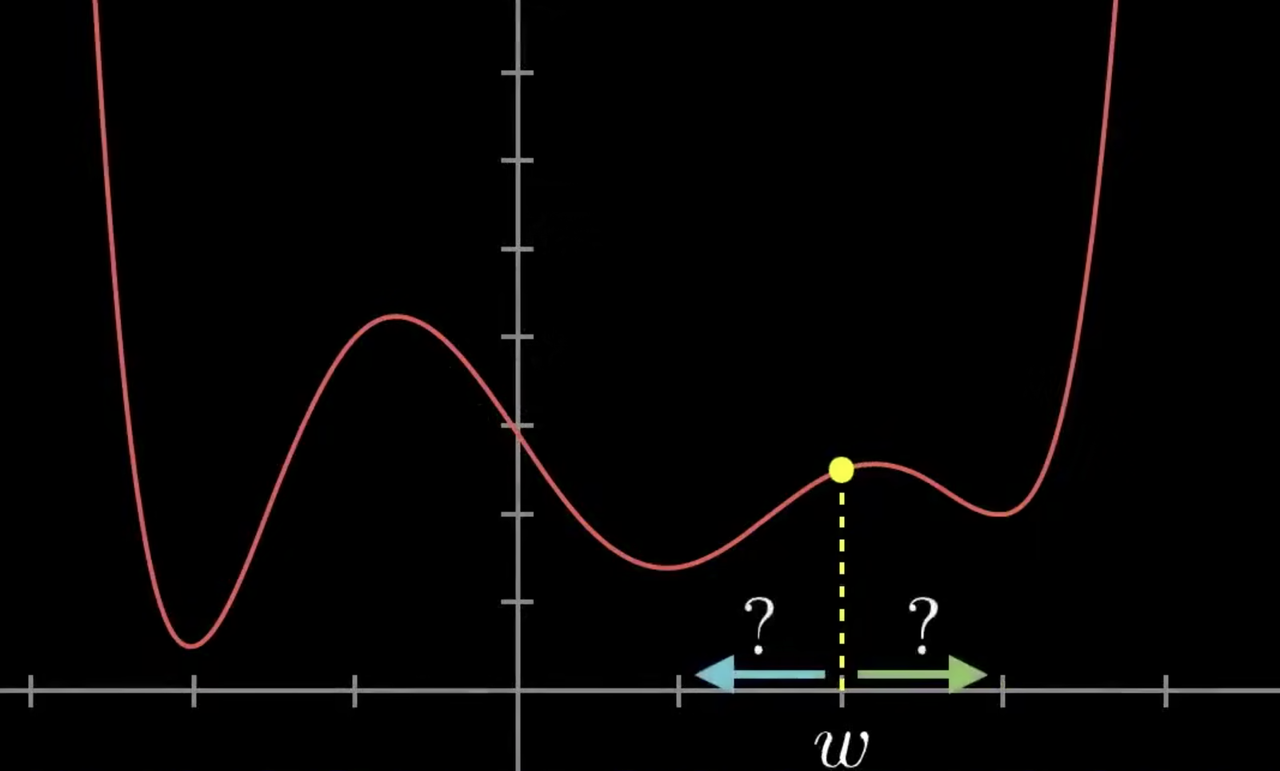

既然求不了极小值,那我们该怎么做呢?其实一个很简单的做法就是,因为模型的参数(中就只有)是随机初始化的,那么它就随机的落在了图像的某个点上。参考右图中的点w,我们只要去思考,把它往左挪,还是往右挪,函数的值会下降就好了。

那么,我们就算出这个点所在的斜率。斜率为正,就让它往左走;斜率为负,就让它往右走。我们让每步走的距离和斜率成正比:斜率很大,就多走几步,快速下降;斜率很小,就少走几步,防止调过头。

对每个点都如此反复,一直这么做下去,那么它就�迟早会落到一个低点了!

嗯,但是很自然的,按照左边的做法,我们可能会收敛于局部最小而不是全局最小😳。。。

这件事情在神经网络的训练中也会遇到!

OK,现在我们想象一个稍微复杂一点的二元函数:。那么代价函数就变成了这样的一个曲面。我们想象一个小球落在了随机初始化的参数下,代价函数对应的值所在的位置。那么这个我们就要用类似的方法,让小球沿着曲面滚动,最终落到一个凹陷的最低点里面去。

现在我们就不只是问向左还是向右了,在这个三维空间里,假定i、j是x、y轴对应的单位向量,球现在正落在的位置上。我们希望找到一个向量,沿着这个方向,函数的值上升最快。这就是在坐标的梯度。

这样的话,我们只要沿着这个方向的反方向走,而且梯度越大我们一次走的越多;并且到了一个新的位置之后,继续计算梯度,并沿着梯度的反方向走,循环往复,最终就能找到一个凹陷的地方了。

多元函数的梯度是一个向量,它表示了这个多元函数在某一点上变化最快的方向和变化率。对于一个具有 n 个自变量的多元函数,其梯度是一个 n 维向量,其中每个分量��对应一个自变量的偏导数。

-

设有一个 n 变量的函数 。

-

这个函数在某一点 处的梯度记作 ,或:

-

-

其中 表示函数 对 的偏导数在点 处的值,分别表示n 维空间下该对应的坐标轴的单位向量。

-

让多元函数的所有参数都沿着梯度的正方向走,我们称之为梯度上升(Gradient Ascent),此时函数值上升最快。我们在强化学习的策略学习中,最大化状态价值函数,会做梯度上升!

-

让多元函数的所有参数都沿着梯度的反方向走,我们称之为梯度下降(Gradient Descent),此时函数值下降最快。在更多的场合,我们为了最小化损失,会去做梯度下降!

反复的去做梯度下降就是我们寻找一个多元函数的极小值点的套路!

上面列举了1元和2元函数的情况,来讲解梯度下降。从两个例子其实都可以看出,每到一个点,就算出该点的梯度,并且沿着梯度的反方向,走一段与梯度大小成正比的距离,从而到一个新的点;重复上述过程,最终,我们就会找到一个函数的极小值点,此时梯度就会收敛于0。我们不一定会找到整个函数的最小值,此时我们称自己收敛于局部最优而非全局最优;但不管怎么样,找到一个极小值点,就已经够了不起了!

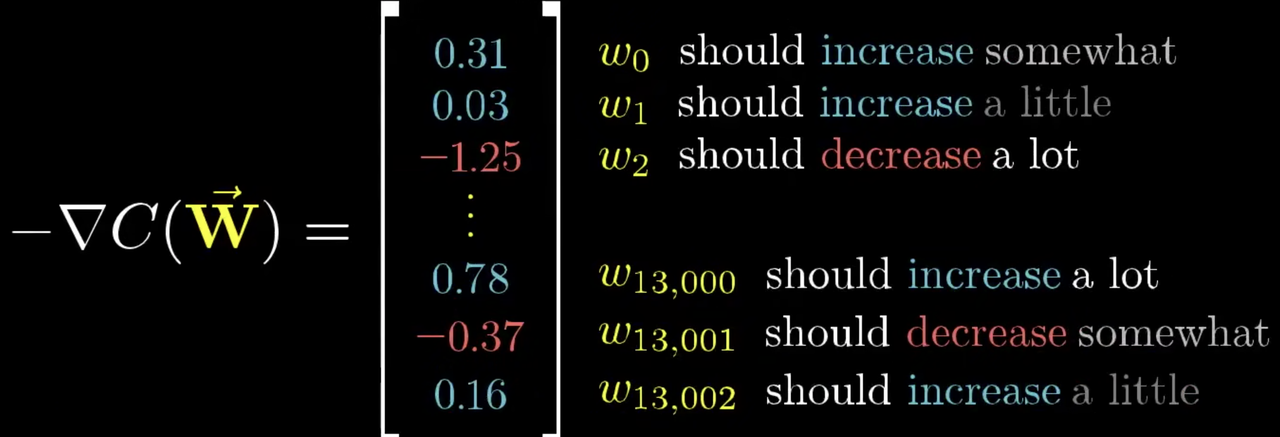

负梯度向量其实告诉了我们,怎么去调节每一个参数,可以让神经网络的损失下降的最快。

回到MNIST数据集的这个例子,该案例中损失函数有13002个参数,但他同样适用于梯度下降这个原理!

想象把13002个参数作为一个列向量,那么他的负梯度其实无非也是一个13002维的列向量。这个负梯度告诉了我们,在这个13002维的空间里,怎么去调节每一个参数,才可以让损失下降的最快。

负梯度向量中,一个元素数字越大,说明更改这个元素对应的参数,性价比越高。 他反映了参数的重要性。

我们经常把全部的模型参数合起来写作,因此梯度下降的过程可以写作:

其中,为模型第t次迭代时的参数值,为学习率,为每一次迭代时,所输入给模型并且用于计算平均损失的训练样本的数量。传统的机器学习算法中,整个训练集中的所有样本都会被用来计算模型参数的梯度,并根据梯度来更新模型参数,因此的值就是训练集的大小。

总之,目前我们只要知道,有梯度这么一个东西,可以算出一个多元函数(哪怕几千几万个参数)沿着哪个方向下降最快,从而指导我们去给模型做调参。梯度中元素的值越大,我们沿着那个元素对应的方向走越多的成正比距离,循环往复,我们就可以找到一个多元函数的极小值点了。

2.2.3 模型更新的频率与超参数

上面写了梯度下降的过程的数学表达:

其中还有些元素是我们比较陌生的,包括和。显然,他们是我们��人为设置的,不属于模型可以去学习的那13002个模型参数的范畴。我们管这样的参数叫做超参数。

超参数(Hyperparameters),是在机器学习算法中需要手动设置的参数,用于控制模型的学习过程和性能。与模型参数不同,超参数的值不能通过训练数据自动学习得到,而需要在训练之前由人工设置。

超参数的选择会影响模型的性能和训练速度,因此合理的超参数选择对于获得良好的模型性能非常重要。

2.2.3.1 超参数之批大小(Batch Size)

-

**Batch Size(批大小)**指在模型的一次参数更新中使用的样本数量。

-

传统的机器学习算法中,整个训练集中的所有样本都会被用来计算模型参数的梯度,并根据梯度来更新模型参数,因此的值就是训练集的大小。此时,Batch Size通常指的是整个训练集的样本数量,也被称为"Full batch"或"Batch gradient descent"。

-

使用整个训练集进行梯度计算和参数更新的方式,确保了每次更新都是基于全局的梯度信息,从而在更新模型参数时可以更加准确地朝着梯度下降的方向移动。然而,这种方式在处理大规模数据集时可能会面临计算速度较慢的问题,因为需要计算整个训练集的梯度。因此,随着数据集规模的增大,传统的梯度下降算��法可能会变得效率较低。在目前大多数模型的训练过程中,训练数据通常被划分为多个小批次(Batch)进行处理,每个批次包含一定数量的样本。

-

参考上面的公式,假定每次训练我们使用N个样本,那么Batch Size就是N。此时,Loss Function就是这N个交叉熵函数的大小的平均值,我们是基于这个损失值去做反向传播,更新模型的参数的。

-

批大小的选择会直接影响模型的训练速度和内存占用。较大的批大小可以加速训练过程,因为可以利用硬件的并行性进行计算,但可能会占用更多的内存。较小的批大小则可以减小内存占用,但可能导致计算效率较低。合适的批大小通常需要根据具体的任务和硬件资源进行选择,常见的取值范围通常在几十到几千之间。

2.2.3.2 超参数之学习率(Learning Rate)

学习率(Learning rate):用于控制模型在每一轮训练中对权重进行更新的步伐大小。具体来说,学习率决定了在梯度下降优化算法中,每次更新权重时权重的变化量。

<前面用到过这张图。左边是参数向量,右边是梯度向量,我们是以梯度的倍数去调节左边的参数的。这个倍数其实就是学习率。它可以是恒定的,可以衰减,也可以自动调整。>

2.2.3.3 超参数之迭代次数(Epochs)

迭代次数表示模型在整个训练数据集上的训练次数。

注意,迭代次数和Batch Size本身并不是一个此消彼长的关系。哪怕采用Full Batch,也可以迭代非常非常多次。

-

过少的迭代次数可能导致欠拟合,而过多的迭代次数可能导致过拟合。

-

**欠拟合(Underfitting),**指模型在训练数据上表现不佳,无法很好地捕捉到数据的特征和模式的现象。

-

**过拟合(Overfitting),**指模型在训练数据上表现很好,但在未见过的测试数据上表现较差的现象。简而言之,过拟合表示模型在训练数据上过度拟合,从而导致在新数据上的泛化性能下降。过拟合通常发生在模型过于复杂或者训练数据较少的情况下。当模型过于复杂时,它可能会在训练数据上表现得非常好,但在新数据上的表现较差,因为模型已经过于“记忆”了训练数据,无法很好地泛化到新的数据。

解决过拟合的方法通常包括以下几种:

-

数据增强(Data Augmentation):可以对训练数据进行扩增,如旋转、缩放、翻转等,从而增加训练数据的多样性,减少模型对于训练数据的过拟合。

-

提前停止(Early Stopping):可以在训练过程中监控模型在验证数据上的性能,当性能开始下降时,提前停止训练,避免模型过拟合。

-

正则化(Regularization):可以通过在模型的损失函数中引入正则化项(如L1正则化、L2正则化等)来限制模型的参数值,从而减少模型的复杂度,防止过拟合。

2.2.3.4 超参数之正则化

上面提到了,正则化是一种限制模型的参数值,减少模型的复杂度,从而避免模型在训练数据上过拟合的技术。

在神经网络中,常见的正则化方法包括以下几种:

-

L1 正则化(L1 Regularization,也称为 Lasso 正则化):在目标函数中引入模型权重的 L1 范数作为惩罚项,使得模型权重倾向于稀疏化,即某些权重变为零。L1 正则化可以用于控制神经网络中的参数稀疏性,从而减小模型复杂性。#简单理解,L1就是把某些参数的权重变成0.

-

L2 正则化(L2 Regularization,也称为 Ridge 正则化):在目标函数中引入模型权重的 L2 范数作为惩罚项,使得模型权重趋向于较小的值,从而减小模型复杂性。L2 正则化可以用于控制神经网络中的参数值的大小,从而防止过拟合。#简单理解,L2就是在抑制模型的一些权重取值过大

-

Dropout 正则化:Dropout 是一种在训练时随机丢弃一部分神经元输出的方法,从而减少神经网络的复杂性,防止过拟合。Dropout 可以随机地设置某些神经元的输出为零,从而迫使网络在训练过程中不依赖于特定的神经元,从而提高网络的泛化性能。简单理解DropOut就是扔掉一些神经元。

2.2.3.5 超参数之激活函数

前面提到过,激活��函数用于引入非线性变换,常见的激活函数包括ReLU、sigmoid、tanh等。选择合适的激活函数对于模型的性能至关重要。

2.2.4 反向传播(Backpropagation,BP)

上面提到了梯度下降的方法,而如何去计算那些梯度,变成了神经网络算法在工程实现上的核心问题。我们称之为反向传播算法。

2.2.4.1 反向传播介绍

**反向传播(Backpropagation)**于计算神经网络中各层权重和偏置的梯度,从而实现模型参数的更新。它是前向传播的逆过程,通过计算损失函数对神经网络输出的梯度,逐层向后传播,从输出层到输入层,计算每一层的梯度,并用于更新模型参数。

反向传播的基本思想是根据链式法则(Chain Rule)计算损失函数对模型参数的梯度。具体步骤如下:

-

初始化梯度:将最后一层(输出层)的梯度初始化为损失函数对输出的梯度,通常使用损失函数的导数。

-

反向传播:从输出层开始,根据链式法则计算损失函数对每一层输入的梯度。对于每一层,根据当前层的输出和权重,计算该层输入的梯度,并传递到前一层。

-

计算参数梯度:根据每一层输入的梯度和该层的输入,计算损失函数对该层权重和偏置的梯度。这可以通过将输入的梯度与该层输入的转置相乘(对权重)或直接求和(对偏置)来实现。

-

更新参数:使用计算得到的参数梯度,按照梯度下降的方式更新模型的权重和偏置,通常使用学习率来控制更新的步幅。

-

重复步骤2至步骤4:重复执行上述步骤,直到达到预定的停止条件,例如达到最大迭代次数或损失函数收敛到足够小的值。

-

我们只需要知道反向传播是前向传播的逆过程,通过计算损失函数对神经网络输出的梯度,逐层的传播,通过这样的方法可以计算出一个神经网络的损失函数梯度,并调参实现梯度下降,就可以了。

-

此外,我们还需要知道,反向传播过程中,深层的网络的梯度计算需要经过连乘的操作。

-

具体的算法在数理表示上比较复杂,可以参考后续的推荐学习资料。

2.2.4.2 梯度消失问题和梯度爆炸问题

什么是梯度消失?

**梯度消失问题(Gradient Vanishing)**指在深度神经网络中,反向传播算法中计算的梯度在网络的较深层逐渐变得非常小,甚至趋近于零,从而导致这些层的权重更新变得非常缓慢或停止更新,使得这些层的参数无法得到有效的训练。

为什么会梯度消失?

-

梯度消失问题通常出现在具有多层的深度神经网络中,特别是在使用激活函数为Sigmoid或Tanh等饱和激活函数时,因为这些函数在输入较大或较小的情况下会饱和并导致梯度变得非常小。(当输入接近1时,Sigmoid函数的输出值会接近于1,导数趋近于0。�于是在反向传播过程中,梯度的乘积会趋近于零。)(为了缓解梯度消失问题,深度神经网络中常常使用其他类型的激活函数,如ReLU)

-

深度神经网络中,梯度是通过链式法则进行反向传播的。每一层的梯度都需要与前一层的梯度相乘,然后再传递到前一层,依此类推,直到传递到网络的输入层。如果网络层数较多,那么在反向传播过程中会经过多次连续的乘法操作,从而可能导致梯度的值指数级地减小,最终趋近于零,即梯度消失)。

那么梯度爆炸呢?

-

自然的,因为要经过多次的连乘,每次乘法操作都可能将梯度放大,从而导致梯度值变得非常大,从而导致梯度爆炸(Gradient Explosion)。

-

梯度爆炸会导致网络的权重参数更新过大,从而使得模型的训练变得不稳定。

2.2.4.3 缓解梯度问题:归一化(Normalization)

什么是归一化?

**归一化(Normalization)**一种对输入或者网络层的输出进行线性或非线性的缩放处理,将其映射到一个特定的范围或者分布内,以便提高网络的训练稳定性和性能的作法。常用的方式是将数据的均值变为0,方差变为1。

归一化怎么缓解梯度问题?

归一化可以在训练过程中对输入数据或网络层的输出进行处理,从而对激活函数的输入值进行调整,避免其过大或过小而导致的梯度消失、梯度爆炸等问题,提高网络的学习效果和�泛化性能。

在神经网络中,常见的归一化方法包括:

-

批标准化(Batch Normalization,简称BN):批标准化是一种在训练过程中对网络层的输入进行归一化的方法。它通过在每个批次中对输入数据进行规范化,使其均值为0、方差为1,从而加速网络的收敛过程,降低网络对初始化和学习率的敏感性,同时也有一定的正则化效果。

-

层标准化(Layer Normalization):层标准化是一种对网络层的输出进行归一化的方法,与批标准化不同,它在每层中对所有样本的输出进行规范化,而不是对每个批次进行规范化。层标准化在处理序列数据等不适合批处理的情况下,可以作为替代方案使用。

-

组标准化(Group Normalization):组标准化是一种介于批标准化和层标准化之间的方法,它将输入数据分成多个小组,然后对每个小组内的样本进行归一化,从而减小小组之间的相关性,提高网络的学习能力。

总之,可以先这么理解:归一化就是把一堆数据的均值变成0、方差变成1。

2.3 万能逼近定理:MLP可以拟合任何函数

-

万能逼近定理(Universal Approximation Theorem):带有一个隐层(Hidden Layer)的MLP,可以以一定的精度逼近任何函数;该MLP的参数量越大,逼近程度越高。

-

万能逼近定理的条件是指神经网络具有足够多的隐藏层节点和足够的非线性激活函数,并且可以��使用足够多的训练样本进行训练。在实际应用中,虽然神经网络具有万能逼近定理的能力,但实际训练过程中还需要考虑许多其他因素,如过拟合、训练速度、数据质量等。

MLP可以以一定精度逼近任何函数是有数学证明的,但比较复杂,哪怕是对于搞科研的人也不是一定要搞懂,所以不在这个文档中作证明。求知欲强的伙伴可以看:【个人博客】图解神经网络为什么能拟合任意函数

2.4 推荐学习材料

2.4.1 MLP推荐视频材料

【官方双语】深度学习之神经网络的结构 Part 1 ver 2.0__bilibili

【官方双语】深度学习之梯度下降法 Part 2 ver 0.9 bilibili

【官方双语】深度学习之反向传播算法 上/下 Part 3 ver 0.9 bilibili

2.4.2 MLP推荐文字资料

【个人博客】Neural Networks and Deep Learning,By Beeder。在学习LSTM的时候在一个知乎回答下发现了他的博客。并不认识这个人,但博客里内容非常动人,一些学习笔记的质量也非常的高。

2.5 MLP总结

计算机看到的特征是什么样的?

在做出最后的表格总结之前,我们先来看看神经元所看到的特征是怎么样的。

最开始的时候,我们说,我们期待中间的隐层可以像我们人一样,识别出横、圆、边等特征,并拼接成一个数字。然而,计算机实际看到的东西是右图所示的。

嗯,他根本就没有什么规律!

那自然的,如果我们把随便一张照片,比如一张二维码交给机器去识别。我们可能期待机器会告诉我们这不是一个数字;但事实是,机器会非常肯定的给你输出一个答案。这感觉就像,在这13000维的我们无法想象的空间中,机器找到了一个很不错的�局部最小值坐了下来,可以成功分类大多图像,但却没有真正的智慧!

| 模型 | 多层感知器 MLP |

|---|---|

| 模型结构 |  |

| 类型与架构 | MLP是最基本的神经网络,属于前馈神经网络(Feedforward Neural Network)。在前馈神经网络中,信息在网络中从输入层(Input Layer)经过多个中间层(Hidden Layers)传递到输出层(Output Layer),并且信息在网络中只能向前传播,不会形成循环。前馈神经网络也被称为无记忆神经网络(Memoryless Neural Network),因为网络中没有存储之前计算的状态。 |

| 优缺点 | 优点:具有较强的非线性建模能力;可以进行端到端的学习;可以并行计算缺点:容易陷入局部最优;容易过拟合;全连接的结构太过复杂(想象一张很高清的图,例如你用苹果手机拍的照片。苹果手机的像素1200万,如果还是用全连接层的结构,那参数的数量会过于爆炸)。 |

| 可调节超参数 | Batch Size,学习率,网络结构(层数、神经元数量等)、激活函数、优化算法等。MLP可以调节的超参数非常多,因此模型的调优非常复杂。 |

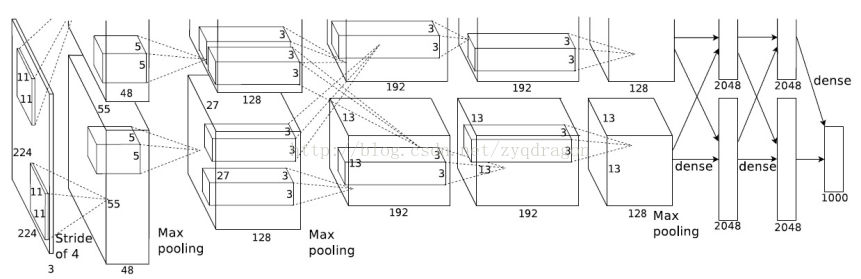

3. 入门:卷积神经网络 Convolutional Neural Network, CNN

3.1 卷积神经网络概述

3.1.1 什么是卷积?

如果去网上搜什么是“卷积”,可能会看到对于两个连续函数f(x)和g(x),其一维连续卷积为:

但其实不懂这个公式的具体含义,丝毫不影响理解卷积神经网络!本文档不会很详细的去解释什么是卷积、卷积的数学含义,好奇的朋友可以参考知乎的这一页:【知乎】如何通俗易懂地解释卷积?,前几个答案都还不错。

我们只需要知道:在机器学习中,卷积通常用于处理具有局部相关性的数据,例如图像、音频和文本等,就足够了。

3.1.2 图�像处理中的卷积

3.1.2.1 为什么需要卷积?

-

我们前面用MNIST去训练一个MLP来识别数字的时候,其实就已经在做一个图像处理了。但这里存在一个问题,即全连接层的结构实在是太复杂了。光是上面例子中28*28像素的黑白手写数字,就让我们有13002个参数要去学习。那如果用苹果手机随便拍一张1200万像素、彩色的照片呢(彩色就无法用0~1的灰度来表示了,而需要把一张图片分为三层,分别代表R、G、B)?如果这种时候还用MLP的结构,那模型会复杂到难以想象!

-

为了解决这个问题,一个很自然的想法就是对输入的图片做压缩,从繁多的像素中分区域提取最重要的特征。

3.1.2.2 图解CNN中的卷积过程

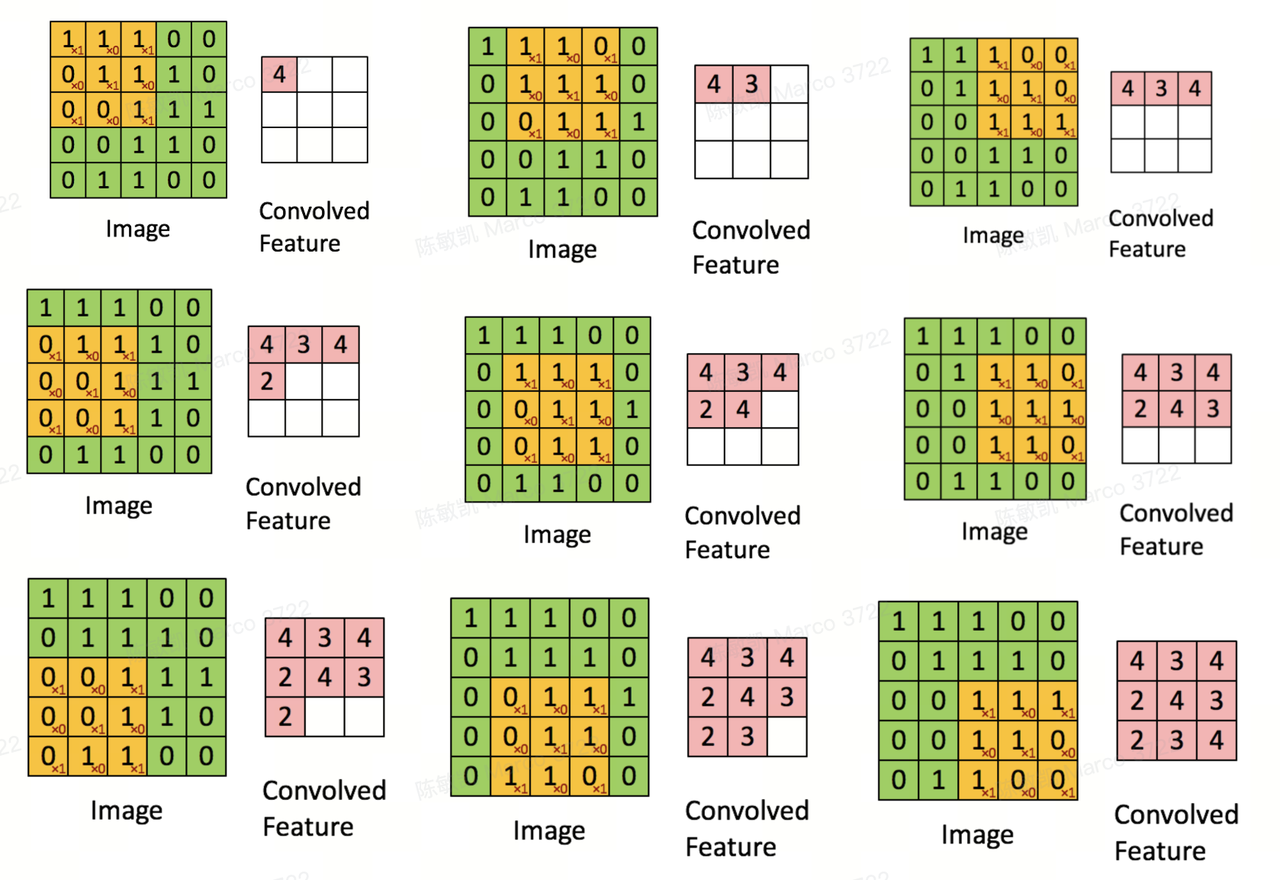

在图像处理中,卷积通常通过在输入图像上滑动一个小的窗口(Sliding Window),称为卷积核或滤波器,对输入图像的像素进行逐点计算。卷积核包含了一组权重参数,它对应于滑动窗口中的每一个位置,通过对输入图像的局部区域进行加权求和来生成输出特征图。参考下图,下图我们对一个5*5像素的图片��,选取了一个3*3大小的卷积核,以1为步长,对原图片进行了卷积操作,提取出了一个特征图。在下面的案例中,我们采用的卷积核的权重参数为:

;最后我们得到了特征图

想象如果我们用一个的卷积核,其他保持不变;那么最终得到的特征图就是一个的矩阵了!

这种局部计算的方式使得卷积能够捕捉到输入图像的局部特征,例如边缘、纹理和形状等。

3.1.2.3 定义卷积神经网络

卷积操作在深度学习中被广泛应用于卷积神经网络(Convolutional Neural Networks, CNNs),这是一种包括卷积层和池化层的神经网络,专门用于图像识别、图像生成和图像处理等任务。卷积在CNNs中的作用类似于特征提取器,能够从输入图像中提取有用的特征,并通过后续的神经网络层来进行进一步的处理和分类。

3.2 卷积神经网络的结构

典型的CNN包括两个部分:

(1)卷积基,由卷积层和池化层的堆栈组成。卷积基的主要目的是由图像生成特征。

(2)分类器,通常是由多个全连接层组成的。分类器的主要目标是基于检测到的特征对图像进行分类。全连接层是其中的神经元与前一层中的所有激活神经元完全连接的层。

在一个CNN输入层、卷积层、池化层、全连接层中,卷积层负责提取特征,池化层负责压缩特征,最后的若干全连接层往往构成一个分类器。(这部分后面我们讲迁移学习的时候会再次提到)

3.2.1 卷积层 Convolutional Layer

卷积层(Convolutional Layer)是其中的一个主要组件,主要用于从输入数据中提取特征。卷积层通过应用卷积操作对输入数据进行滤波,从而通过学习到的卷积核(也称为滤波器或过滤器)提取出输入数据的局部特征。

-

卷积操作(Convolution):卷积操作是卷积层的核心操作。它通过将卷积核与输入数据进行逐元素相乘,并将相乘的结果进行累加,从而生成卷积特征图(也称为卷积输出或特征映射)。卷积操作可以捕捉输入数据的局部信息,例如边缘、纹理、形状等。

-

激活函数(Activation Function):卷积层通常会在卷积操作之后应用激活函数,对生成的卷积特征图进行非线性变换。常用的激活函数包括ReLU(Rectified Linear Unit)、sigmoid、tanh等,用于引入非线性特性,从而增加网络的表达能力。

-

填充(Padding):填充是卷积操作中的一种技术,可以在输入数据的周围添加额外的像素或特定的值,从而扩展输入数据�的尺寸。填充可以防止在卷积过程中输入数据尺寸的缩小,有助于保留边缘信息、减小特征图的尺寸变化,并且可以改善网络对输入图像边缘区域的处理能力。

-

步长(Stride):步长是卷积操作中的另一种技术,控制卷积核在输入数据上的滑动步长。较大的步长可以减小特征图的尺寸,从而降低计算复杂度,但可能会导致信息的丢失和分辨率的降低;较小的步长可以保留更多的局部信息,但会增加计算复杂度。

3.2.2 池化层 Pooling Layer

池化层(Pooling Layer)于在特征图上进行下采样(Downsampling)。池化操作通常在卷积操作之后,可以帮助网络降低特征图的空间尺寸,并减少网络的参数数量,从而降低计算复杂度。

3.2.2.1 图解池化层

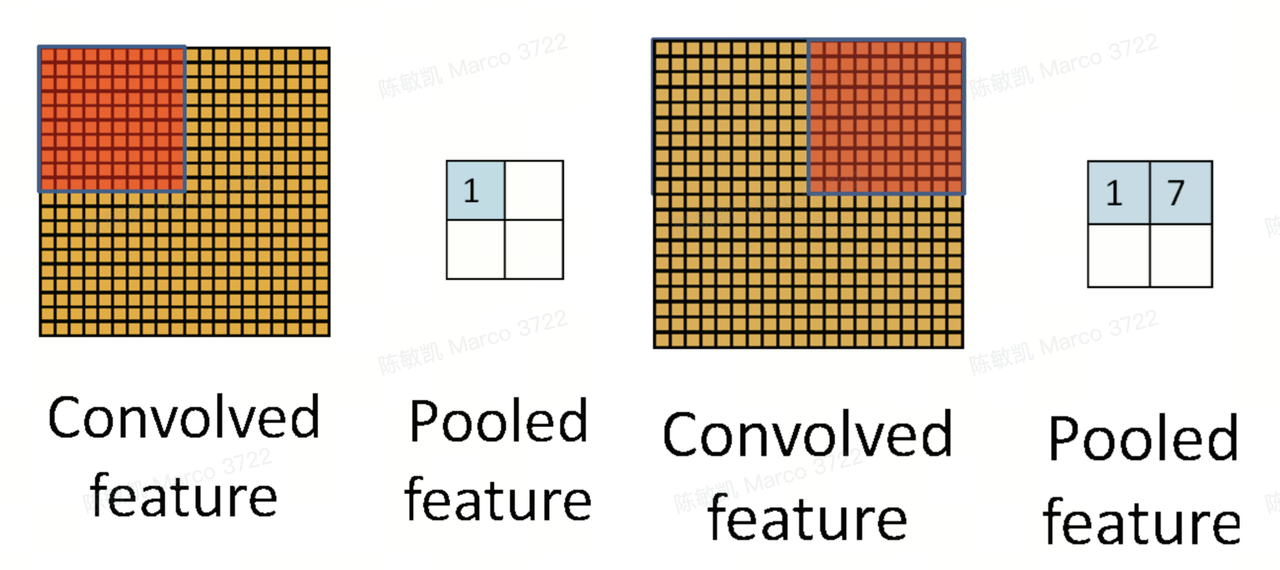

参考下图,对于一个20*20的特征图,我们选择了一个10*10的池化窗口,且池化步长为10,最后我们下采样得到了一个2*2的矩阵。

3.2.2.2 池化类型

池池化层可以使用不同类型的池化操作,��如最大池化(Max Pooling)、平均池化(Average Pooling)、全局平均池化(Global Average Pooling)等。一般来说我们都采用最大池化,即池化窗口中最大的一个元素,就是最后我们保留下来的元素。

3.2.2.3 池化层的主要功能

-

下采样(Downsampling):池化层通过将特征图上的一组相邻像素值合并为一个代表性的值,从而降低特征图的尺寸。这样可以减小模型的计算复杂度,并且有助于提取局部特征。

-

特征选择(Feature Selection):池化层通过在一组像素值中选择一个最代表性的值,如最大值(Max Pooling)或平均值(Average Pooling),来减少特征图的维度。这样可以帮助网络选择最重要的特征,并降低噪音对特征提取的干扰。

-

平移不变性(Translation Invariance):池化层在特征图上进行局部合并操作,使得网络对输入图像的小平移变化具有一定的不变性。这有助于网络学习到更加鲁棒的特征表示,从而提高模型的泛化能力。

3.3 卷积神网络中的超参数

3.3.1 卷积核尺寸 Kernel Size

卷积核是卷积操作中的滤波�器,用于从输入数据中提取特征。卷积核尺寸定义了卷积窗口的大小,通常为一个正方形或矩形的尺寸。

-

较小的卷积核可以捕获细节信息;

-

而较大的卷积核可以捕获更大尺度的特征。

3.3.2 滑动窗口步长 Stride

步长是卷积操作中卷积窗口在输入数据上滑动的距离。较大的步长可以减小特征图尺寸,加快计算速度,但可能会导致信息丢失。

3.3.3 边缘填充 Padding

填充(Padding)是卷积神经网络中的一种操作,通过在输入特征图周围添加额外的像素值,从而扩展输入数据的尺寸,使得输出特征图的尺寸与输入的原特征图相同或者相似。

填充可以避免边缘像素信息在卷积操作中丢失。在没有填充的情况下,卷积核只能在输入特征图的内部进行卷积操作,导致边缘像素的信息无法得到充分的利用。通过填充操作,卷积核可以在特征图的边缘进行卷积操作,从而保护边缘信息。

3.3.4 卷积核的个数 Number of Kernels

网络中每个卷积层可以有多个卷积核,用于提取不同的特征(这和我们后文会提到的Transformer的多头注意力机制,每头注意力会去提取不同的特征,有异曲同工之妙!)。卷积核数量定义了卷积层中的滤波器数量,决定了卷积层的输出特征图的通道数。

3.4 感受野 Receptive Field

3.4.1 什么是感受野?

-

**感受野(Receptive Field)**指在卷积神经网络中,某一层的输出特征图上的每个像素点在输入图像上所对应的区域大小。感受野的大小决定了该层的感知范围,即网络在该层能够接收到的输入信息的范围。

-

CNN里每一层的感受野由其前一层的卷积核尺寸、步长、填充等超参数决定。通过不断堆叠多个卷积层,感受野会逐渐扩大,从而能够捕捉到更大尺度的特征。

3.4.2 感受野为什么重要?

感受野的大小对卷积神经网络的性能和特征提取能力具有重要影响。

-

较小的感受野可以捕捉到细节信息,适合处理图像中的小物体或细微纹理;

-

而较大的感受野可以捕捉到更大尺度的特征,适合处理图像中的大物体或全局结构。

-

因此,在设计卷积神经网络时,需要合理选择不同层的超参数,以获得适合任务的感受野大小。

3.4.3 相比于普通MLP,卷积神经网络如何减少参数的个数?

CNN网络中三个关键的操作,其一是局部感受野,其二是权值共享,其三是池化层,有效的减少了网络的参数个数,缓解了模型的过拟合问题。

3.5 推荐学习材料

入门:深度学习——卷积神经网络(CNN)简介 By 南方惆怅客的博客@CSDN

从入门到进阶:卷积神经网络超详细介绍 By 呆呆的猫的博客@CSDN

3.6 CNN总结

| 模型 | 多层感知器 MLP | 卷积神经网络 CNN |

|---|---|---|

| 模型结构 |  |  |

| 类型与架构 | 前馈神经网络,不循环有监督学习,依赖标注数据每一层之间都以全连接的形式相连 | 前馈神经网络,不循环通常是有监督学习,依赖标注数据架构包括输入层、卷积层、池化层、全连接层。卷积层提取特征,池化层压缩特征。 |

| 优缺点 | 优点:具有较强的非线性建模能力;可以进行端到端的学习;可以并行计算缺点:容易陷入局部最优;容易过拟合;全连接的结构太过复杂 | 优点:卷积层通过使用局部感知性的卷积操作,可以有效地捕捉输入数据中的局部特征;在卷积层中,卷积核的参数在整个输入上是共享的,大大减少了需要学习的参数数量;高度可并行化;池化层进行下采样,减小特征图的尺寸,降低模型复杂性卷积神经网络非常适合用于图像识别,其高性能和易训练的特点是最近几年CNN流行的两个主要原因 |

| 可调节超参数 | Batch Size,学习率,迭代次数,激活函数,网络结构(层数、神经元数量等),正则化等。 | Batch Size;学习率,迭代次数,激活函数,网络结构,正则化,卷积核大小;卷积核数量;窗口滑动步长;边缘填充;池化层的类型、池化窗口大小和池化步长 |

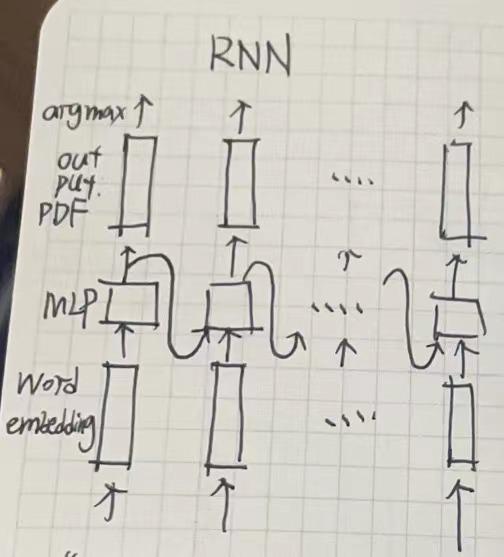

4. 入门:循环神经网络 Recurrent Neural Networks,RNNs

这里介绍的会稍微简单一点,许多内容如LSTM的工作原理我也做了折叠;在看第七章之前建议先保证速览过这一章,知道RNN是什么,和RNN的痛点。

图源基本来自台湾大学李宏毅教授的网课的PPT,文字讲解参考了人人都能看懂的LSTM。

4.1 Native RNN模型

4.1.1 为什么需要循环神经网络

很多时候,我们会希望一个模型拥有处理时间序列数据的能力。

例如,如果要翻译“这个知名作家的书都非常精彩”:

The books of the famous writer [are] all wonderful.

我们知道,当生成到writer时,这里下一个生成的词应该是are,而不是is。这涉及到对前文文本books的依赖。传统的MLP或者CNN是无法做到这�种连接的,因为他们会先输出the,而后输出books,而后输出of。每次输出,都不会留下记忆,所以输出【are】这个位置的单词的时候,自然不知道前面的books这个信息。

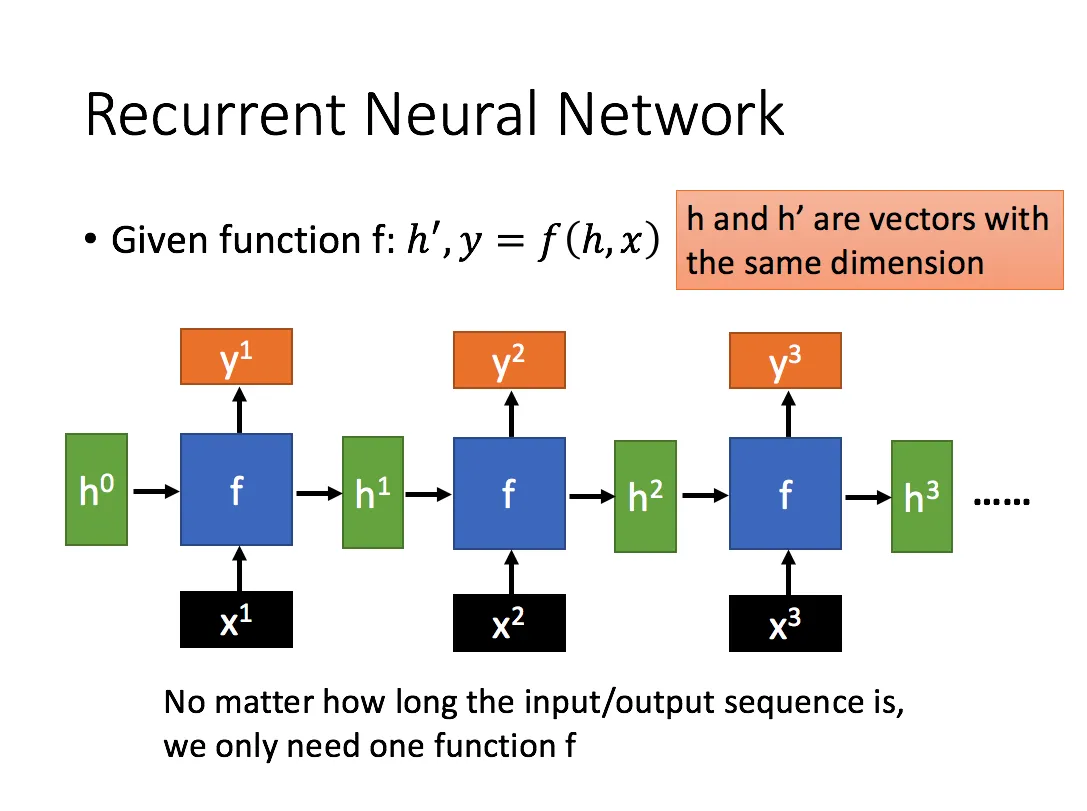

4.1.2 循环神经网络的结构

知道了我们要解决的问题后,就变得非常简单了:我们需要让模型有记忆力。一个办法是,每次模型输出的不只是目标单词,还有一个包含了之前的全部信息的中间特征H;而后,这个中间特征作为下一次训练的输入。

具体参考下表:

| TimeStep | 输入 | 输出 |

|---|---|---|

| 1 | Input1 | Output1 与中间特征H1 |

| 2 | Input2 和中间特征H1 | Output2和中间特征H2 |

| 3 | Input3 和中间特征H2 | Output2和中间特征H3 |

| …… |

于是就有了如下的模型结构:

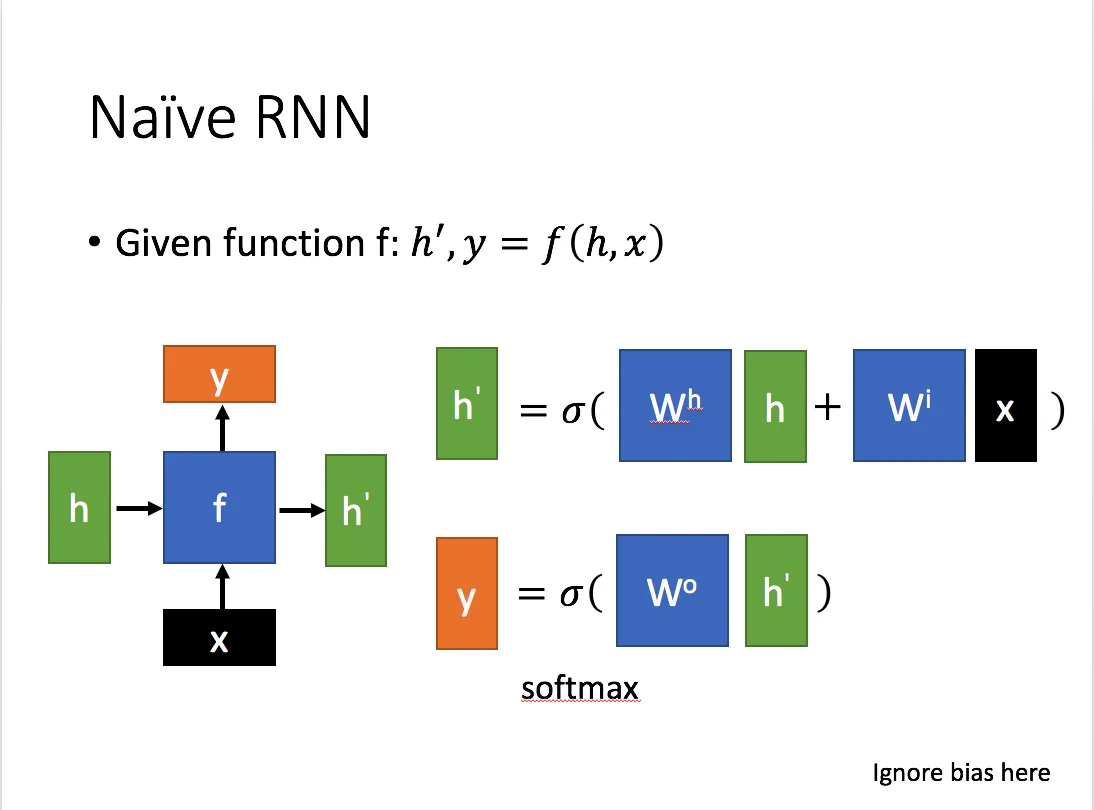

4.1.3 数学语言描述 RNN 结构的前向传播与反向传播

后面的文章中我们会大量提到RNN的梯度消失、梯度爆炸和长文本依赖的问题。

4.1.3.1 Native RNN前向传播的数学表述

当涉及到数学语言时,RNN的反向传播算法可以被描述为以下步骤:

假设我们有一个RNN模型,包含输入序列,其中 是输入序列的第 个元素,是输入序列的长度。同时,我们有一个对应的输出序列 ,其中 是输出序列的第 个元素。RNN模型的目标是学习一个映射函数,将输入序列映射到输出序列列。

RNN模型中,每个时间步 都有一个隐藏状态 ,表示在当前时间步的隐藏状态,其计算方式如下:

其中,是从上一个隐藏状态到下一个隐藏状态的权重矩阵,是从输入信息到隐藏状态的权重矩阵,是隐藏状态的偏置向量,是激活函数。

RNN模型的输出 可以通过隐藏状态 和权重矩阵 进行计算:

其中,是从隐藏状态到输出的权重矩阵, 是输出的偏置向量。

看懂了上面这些公式,其实也就看懂了Native RNN前向传播过程。这真没什么难的!

涉及到的权重矩阵:(连接两个隐藏层),(连接输入到隐藏层), (连接隐藏层到输出)。

涉及到的两列偏置:。

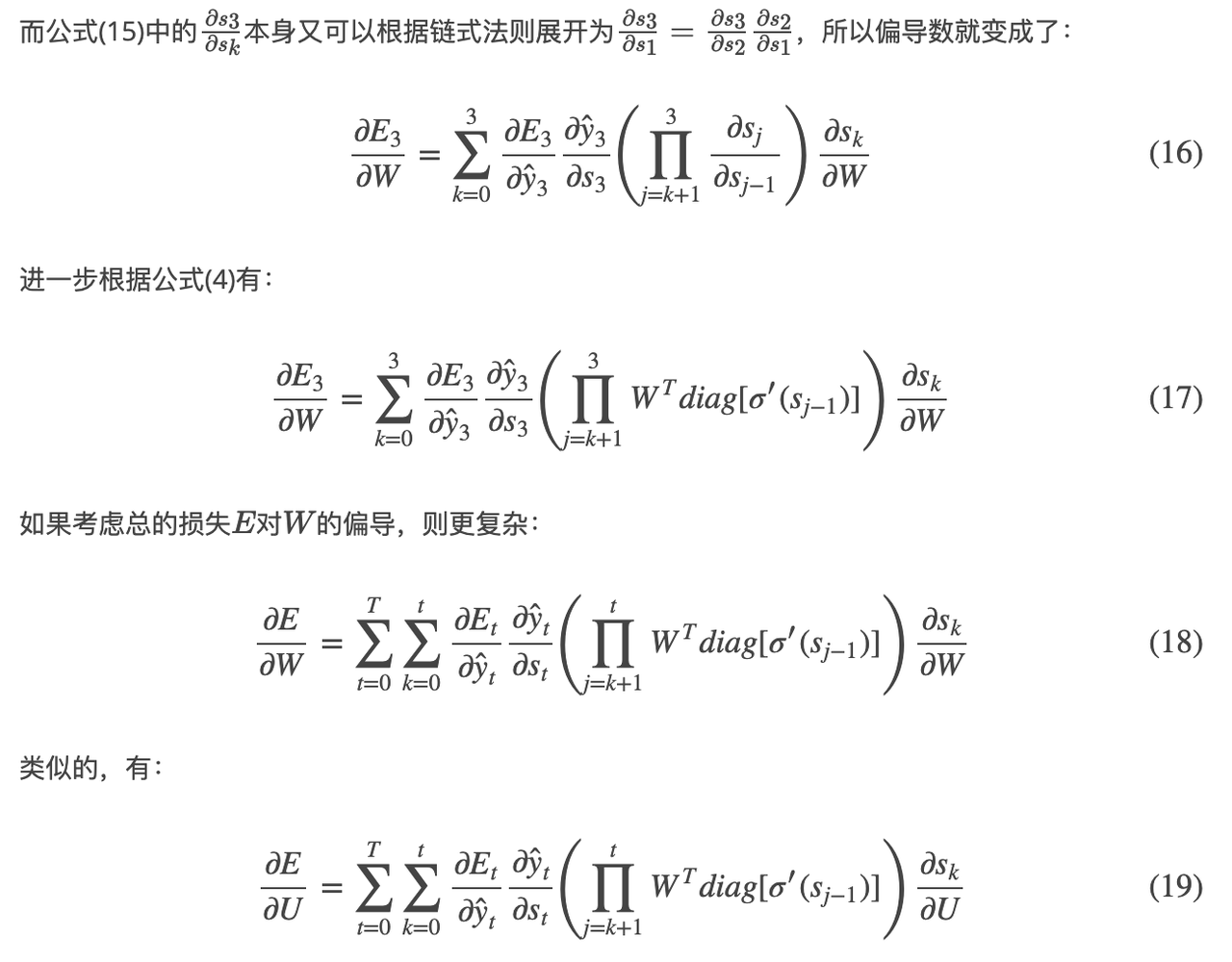

4.1.3.2 Native RNN的反向传播算法

RNN的反向传播在原理上和MLP的BP也是一样的,不过RNN和时间有关,导致RNN中的BP算法稍显复杂,名称也不一样,叫做backpropagation through time, BPTT。考虑到是入门文档,就不在这里手撕BPTT了!

感兴趣的话可以去参考论文:On the difficulty of training recurrent neural networks;参考右图,如果的的最大特征值小于1,则公式(18)和(19)的左边将以指数形式下降,造成梯度消失问题;类似的,如果的最大特征值大于1,则公式(18)和(19)的左边将以指数形式上升,造成梯度爆炸问题。

问题的来源总归还是在于RNN在不同时间步是共享了每一个权重矩阵的,所以反向传播的过程中难免要对同一个东西一直做连乘。

这个比较详细的解释了RNN的反向传播算法BPTT:CS224N(1.24)Language Models and RNNs | bitJoy

4.1.4 传统RNN的问题

Native RNN存在很多问题:

4.1.4.1 记忆力过强

在传统的 RNN 中,每个时间步的隐藏状态都是通过当前的输入和上一时间步的隐藏状态计算得到的,每个时间步的隐藏状态都包含了全部历史时刻的信息,因此随着时间步的增加,隐藏状态中的信息会越来越多,其中有价值的信息含量的比率会越来越少。

为了解决这个问题,我们要想办法给Native RNN引入遗忘机制。

4.1.4.2 处理长序列时存在梯度消失和梯度爆炸的问题

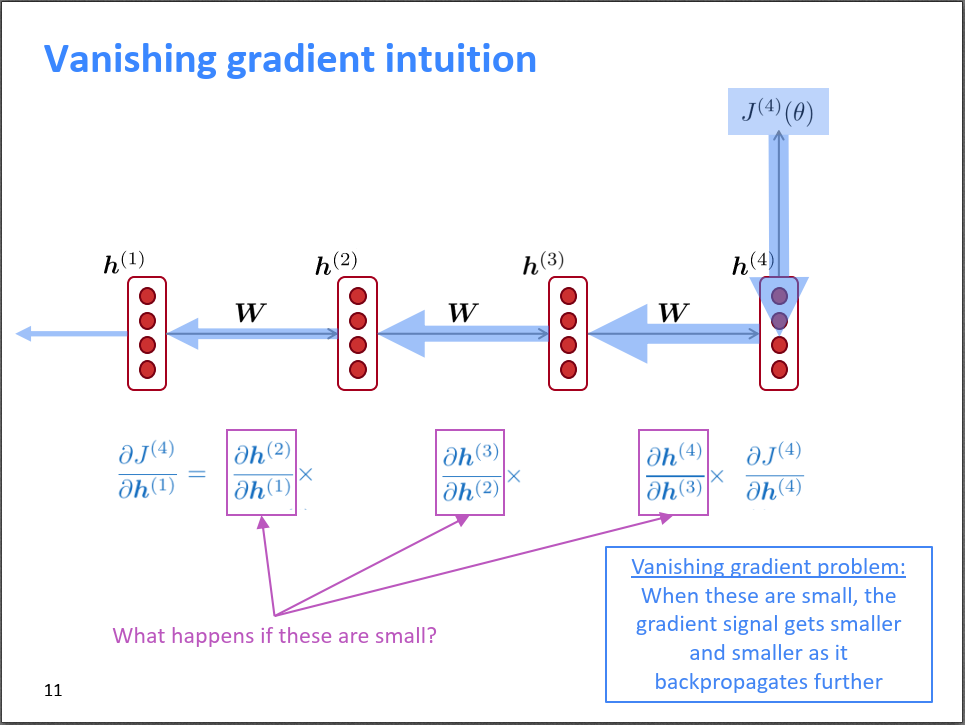

模型的记忆力过强不仅会降低信息的价值,还会导致处理长序列时的梯度消失和梯度爆炸等问题,从而导致模型难以捕捉到序列中较远的依赖关系。这会影响模型的性能和泛化能力。

-

在反向传播过程中,模型的梯度需要从输出端传回输入端,经过每个时间步的参数更新。

-

如果模型的记忆力过强,也就是在输入端的信息需要经过很多个时间步之后才能传递到输出端(可以参考我在4.1.2贴的那张自己手绘的图),那么在反向传播过程中,每个时间步的梯度都需要乘以相同的参数矩阵,这就会导致梯度指数级别地增加或减小,从而导致梯度爆炸或梯度消失的问题。

-

梯度爆炸相对而言比较好解决,通过梯度裁剪、调整学习率等方法就可以很好的控制,但是处理梯度消失就非常的麻烦(所以后面我们也会更多的关注梯度消失的问题)。当梯度消失时,网络就很难学习到序列中的长期依赖关系。

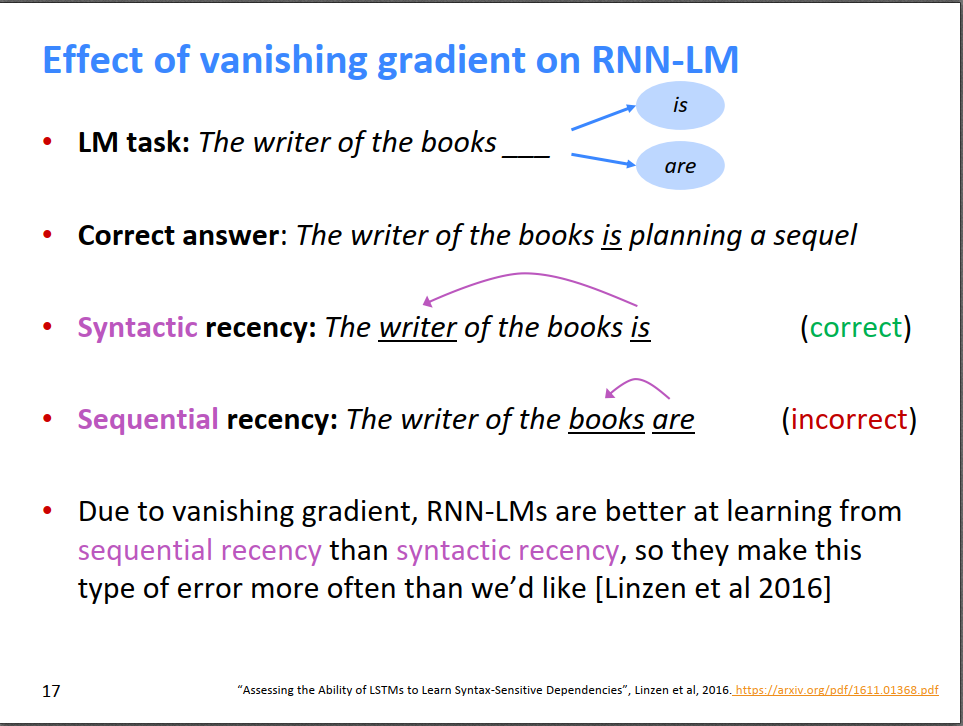

这些问题限制了传统 RNNs 在处理长序列数据时的应用,并且难以让模型获得良好的性能和泛化能力。为了解决这些问题,出现了许多改进的循环神经网络,如长短时记忆网络(Long Short-Term Memory,LSTM)和门控循环单元(Gated Recurrent Unit,GRU),这些模型通过引入门控机制来缓解梯度消失和梯度爆炸的问题,从而使得模型能够更好地处理长序列数据。

4.1.4.3 梯度消失带来的问题的直观感受

在4.1.3.2中,我们粗略介绍了RNN反向传播算法,说明了为什么RNN很容易产生梯度爆炸。

核心问题就是RNN在不同时间步使用共享参数,导致时刻的损失对时刻的参数的偏导数存在的指数形式,一旦很小或很大就会导致梯度消失或梯度爆炸的问题。参考上图,梯度不断反传,梯度不断变小(箭头不断变小)。

梯度消失会带来哪些问题呢?一个很明显的问题就是参数更新更多的受到临近词的影响,那些和当前时刻t较远的词对当前的参数更新影响很小。假设我们需要预测句子The writer of the books下一个单词,由于梯度消失,books对下一个词的影响比writer对下一个词的影响更大,导致模型错误的预测成了are,但这显然是不对的。

4.2 LSTM模型

前面提到,Native RNN的核心问题在于它的记忆力太强了,.会包含~的全部信息。所以我们需要设计一个模型结构,让模型可以去选择记住什么信息、忘掉什么信息,提高信息的价值,并解决梯度问题。

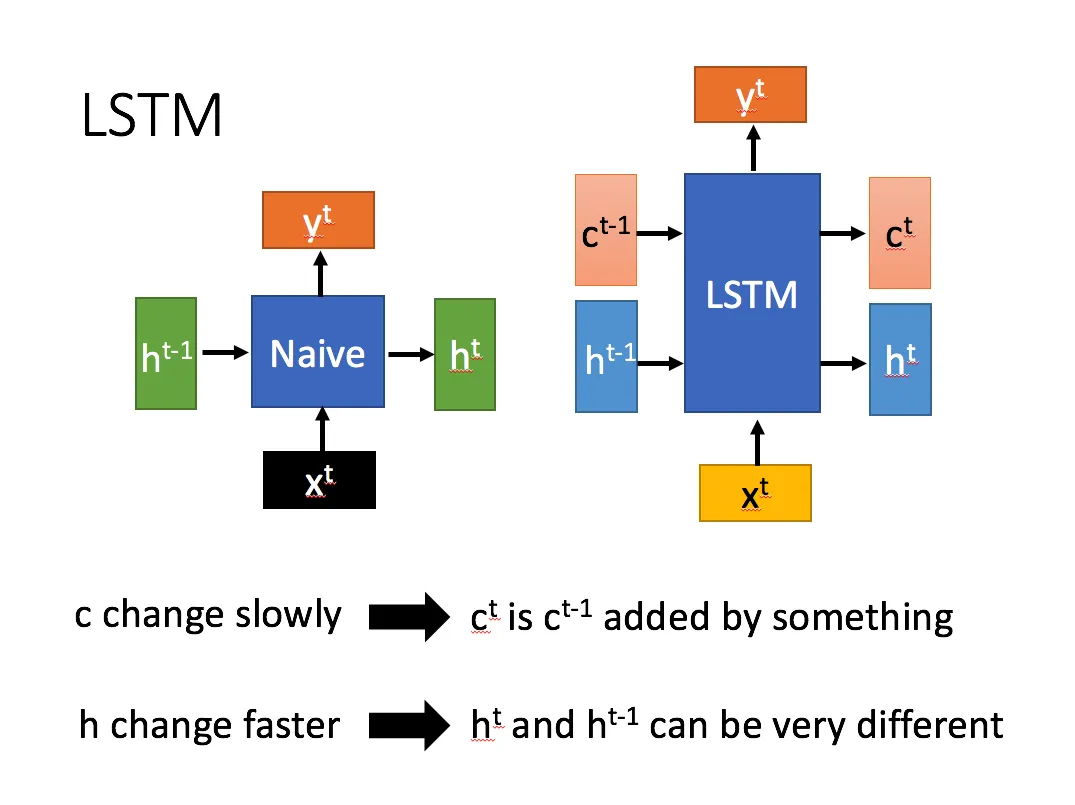

如果把LSTM视为一个黑盒而先不去考虑其内部结构,就有下面的LSTM模型:

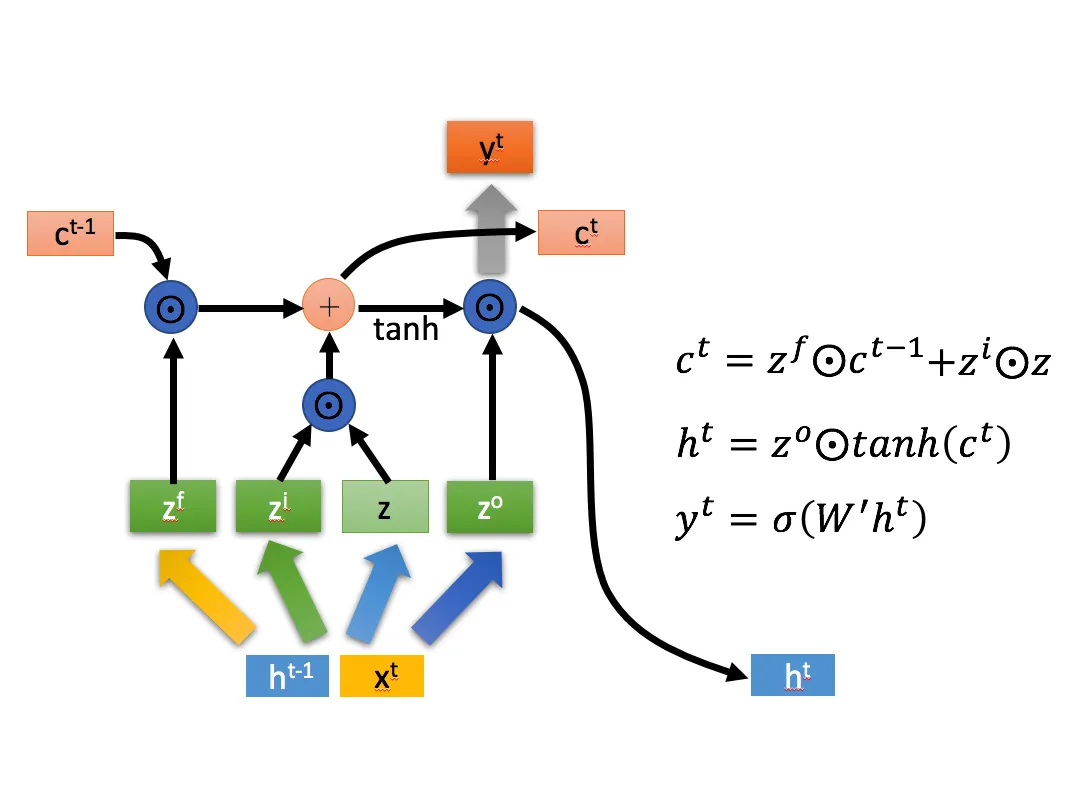

相比RNN只有一个传递状态 ,LSTM有两个传输状态,一个 (cell state),和一个 (hidden state)。(Tips:RNN中的 对于LSTM中的 ),他们都是向量。

其中对于传递下去的 改变得很慢,通常输出的 是上一个状态传过来的加上一些数值。 控制哪些信息会被遗忘,哪些信息会被留下, 则在不同节点下往往会有很大的区别。

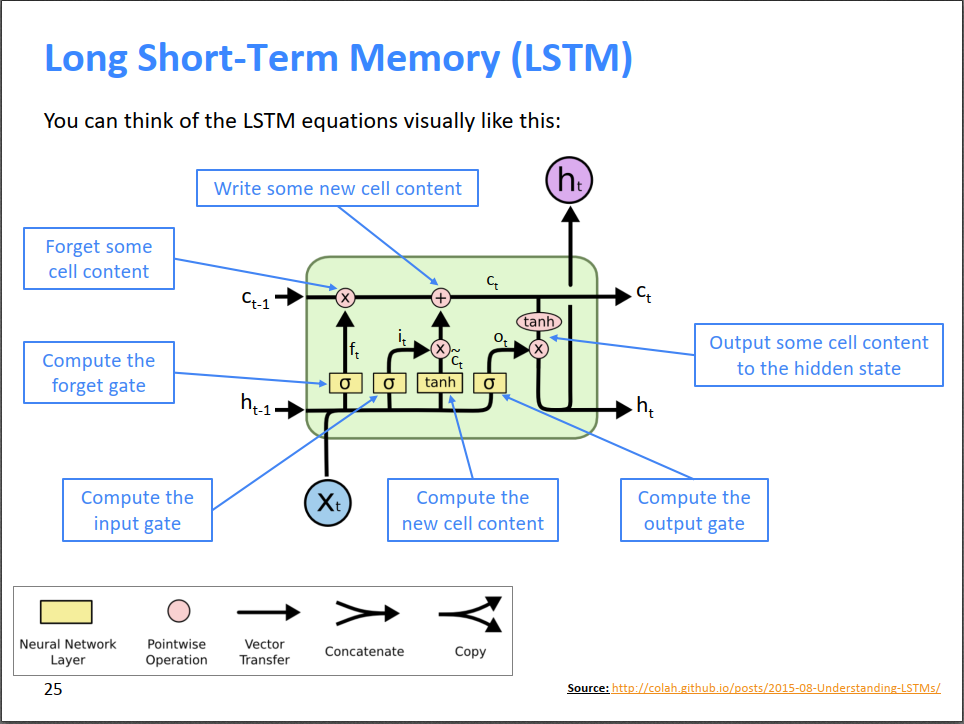

4.2.1 LSTM中的门结构

网上大多数阐述LSTM结构用的都是下面这张图。不过我不喜欢这张图!所以我们先不管它!

对于第一个时间步,隐状态和细胞状态可以是初始化为零向量,也可以使用一些预训练的权重或者其他先验知识来初始化和 ,来更好的训练模型。

对于第t个时间步,LSTM有三个��输入: , 和 。我们会直接把和 拼接到一起,成为一个新的更长的向量。

我们有4个权重矩阵: ,(f for forget),(i for information), (o for output)。每个权重矩阵都对应了自己的偏置,不过这里我们就先忽略偏置吧!

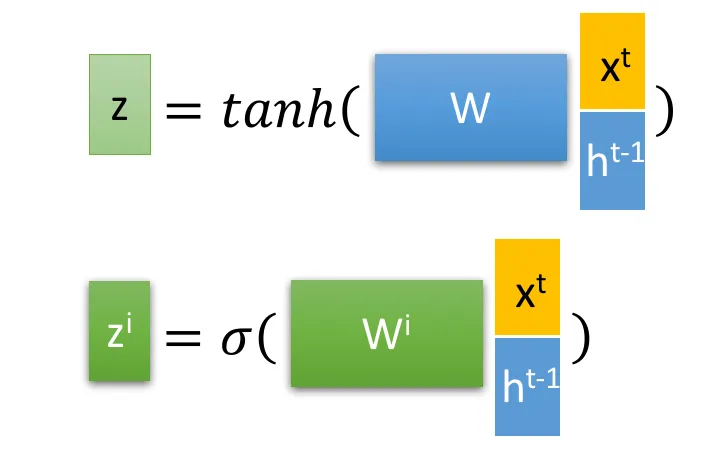

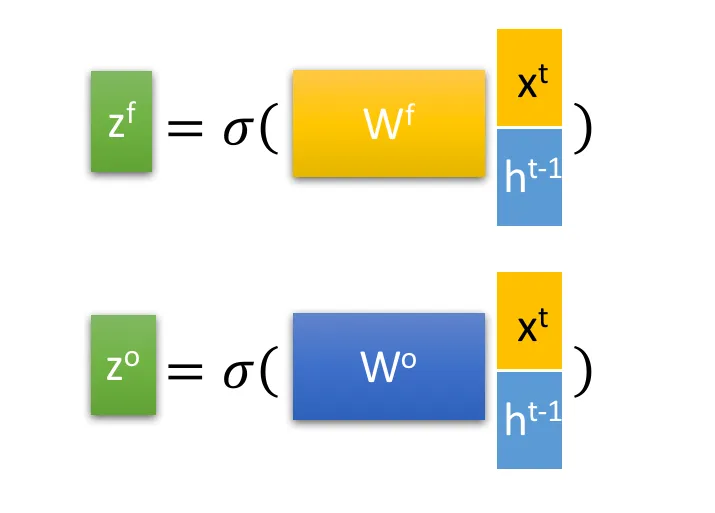

用 和拼接到一起的向量分别与这四个权重矩阵相乘,再用一个激活函数去激活,就得到了四个向量,,,。

<很多其他的资料会用 来代表这里的 ,会用状态候选向量代表这里的>

其中,只有是以tanh函数激活的,它后续会被作为一个输入向量;而其他三个向量后续都是作为门控向量之用,所以是以sigmoid函数激**(所以每个门控信号都是一个元素取值在 的向量,元素值离1越近,代表记忆下来的数据越多!!**)。

根据当前时间步的输入和 计算出了四个向量,,,后,我们来看:

4.2.2 LSTM中门控机制的具体实现

是Hadamard Product,也就是操作矩阵中对应的元素相乘,因此要求两个相乘矩阵是同型的。

例如:, 则代表进行矩阵加法(同型矩阵的对应元素相加)。

当然,在LSTM中,当前输入、隐状态、细胞状态、输入向量和门控向量,,都是向量,所以把这两个符号理解成向量中的对应元素做乘法/加法就好了

为了根据,和得到当前的和,LSTM内部主要有三个阶段:

- 忘记阶段。这个阶段主要是对上一个节点传进来的输入进行选择性忘记。具体来说是通过计算得到的 来作为忘记门控,来让上一个状态的 遗忘一些不重要的东西(不用去纠结什么是重要的、什么是不重要的,把它当成一个黑盒子。这个能力通过学习权重矩阵的参数来实现!)。

- 选择记��忆阶段。这个阶段将这个阶段的输入有选择性地进行“记忆”。主要是会对输入进行选择记忆。我们希望模型做到把重要的着重记录下来,不重要的就敷衍一点(这个能力通过学习权重矩阵的参数来实现)。

记忆门包含两个部分:一个sigmoid网络和一个tanh网络。

- sigmoid网络:门控信号 (i for information)来算出向量,其意义在于决定哪些信息要更新。

tanh网络:用一个权重矩阵来创建向量z(或者状态候选向量),他代表了这一步的输入信息。

�现在我们让,就相当于把当前输入的东西的有价值的东西给记了下来。

将上面两步得到的结果相加,即可得到传输给下一个状态的。也就是公式:

- 输出阶段。这个阶段将决定哪些将会被当成当前状态的输出。我们计算出的,通过了tanh,把每个元素都投射到了(-1,1),而后和向量做元素相乘,得到了这一个时间步的隐状态

算完当前时间步的隐状态后,我们再将其乘一个权重矩阵,得到的就是当前时间步的output 了。与普通RNN类似,输出的往往最终也是通过 变化得到。

参考【知乎】人人都能看懂的LSTM By知乎用户陈诚。

4.2.3 LSTM为什么可以缓解梯度问题

-

朴素RNN无法保存前期状态的原因就是因为朴素RNN把之前时间步的信息都一股脑存储在隐状态里了,而这个隐状态在每个时间步都要做这样一个操作:,于是隐状态就成了整个网络的瓶颈。

-

LSTM的关键就是开辟了一个新的cell来存储记忆,而对于每个时间步:。

-

其中,是遗忘门输出的向量,他的每一个元素都不过是一个0~1之间的实数,0表示完全忘记,1表示完全保留。因此,即使经过多个时间步长,细胞状态仍然可以被保留并传递到后面的时间步长中,因为它们受到遗忘门的控制,不会像传统的RNN那样随着时间步长的增加而指数级地衰减。

-

细胞状态的记忆也会受到连续梯度相乘的影响,但还是比RNN的隐状态要好很多。所以哪怕依然存在梯度消失或梯度爆炸的问题,从实际效果来看,LSTM性能很不错,也很鲁棒。

4.2.4 怎么对LSTM进一步优化?

我们可以看到,我们引入了非常多的内容,涉及到了5个权重矩阵: ,(f for forget),(i for information), (o for output), (从当前步隐状态到输出),以及各种偏置,所以模型参数变得很多。这无疑会让模型的训练变得更难。

所以,LSTM还有变体GRU,参考:人人都能看懂的GRU,By知乎用户陈诚。GRU很聪明的一点就在于,它采用了一些巧妙的构思,让一个门控同时可以进行遗忘和选择记忆,而LSTM则要使用多个门控,因此GRU很多时候都会更加实用。

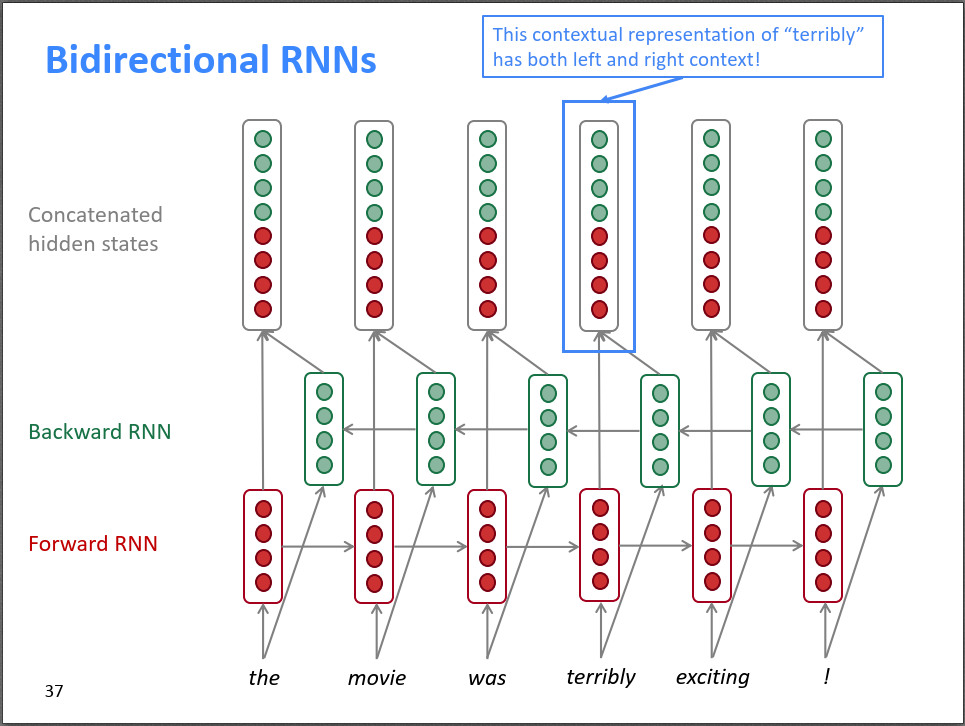

4.3 双向RNN:同时考虑左、右的信息

4.3.1 考虑两边的信息

Q:Terribly这个词在句子“Her answer was terribly exciting”中表达什么情感?

-

如果我们只从左往右看的话,我们很可能觉得这个terribly是贬义的,毕竟terrible嘛!而且模型很可能会去猜terribly这个词的下一个词会是wrong,她的回答大错特错!

-

但如果我们从右往左看的话,我们就会知道,这个terribly应该是褒义的,她的回答是如此振奋人心。

结论是��,对于很多下游任务,例如情感识别,我们最好能同时考虑左、右两个方向的信息!

4.3.2 双向RNN由两个独立的RNN构成

双向RNN其实就是从左到右按顺序输入,和从右往左按顺序收入的两个参数独立的RNN。

而后,我们会把两个RNN的输出(一个向量)拼接起来,作为整体输出(去做一个softmax)。

双向RNN的数学语言表述:

对于时间步t,会有两个隐向量,一个,一个。

从左到右的隐状态:

从右到左的隐状态:

输出:

正向计算和反向计算的权重不共享,即一个单层的双向RNN一共有6个权重矩阵:正向 U 、 V 、 W ,反向 U′ 、 V′ 、 W′ ;三个权重向量: b 、 b′ 、 c 。

双向RNN的应用:

-

双向RNN是无法用于语言模型的,因为语言模型在t时刻只知道t时刻之前的信息,并基于此预测t时刻的单词。如果直接给了我们整个词序列,让我们可以做双向,那就不叫语言模型了!

-

但是对于一个包含完整序列的NLP任务,例如文本分类、情感识别,我们就应该默认使用双向RNN。

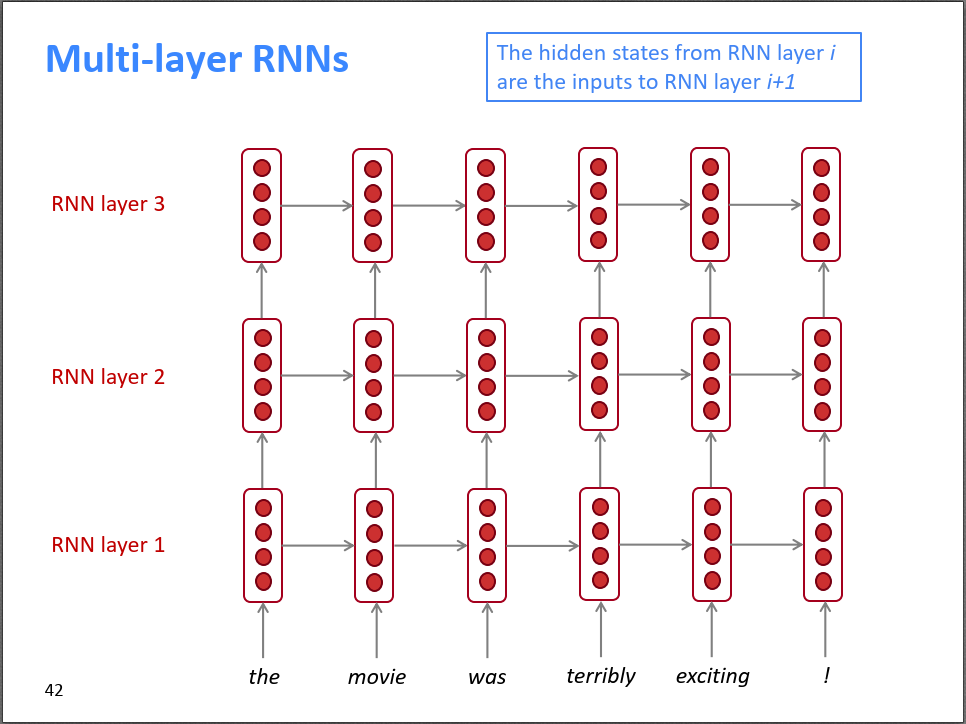

4.4 多层RNN Deep RNNs:堆叠下去,增加深度

4.4.1 多层RNN的结构

多层RNN其实也很简单,RNN Layer1的输出作为下一层RNN的输入。参考下图��:

4.4.2 Deep RNNs通常也不会很深

-

其实深度学习多多少少是一种炼丹+大力出奇迹,一般来说把模型堆叠下去,深度大一些,性能就会好一些(当然,我们得处理好梯度下降等问题)。

-

在处理视觉场景的时候,卷积神经网络动辄可以有几百层,通常会很深;但RNN往往是二层为主,最多也很少超过8层。原因其实在于RNN训练时是串行的,不易并行化。网络太深的话,训练起来会非常花时间。

4.4.3 什么是串行和并行,训练深层的RNN为什么格外花时间?

RNN的强项在于处理时序数据,每个时间步的输出都会依赖前一个时间步产生的隐向量,那么对于第t步,它必须得等到t-1步算完才能开始,无法并行处理。

以下图为例:

-

如果不是RNN的话,换点别的神经网络,对于输入W1、W2、W3、W4,各算各的,各自输出Y1、Y2、Y3、Y4,最后我们可以把Y1、Y2、Y3、Y4拼在一起。并行就是你干你的,我干我的,最后我们拼一起。

-

然而,对于RNN来说,参考下图:

-

首先我们得算出了H(1,1),才能去算H(1,2);算出了H(1,3),才能去算H(1,4)。

-

其次,如果我们想算出H(2,2),那么我们得把H(2,1)和H(1,2)都先算出来。想算出H(3,3),那么就得把H(3,2)和H(2,3)也都算出来。

-

我们假设向上箭头的计算速度和向右箭头的计算速度是一样的,矩形被运算完就会被填充,那么对于一个四层的神经网络,会按照颜色深浅的顺序,从浅到深一个一个填充完。

-

情况还可以更糟糕:对于Generative的语言模型,我们常常采用自回归的形式,上一步最终的输出会作为下一步的输入。在可以可以考虑:W1一路运算到了H(4,1),才输出了W2,而后W2再输入进去,算出H3的场景。

-

串行就是我干完了,你才能干。看上图其实我们也就能知道,如果输入序列非常长,例如一次翻译由几百个词的句子的话,RNN的训练速度极慢这件事情会格外的明显。

Note:RNN相较于CNN处理不能并行化,不是说无法同时进行多个“输入-输出”的样本批量处理,而是对于单个“输入”-“输出”的训练样本,其依赖于按照时间步顺序一个一个算,从而带来计算效率瓶颈。

GPU的牛逼之处在于超强的并行计算能力,RNN无法很好的并行,自然也就很难发挥GPU的优势,训练起来很难。

总之,深层的RNN训练需要很多计算资源,需要很长的时间,这就是为什么我们需要Transformer。

4.5 RNN总结

| 模型 | 卷积神经网络 CNN | 循环神经网络 CNN |

|---|---|---|

| 模型结构 |  |  |

| 类型与架构 | 前馈神经网络,不循环通常是有监督学习,依赖标注数据架构包括输入层、卷积层、池化层、全连接层。卷积层提取特征,池化层压缩特征。 | 循环神经网络,有一个循环递归和递归参数,具有记忆特性,上一时刻的输出可以作为下一时刻的输入;当前时刻当同时接受前时刻的输入和上一时刻的输出如果没有那个循环的话就是个简单的MLP,但加上了这个循环后反向传播变得非常复杂 |

| 典型模型 | LeNet;AlexNet;VGG;GoogleNet;ResNet | 最基础的RNN;LSTM;GRU |

| 优缺点 | 优点:卷积层通过使用局部感知性的卷积操作,可以有效地捕捉输入数据中的局部特征;在卷积层中,卷积核的参数在整个输入上是共享的,大大减少了需要学习的参数数量;高度可并行化;池化层进行下采样,减小特征图的尺寸,降低模型复杂性卷积神经网络非常适合用于图像识别,其高性能和易训练的特点是最近几年CNN流行的两个主要原因 | 优点:能够捕捉序列数据中的时序关系,通过循环连接使得网络可以记住之前时间步的信息,并在后续时间步中使用,从而能够处理具有长期依赖关系的序列数据。缺点:时序循环连接让BP非常复杂;时序循环可能导致梯度在反向传播过程中消失或爆炸;在处理长期依赖关系时可能面临梯度消失的问题,导致难以捕捉到远距离的时序关系。在处理长序列数据时,由��于需要逐步进行时间步的计算,导致计算效率较低循环神经网络非常适合用于具有序列特征的数据的识别 |

| 模型参数 | 卷积核权重与偏置;全连接层权重与偏置 | 以LSTM为例子:5个权重矩阵: W,W^f(f for forget),W^i(i for information), W^o(o for output), W'(从当前步隐状态到输出),以及对应的各种偏置。 |

| 超参数 | Batch Size;学习率,迭代次数,激活函数,网络结构,正则化;卷积核大小;卷积核数量;窗口滑动步长;边缘填充;池化层的类型、池化窗口大小和池化步长 | Batch Size;学习率,迭代次数,激活函数,网络结构,正则化;循环层的层数 |

5. 入门:强化学习 Reinforcement Learning, RL

5.1 强化学习的三层结构

5.1.1 基本元素:Environment, Agent & Goal 环境,玩家与目标

这一层包括Agent与其所处的环境(Environment)之间的交互。环境是Agent所面对的外部世界,可以是现实世界中的物理环境,也可以是虚拟环境中的计算机模拟环境。玩家(Agent)通过与环境交互来实现其目标,目标通常由任务或问题定义。Agent需要通过与环境的交互来获取反馈(如奖励信号)并不断优化其行为。

下围棋为例子,环境:棋盘;Agent:棋手;目标:赢得棋局。

玩马里奥为例子,环境:马里奥游戏的画面 Agent:操作的马里奥 目标:吃金币/通关救出公主

5.1.2 主要元素:State & Action 状态与行为

在强化学习中,Agent通过感知环境获取当前的状态(State)信息,状态可以是环境的观测值或者内部的状态表示。Agent根据当前的状态选择合适的行为(Action)来与环境交互,行为是Agent在某个时刻从可能的动作集合中选择的具体动作。

下围棋为例子,状态:棋盘上目前的棋子分布情况。行为:要把这一步棋下在哪里。

玩马里奥为例子,状态:当前的画面,包括金币、怪物的分布 行为:马里奥向左、向右、向上

5.1.3 核心元素:Policy & Value 策略与价值

策略(Policy)是Agent在特定状态下选择行为的策略,可以是确定性策略(确定性地选择一个行为)或者随机策略(根据概率分布选择行为)。价值(Value)是对不同状态或状态-行为对的评估,用于指导Agent的决策。

Agent根据策略和价值来选择行为,策略和价值的优化是强化学习中的重要任务。策略和价值的设计和更��新会影响智能体的学习和决策过程。

下围棋为例子,Policy:棋谱告诉我们面对怎样的棋盘,我们应该怎么下;价值:如果下的某一步棋帮助我们奠定了胜局,那么它的价值就非常大。

马里奥游戏为例子,Policy就是根据当前的怪物、金币、机关分布,我们怎么操作马里奥任务。价值:如果走的某一步导致被怪物杀死了,价值就应该是一个非常大的负数。

5.2 强化学习的核心内容

5.2.1 学习一个好的价值函数,从而去决定一个好的策略

主流的RL算法一般是基于价值的。

5.2.2 是试错学习,而非记忆学习

5.2.3 具有延迟奖励的特点,贡献度分配很重要

例如,围棋的每一步棋对胜利都有贡献,但奖励一开始全都是0,得赢棋了才能兑现。那得到reward之后,之前每一步的value要怎么分配? 这里涉及到贡献度分配的问题,复盘哪一步棋决定了胜势很关键。

5.2.4 Exploitation VS Exploration

以DQN的训练过程为例,

**利用:**用已有的价值函数,去选择价值最大的行动

**探索:**按照目前已有的价值函数给出的价值最大的行动来,而是尝试去优化价值函数本身,去探索一些其他的选择

一个很经典的例子是老虎机问题。上帝视角看,老虎机A的期望是100,B的期望是50,C的期望是0。那么显然我们应该一直玩老虎机A;但是在强化学习中,我们其实不知道老虎机A、B、C的期望函数,只能通过实践去猜测。

假设我们把A、B、C各尝试了10次,这10次中,A的均值为30,B的均值为35,C的均值为-10。那么此时我们可以有两种选择:1、继续选择B。如果我们无数次的去尝试B,最终B的均值会逼近真实期望50,而50无疑比20和-10都要大,那么我们的学习结果就是,三个老虎机中B是最好的。

2、尝试B之外的其他选项,例如尝试一次A,这次A输出了数字140,假设一下子把均值拉到了40,那么它就超过了35。最终,因为我们在遵循既有策略(B)的同时也兼顾探索了其他策略(A),发现了A其实是最好的,那么我们可能就会避免因为只去遵守策略,最终收敛于了局部最优解B。

5.3 强学学习的数学表达

5.3.1 Return 回报

回报的英文为Expected Cumulative Future Reward,即未来所有预期回报之和。

因为未来的奖励的价值没有现在的高,例如相比于明年拿到100元,我可能更偏好现在就拿到95元。因此,对于未来的奖励,我们会给他打一个折扣,称为Discounted Return:

其中,为第t次Action时系统给的奖励,是折现率,是一个介入0~1的实数。

5.3.2 State Value Function状态价值函数

给状态s打分;也可评价政策π的好坏

状态价值函数,指的是在当前的状态和政策下,未来所有的奖励的折现值。

状态价值函数只和π与s有关,告诉了我们在目前的政策下,当前我们的处境怎么样,我们的胜算有多少。

是一个随机变量,随机的来源在于:状态的变化随机。

5.3.3 Action-Value Function 行为价值函数

给动作a打分

行为价值函数反映了:基于一个政策函数π,在一个状态下,采取一个行动的回报的期望值。

是一个随机变量,随机的来源在于:1、基于Policy函数,Agent的行为随机;2、状态的变化随机。

最优行为价值函数 Optimal Action-Value Function:指的不管政策怎样,当前的一步行为可以产生的回报的上限。

的直观意义在于抛开政策的影响,对一个行为做评估。

5.4 价值学习

价值学习的目的:去想办法近似出一个行为价值函数。

5.4.1 Deep Q Network

我们用一个神经网络去近似。

我们知道是抛开政策不谈,给一个动作打分用的。

这个神经网络的输入就是当前的状态,如果我们在玩游戏,那么状态就是当前游戏的画面,我们通过卷积层把当前游戏的画面变成特征向量输入给神经网络;神经网络的输出则是输出一个给动作打分用的向量。假设当前在当前状态下,有3种可能的动作(left, right ,up),那么神经网络的输出就会是一个三维向量,每一维向量的元素就是根据的思想对动作进行的打分。

自��然的,系统应该去做打分最高的动作:。

而后根据该动作,系统自动根据状态迁移函数。到了下一个状态后,继续往复上面的动作,用神经网络给每一个动作打分,而后去做分数最高的动作。

5.4.2 强化学习中的梯度下降

上面讲清楚了DQN的基本思想,但问题在于,的参数一开始是随机初始化的,所以它是一个笨蛋裁判,根本就不懂怎么给动作打分。我们得想办法去训练这个网络,让这个裁判越来越专业,打分越来越准。

和前面的MLP等神经网络一样,用的其实也是梯度下降的算法。以下为例子:

从北京到深圳,模型Q(w)预计要q=1000分钟。实际旅程后,我发现只需要y=800分钟。误差200分钟,造成损失。

损失函数:

<(想起之前的了吗?就是他!)>

对损失函数求梯度:

而后对参数w进行梯度下降:

其中,为学习率/步长。

5.4.3 TD算法 Temporal Difference

TD算法的直观感受

有没有这样一种算法,再让我还没有到达深圳的时候,就可以提前得到更好的估计呢?

假设我们从北京先到上海再到深圳。我们经过了500分钟到了上海,此时模型预测还需要400分钟到深圳。

那么,最初的预测:Q(w)=1000分钟;最新的预测:y=500分钟(Actual)+400分钟(Estimate)=900分钟。

此时,新的预测:900分钟被我们称为TD Target。TD Target也是一种估计,但有事实的成分,显然比一开始的1000更可靠。用TD target的话,就可以实现无需跑完整个路程,就实时更新参数了。

损失函数:

<我们称为TD Error,这里为100>

对损失函数求梯度:

而后梯度下降即可。

DQN中TD算法的数学表达

公式:

我们知道,考虑折现率的回报函数为:

其实就可以类推到:

其中,就相当于在时间步t系统实际给的奖励;就是新的估计。这是不是就跟上面的从北京到深圳的例子一样了?

我们的目的是逼近最大价值函数,那么TD Target体现在哪里呢?

TD Target是这一步的奖励加上新的预测:

则根据TD Error我们有了损失函数:

我们根据这个损失函数计算梯度并进行梯度下降。

DQN网络中TD算法步骤总结:

-

-

预测:

-

求导:

-

根据当前的状态,决定了一个action,得到了一个奖励和新的状态

-

既然有了新的State,我们就又可以用Q网络预测新状态下最优动作的预期回报:。从而我们可以计算TD Target:

-

有了TD Target自然就有了TD Error:,我们据此做梯度下降:

5.5 策略学习

策略学习算法是用一个神经网络去近似策略函数,并且该策略函数可以让尽可能得大。

具体略,因为文档是为语言模型服务的,学完价值学习、DQN和TD算法后,其实就已经对强化学习的基本原理有了解了。如果想要深入了解的话,去看下面推荐的王树森的课程自学就好了。

值得注意的是,在RL中,我们可以使用奖励函数而不使用价值函数来训练策略,从而实现策略梯度算法。这种方法被称为纯粹的策略梯度方法(pure policy gradient methods)。也就是说,上面提到的东西中,Value是可以不要的。

5.6 Actor-Critic Method

推荐学习材料

- 若想要在一个小时以内快速的对强化学习有一个初步的认知,推荐PenicillinLP制作的《【强化学习】一小时完全入门》,视频做的非常有趣、易懂,而且也非常有条理的展现了强化学习思想的精髓。

- 若想要在数学语言推导上,对强化学习有较为完整的了解,愿意为此花时间,推荐王树森Shusen Wang的课程:王树森: Deep Reinforcement Learning

6. 入门:自然语言处理与语言模型 NLP & Language Model, LM

6.1 为什么机器这么难理解人类语言?

人类自然语言的多样性、灵活性、歧义性、上下文依赖性、语言的变化以及世界知识和常识的应用等因素都使得让机器难以理解人的自然语言:

-

多样性和灵活性:包括语法、词汇、语义、上下文等方面。同一个词汇在不同语境中可能有不同的含义,例如“他被杀死了”的“死”和“笑死我了”的死完全是两个含义。人们还经常使用讽刺、隐喻、比喻、口语和俚语等非字面意义的表达方式,比如“潘帕斯雄鹰真是这场盛典中的一匹黑马”,潘帕斯雄鹰指的是阿根廷队而不是一个动物,盛典指的是世界杯,黑马是比喻阿根廷队取得了超乎我们预期的表现。人是可以理解这些语言的,但机器想理解这些就非常困难。

-

语言的歧义性:自然语言中存在丰富的歧义现象,包括词义歧义、语法歧义、指代歧义等。例如,英语中的词汇"bank"可以表示银行,也可以表示河岸,其含义取决于上下文,这是词语歧义;The animal didn't cross the street because it was too tired,对于机器来说,这里的it可以指代animal,也可以指代street。这是一种指代歧义。这种歧义性对于机器来说是一个挑战,因为需要具有推理和语境理解能力才能够正确解析歧义。

-

上下文依赖性:人类自然语言中的表达通常依赖于上下文信息。例如,尽管大多数时候terribly的意思是负面的,但The movie is terribly exciting中,terribly的意义就是积极的。

-

世界知识和常识:人类在语言交流中经常依赖于世界知识和常识,即我们对世界的认知和经验。当我们说"我要花30元去伦敦看电影"时,我们知道电影是什么�,知道伦敦是个地名,知道30是个数字而元是货币单位。这种世界知识和常识对于理解自然语言是至关重要的,但对于机器来说,获取和应用这些知识是一项复杂的任务。

6.2 NLP的基本任务

6.2.1 文本分类 Text Classification

将文本分为不同的预定义类别,例如情感分类(积极情感还是消极情感,是否具有攻击性和恶意)、主题分类、垃圾邮件分类等。

6.2.2 命名实体识别 Named Entity Recognition, NER

命名实体识别(Named Entity Recognition, NER)是自然语言处理(NLP)中的一种任务,旨在识别文本中具有特定命名实体的片段,如人名、地名、组织名、时间、日期、货币、数量等。(陈先生和陈醋和陈仓里的陈是不一样的,我们希望机器能知道陈先生是人名,陈醋是个物品,陈仓是个地名,这样模型去做自然语言任务的性能才会提高)NER是许多NLP应用中的重要预处理步骤。

NER通常可以分为以下几种类型:

-

人名(Person):识别文本中的人物名称,如"John Smith"、"张三"等。

-

地名(Location):识别文本中的地理位置名称,如"New York"、"北京市"等。

-

组织名(Organization):识别文本中的组织、公司、机构名称,如"Microsoft"、"中国科学院"等。

-

时间(Time):识别文本中的时间信息,包括日期、时间、季节等,如"2021年10月1日"、"下午3点"等。

-

日期(Date):识别文本中的日期信息,如"2021-10-01"、"10/01/2021"等。

-

货币(Currency):识别文本中的货币信息,如"100美元"、"500元人民币"等。

-

数量(Quantity):识别文本中的数量信息,如"3个苹果"、"10米长"等。

NER任务通常采用监督学习方法,其中标注了已知命名实体类型的大规模标注数据用于训练模型。

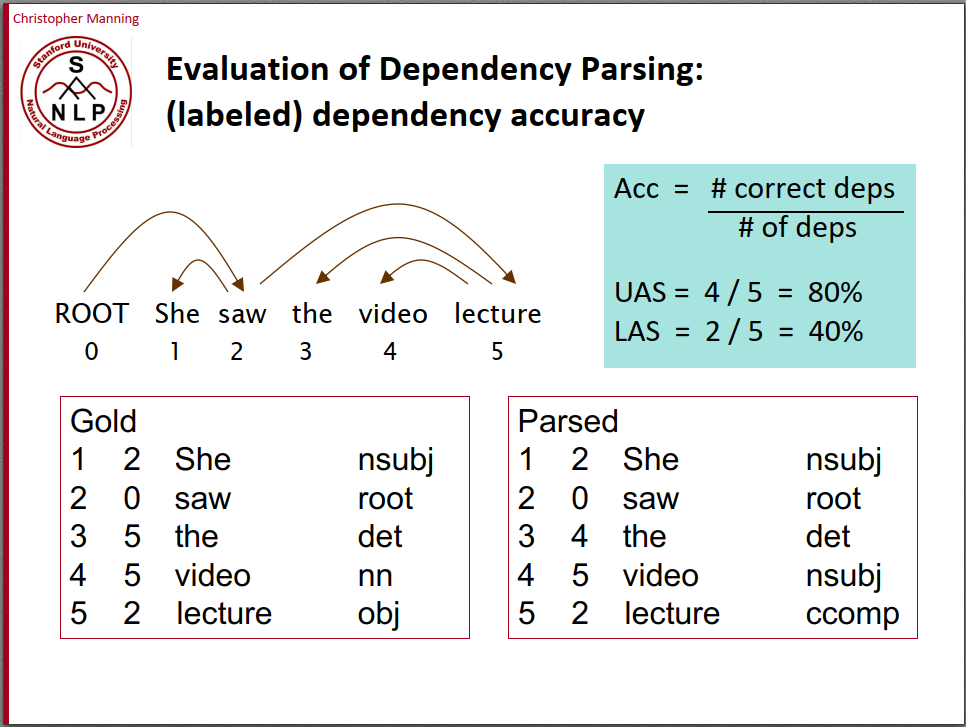

6.2.3 句法分析 Dependency Parsing

Dependency Parsing是指对句子进行语法分析并画出句子成分的依赖关系,比如对于句子“She saw the video lecture”,首先可以分析出主语、谓语、宾语等句子成分;其次可以分析出依赖关系,比如saw依赖于She等。这就是句法分析。

6.2.4 语言生成 Language Generation

-

**语言生成(Language Generation)**自然语言处理(NLP)领域中的一种任务,指的是使用计算机生成自然语言文本的过程。

-

语言生成可以应用于多种应用场景,如机器翻译、文本摘要、对话系统、自动生成文章、生成代码、音乐和艺术创作等。

语言生成方法可以分为以下几种:

-

基于规则(Rule-based)生成:通过预定义的规则和模板来生成文本。这种方法通常适用于生成简单的文本,如问候语、固定格式的消息等,但对于复杂的文本生成任务来说,Rule-based 方法的扩展性有限。

-

基于统计(Statistical-based)生成:使用统计模型来生成文本,如n-gram语言模型、隐马尔可夫模型(HMM)等。这种方法通过统计文本数据中的频率和概率信息,生成文本序列,但可能会受限于数据的数量和质量。

-

基于机器学习(Machine Learning-based)生成:使用机器学习算法来生成文本。例如,循环神经网络(Recurrent Neural Networks, RNNs)和变种(如长短时记忆网络,LSTM)被广泛用于生成文本,因为它们能够处理序列数据和捕捉上下文信息。

-

基于深度学习(Deep Learning-based)生成:使用深度学习模型来生成文本,如变种的生成对抗网络(Generative Adversarial Networks, GANs)和变分自编码器(Variational Autoencoders, VAEs)。这些模型通常能够生成更复杂和高质量的文本,但需要大量的训练数据和计算资源。

-

基于预训练模型(Pre-trained Model-based)生成:利用预训练的模型,如GPT-3、BERT等,来生成文本。这些模型通过大量的无监督训练从大规模文本数据中学习到了丰富的语言知识,可以生成高质量且多样性的文本。

6.3 语言模型 Language Model 定义

在不同的文章和材料中会看到对语言模型的不同定义,这可能会让人有些疑惑,不过下面我们都会讲清楚的。

6.3.1 估计一个给定词序列在语言上的合理性或者说概率

首先,对于任意的词序列,语言模型能够用计算出这个词序列是一句话的概率。

例如,对于: ,应该要有: 。

这其实是语言模型最早的功能,它的起源其实是Speech Recognition,即语音转文字!从音频转到文字的时候,会有很多个句子作为候选。那么哪个句子更合理?这种时候我们就可以用语言模型,对这些句子Make Sense的概率做一个排序。**对于语言模型的定义为:**语言模型(Language Model)是一种用于生成自然语言文本的概率模型。它可以估计一个给定文本序列(通常是一个句子或者一个短语)在语言上的合理性或者说概率:

给定一个词典,可以计算对于任意单词,词序列是一句Make Sense的句子的概率:

6.3.2 根据先前的文本序列预测下一个词,从而实现文本生成

当然,现在我们知道语言模型真正在做的事情是下一个词的预测和输出了。

最常见的的语言模型大概就是手机输入法,它能根据你当前输入的内容提示下一个字或者词。

不过这其实和上面的定义是一脉相承的。如果我们能预测词序列是一句Make Sense的句子的概率,那么我们自然也可以去预测词序列是一句Make Sense的话的概率。这样的话,已知,不就可以去选择一个了吗?

**我们这么补充语言模型的定义:**言模型可以根据先前的文本序列预测下一个可能出现的词或者字符,从而生成新的文本。如果是以已有的全部词序列为预测依据,那么,语言模型就是在求:

那么,语言模型的目标函数(损失函数)就变成了一个我们非常熟悉的东西(2.2.2.1):

还记得交叉熵损失函数吗?它就是模型理应输出1的那一维向量的元素的负对数。

其中,是巨大无比的语料库(Corpus),是一个个的词语,是模型的参数。我们训练语言模型的目的,就是在于调整参数,让模型接受这段话前面的词语们,尽量根据语料库,输出下一个词语。

所以,本质上语言模型就是一个基于概率的自回归填字游戏。

6.3.3 我们期待语言模型能有怎样的表现?

现在我们用V表示一个词典:,那么:

例如,对于: ,应该要有: ,因为猫和狗是相似的,卧室和书房是相似的,鱼和肉也是相似的。

我们希望语言模型有足够的泛化能力。

对于: ,我们当然还是希望: ,因为没人规定猫只能在卧室,不能在书房。

对于: ,我们自然也希望: ,因为猫确实可以有很多颜色。

但是我们也不希望语言模型太过于“灵活”发散:

对于: ,我们就不希望: 了!!因为狗真的不至于吃鱼!(有人跟我说他们家的狗就是爱吃鱼,但是无所谓了!!)

对于: ,我们就不希望: 了!!因为猫真的不大可能是紫色!

我们希望语言模型可以根据上下文发现词汇之间是相似的。

-

如果“NLP”和“自然语言处理”在语料中的上下文很像,那么语言模型就应该能发现,NLP和自然语言处理是一个意思。人类很容易就可以理解NLP就是自然语言处理,但是对于机器来说,这必须得学�习自他们相似的上下文。

-

同样的,如果我们已知了NLP和自然语言处理这两个词是一样的,那么它们的上下文应该也是相似的。

我们还可以做一些有意思的类比实验来测试语言模型的能力。

例如,如果我们用了词嵌入的方式来表示词汇,那么,应该有:

6.4 词嵌入 Word Embedding

这里可以回想1.4.1.2中我们提到的特征,还有1.5.1~1.5.3中我们提到的表征、局部表征和分布式表征。

还记得这张图吗?颜色用RGB来表示很天经地义,让这个例子很好理解。其实对于词语来说,也一样的!

6.4.1 One-hot向量

早期的NLP常用one-hot编码来表示词向量,假如词典中共有10000个词,则这个one-hot向量长度就是10000,该词在词典中所处位置对应的值为1,其他值为0。

在自然语言处理中,Token(词元)通常指的是将句子或文本拆分成单个独立的单词或标点符号。这个过程称为分词或标记化,它是自然语言处理中的一项重要预处理任务。

猫|在|卧室|吃|鱼 就是一个拆分成词元的过程。

在表示英文的时候,Token(词元)和单词不一样,Token是一个比单词更小的分割单位。

例如,如Her words interested me a lot,这里的word加了一个s就可以衍生出一个words,interest这个单词也可以变成过去式interested(这也可以是个形容词,of course),加了ing也可以变成进行时或者另一个形容词。如果给每一种衍生方式都单独编码,增加one-hot向量的维数,那么就太麻烦了。相比之下,不如只记录word,interest,s,ed,ing这几个Token。

具体可以参考:【个人博客】CS224N(2.14)Subword Models | bitJoy By Beeder。Subword Model是一个挺有意思的NLP研究方向,不过我们这里不打算详细介绍,我们只要懂它的思想原理�就行。

one-hot表示方法虽然简单,但其有诸多缺点:

-

词典中的词是不断增多的,比如英语,通过对原有的词增加前缀和后缀,可以变换出很多不同的词,one-hot编码会导致向量维度非常大,且每个向量是稀疏的;

-

不同词的one-hot编码向量是正交的,在向量空间中无法表示近似关系,即使两个含义相近的词,它们的词向量点积也为0。

6.4.2 词嵌入 Embedding

词嵌入就和用RGB表示颜色一样,用维度有限的稠密的向量来表示所有的词汇。不过 词嵌入一般不会只用3维向量。传统的Transformer中,词嵌入有512维;BERT中,词嵌入有768维和1024维两个版本。

此外,词嵌入中的向量的元素数字好像会更加意义不明。RGB我们知道代表三种颜色各自的灰度,但是词向量中的数字,恐怕除了计算机外就没有人能看懂了。

我们通过把One-hot向量通过一个权重矩阵投射到词嵌入里。

例如,对于一个有3000个词汇量的词典V,每一个词都是3000维的一个稀疏向量。对于每一个词,我们给他乘一个3000*512的权重矩阵,最终就得到一个512维的向量了。

Hey ChatGPT,一个3000维的one-hot向量,我们乘以一个3000*512的稠密的权重矩阵,会得到一个怎样的结果?

**ChatGPT:**果将一个3000维的one-hot向量乘以一个3000×512的稠密权重矩阵,得到的结果将是一个512维的向量。具体地说,one-hot向量是一个在3000维中只有一个元素为1,其余元素为0的向量。假设这个one-hot向量的第i维为1,那么乘以权重矩阵的结果将是该权重矩阵的第i列。"因此,乘法的结果将是权重矩阵中的第i列,是一个512维的向量。"

这样的操作通常被用于将离散的one-hot编码表示转换为连续的稠密向量表示,从而可以输入到深度学习模型等需要连续向量输入的场景中。这种转换可以帮助模型更好地学习特征和模式,并在许多自然语言处理(NLP)任务中得到广泛应用,例如词嵌入(word embeddings)、文本分类、语言生成等。"

<好啦,ChatGPT其实讲的很清楚了!权重矩阵本身是一个可以供One-hot向量查询的表,3000维的one-hot向量,每一个词对应3000行权重矩阵的一列,而权重矩阵的一列就是一个512维的列向量了~>

下面这段文字可以让我们更好的理解这件事。以后我们经常会碰到几个Embedding相加的事情(BERT:谁cue我?),如果好奇为什么词嵌入可以相加,那就回来看看这里吧!

“Embedding的数学本质,就是以one hot为输入的单层全连接。世界上本没什么Embedding,有的只是one hot。”

6.4.3 Word2vec及其训练方式

Word2vec是2013年发表的一项可以实现从One-hot到词嵌入的自然语言处理技术,它使用一个两层的神经网络模型,从大型的文本语料库中学习单词关联,将自然语言中的单词转换为数学向量。它可以将单词之间的关系表示为向量空间中的距离和方向,从而使得单词的语义信息可以用数学方式表示和处理。

还记得6.3.3里,我们提到的对语言模型所有的期待吗?Word2Vec模型就是实现我们的期待的一种方式!

Word2Vec能用向量来表示各种词元,可以用余弦相似度表明这些向量所代表的单词之间的语义相似程度、检测出同义词;可以为部分句子建议额外的词、捕捉到单词的语义和句法质量。

Word2vec的应用非常广泛,它获得单词级别的向量表示可以用于各种下游任务,例如用于语义分析、文本分类、机器翻译等NLP任务中。显然,单词级别的向量表示这件事情在各种NLP任务中都具有极高的通用性,训练出来的一个性能足够好的Word2vec并将其开源的话,大家就可以不用重复造轮子,而是一起用这个好用的模型了。

后面(8.1.5)会提到,word2vec可以说是NLP中的迁移学习的祖师爷!不过目前我们还没必要去管迁移学习这个名词,只要知道这是一个通用性非常强的工作,为各种NLP任务都提供了很好的帮助,就可以了!

Word2vec的作者Tomas Mikolov在Google工作期间,将word2vec的代码公开发布在了Google Code上。随着时间的推移,word2vec代码也逐渐迁移至GitHub上,并成为了开源社区中的一个重要项目。现在,大部分深度学习框架都提供了对word2vec模型的支持,因此使用和实现word2vec已经变得非常方便。

Word2vec的训练方法有两种:CBOW和Skip-gram。

前文提到:

如果“NLP”和“自然语言处理”在语料中的上下文很像,那么就可以推理出,NLP和自然语言处理是相似的。

同样的,如果我们已知了NLP和自然语言处理这两个词是一样的,那么它们的上下文应该也是相似的。

这两种思维分别对应了CBOW和Skip-gram。

**连续词袋 CBOW Continuous Bag of Words:**BOW模型根据上下文单词的平均向量来预测中心单词。不展开。

Skip-gram:Skip-gram模型会根据一个中心单词来预测它周围的上下文单词。不展开。

根据论文的作者(Distributed Representations of Words and Phrases and their Compositionality、Efficient Estimation of Word Representations in Vector Space),CBOW训练速度更快,而Skip-gram在出现频率更少的单词上的预测上表现更好。

在Tomas Mikolov的工作下,从16亿个单词的数据集中学习高质量的单词向量只需要不到一天的时间。COOL!

6.5 基于统计方法的语言生成:N-gram模型

6.5.1 条件概率的链式展开

前面提到,语言模型要做到预测下一个词的生成概率。这无疑是一个可以用链式展开的条件概率去求的东西:

而后,利用和,我们就可以求出了。好吧,这根本没法算!

6.5.2 马尔科夫假设

一个简化的思路是去假设一个词的出现不依赖于前面的全部词,而是仅仅依赖它前面的几个词,我们称这样的假设为马尔科夫假设。以三元语言模型(Trigram)为例,如果一个词的出现仅依赖于它前面出现的两个词,那么我们就称之为三阶马尔科夫假设,对应的语言模型就是三元语言模型:

这样就好算很多了。实践中常用的是3、4元模型,因为n太大语言模型的效果提升不显著,可是模型的参数量却会指数暴增。

6.5.3 n-gram语言模型的局限性

n-gram语言模型存在许多局限性:

-

只能提取将要生成的词语的前2~3个词的信息,做不到更多。然而,整个文本序列中,对于预测下一个词重要的信息绝对不只是这2~3个词,很多时候一个句子里面都存在长距离依赖关系。例如,The books of the famous writer的下一个词应该是“are”,但是如果只看前面3个词:the famous writer,机器就很可能生成一个is。那可真蠢!

-

本质上还是基于词语在语料库Corpus里出现的频率做概率的预测,无法解决相似性的��问题。例如,如果语料库里面,出现了100次我爱北京和1000次我爱厦门,那么,P(我爱厦门)会远大于P(我爱北京)。但两个句子无疑同样Make Sense。

-

稀疏问题。因为完全基于Corpus,而Corpus里非常见词汇的出现频率是非常有限甚至没有出现的,于是在计算条件概率时,会出现大量的分母为0的情况。稀疏问题指的是由于语料库中非常见词汇的出现频率较低,甚至没有出现,导致计算条件概率时分母为0或者极小的情况,从而影响模型的性能。

-

n-gram模型会非常的死板。根据语料库,n-gram模型会知道有黑车,白车,但预测不出来语料库里没有出现过的黄车。不过死板也未必是坏事,因为它不会去瞎编,只会根据语料库输出黑马,白马,而不说绿马。

6.6 基于前馈神经网络优化n-gram模型

通过词嵌入的方法,我们有了把文字转化为稠密的、维度有限的向量,从而输入给一个神经网络的能力。

根据MLP的万能逼近定理,我们知道,具有一个隐层的神经网络可以很好的逼近各种函数,非常适合用于拟合概率分布;而语言模型在做下一个词预测的时候,输出的其实也是一个概率分布。因此,神经网络非常适合用于语言模型。

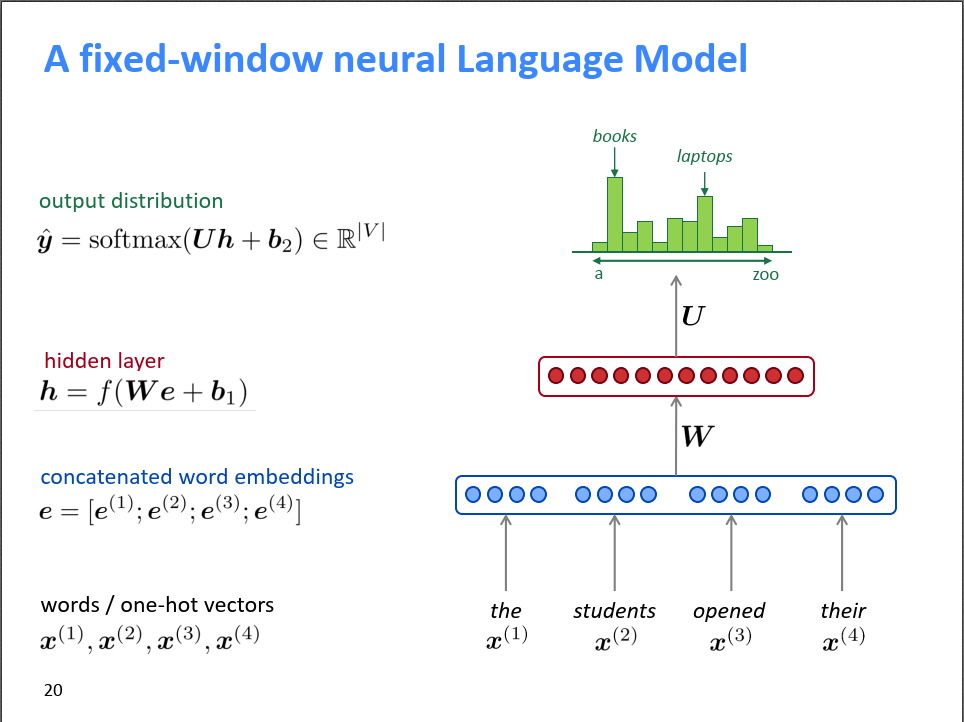

现在我们用FFNN去优化一个5-gram模型,即以前4个单词为输入,预测下一个词的输出。假设词嵌入是512维,词典中有3000个Token。

图源CS224N,右图展示5-gram前馈神经语言模型。

-

Input Layer:输入的句子就是前五�个词元构成的序列,每一个Token都对应一个稀疏的one-hot向量。

-

Projection Layer:我们把上一层输入每个one-hot向量通过乘一个权重矩阵,映射到词嵌入,并且把这四个词嵌入给拼起来变成一个2048维的向量。

-

Hidden Layer:输入上一层拼出来的2048维向量,以一个权重矩阵做一个全连接。

-

Output Layer: 是一个Softmax层,也是与上一个隐层的输出以矩阵做全连接,输出一个3000维的、每个元素都为正值的、元素之和为1的向量,即下一个词的概率分布函数了。

<参数集>

但只用FFNN去升级n-gram模型还是太low了,并没有克服一个本质缺点:他的窗口数是固定的,每次预测新词都只依赖前n个词。

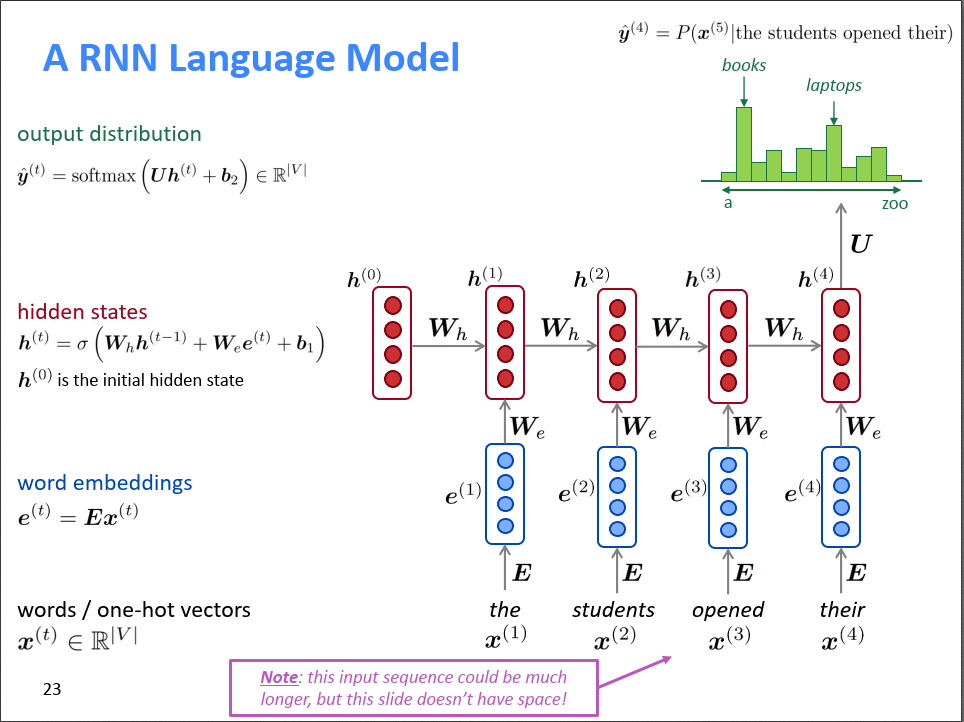

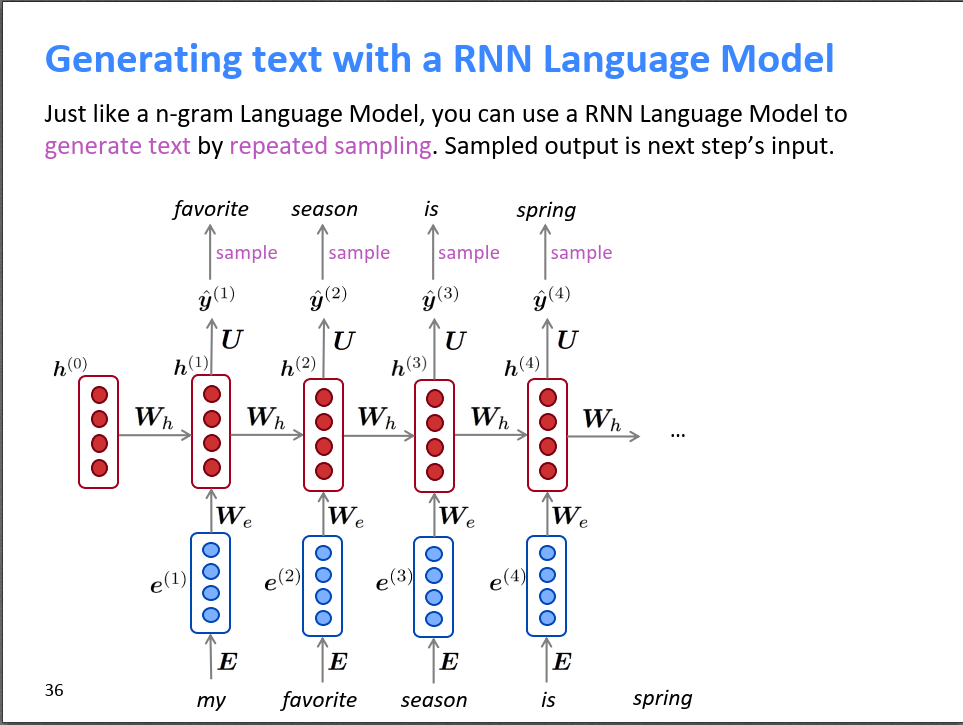

6.7 基于循环神经网络的语言模型

<参数集>

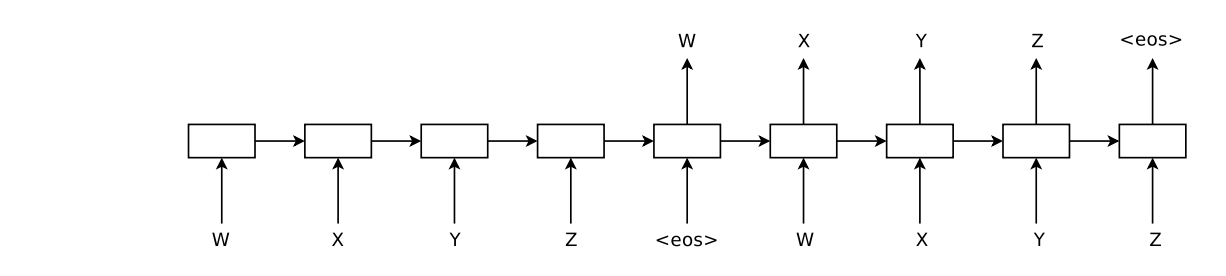

做语言生成(LM)时,一般采用自回归的形式,上一步的输出作为下一步的输入!

RNN相比于固定窗口的神经网络,其优势是:

-

不受输入长度限制,可以处理任意长度的序列

-

状态可以感知很久以前的输入的信息,因此理论上可以解决长文本依赖问题。

-

模型大小是固定的,因为不同时刻的参数都是共享的,不受输入长度的影响。

然而其劣势也很明显:

-

虽然理论上t时刻可以感知很久以前的状态,但实际因为隐状态h的记忆力过强,存在梯度消失的问题,实际上效果远没有我们想的要好。

“``虽然RNN理论上能建立长距离依赖关系,但由于梯度爆炸或梯度消失问题,实际上学到的还是短期的依赖关系”(这个可以用LSTM、GRU比较好的缓解) -

因为无法并行计算而是串行计算,所以训练起来特别慢(这个哪怕改用Fancy RNN也一样是个问题,解决不了)

6.8 推荐学习材料

6.8.1 视频材料

探讨NLP的视频介绍材料,无疑要拿出大名鼎鼎的NLP网课Stanford-CS224N。

【Youtube】Stanford CS224N:NLP with Deep Learning

Stanford CS224N:NLP with Deep Learning

6.8.2 文字材料

【个人博客】Stanford-CS224N-NLP with deep learning By Beeder

7. 开始进入正题!seq2seq模型与注意力机制Attention!(2014)

细讲seq2seq对了解大语言模型有重大的意义:它启发了序列自编码器,这对于后来出现的NLP的自监督学习很有意义。而且Encoder-Decoder的架构也在Transformer里出现。

主要参考资料:

【arxiv】Sequence to Sequence Learning with Neural Networks

整理了12小时,只为让你20分钟搞懂Seq2seq By 知乎用户蝈蝈

【个人博客】CS224N(1.31)Translation, Seq2Seq, Attention | bitJoy By Beeder

7.1 seq2seq结构:以其在NMT中的应用为例

seq2seq是一个很强大的模型,不但可以用来做机器翻译,还可以用来做很多NLP任务,比如自动摘要、对话系统等。不过它最早是用来做机器翻译的,而且翻译确实是一个很经典的场景,所以这里我们先拿翻译举例。

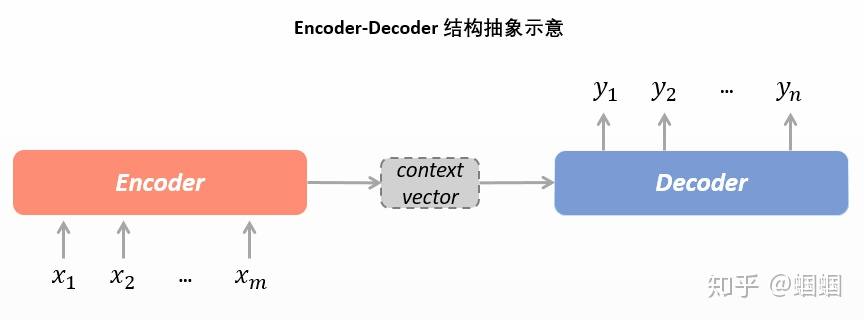

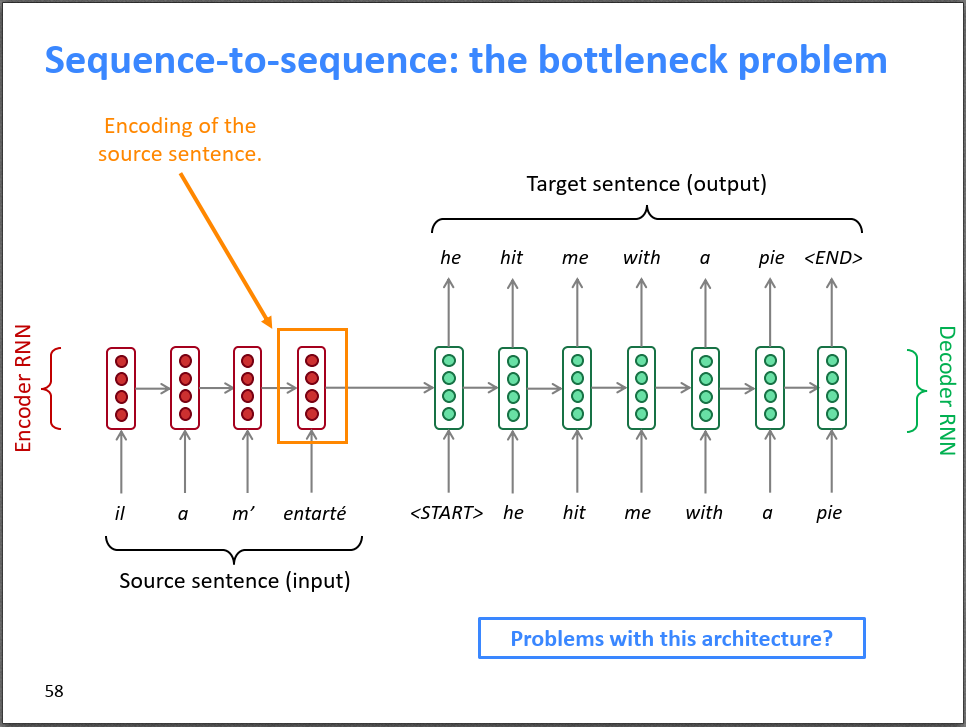

神经机器翻译(NMT)用了seq2seq的结构,它的另一个常见的名字是编码-解码器(Encoder-Decoder)结构。

叫seq2seq的原因,在于其输入和输出都是一个词序列。那就是sequence to sequence,即seq2seq。

-

**编码器 Encoder:**取输入文本,将输入的文本(词序列)整体编码成一个表示向量,而后交给Decoder进行解码。在编码器中,输入的词会变成一个one-hot向量,而后经过Embedding层投射到一个(512维的)向量空间,随后输入到RNN的结构里面去(这个RNN一般是LSTM,而且可以是双向等结构,而且可以有很多层,即把神经网络搞的很深,从而可以去提取更高级的特征)。

-

**Context Vector:**过了编码器中的RNN的一系列计算,输出来的对源文本整体的一个表示向量。

-

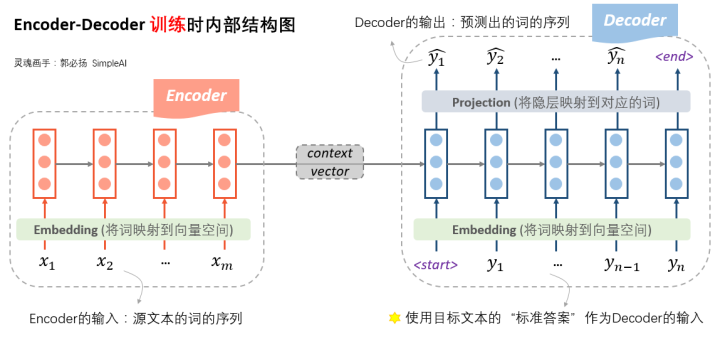

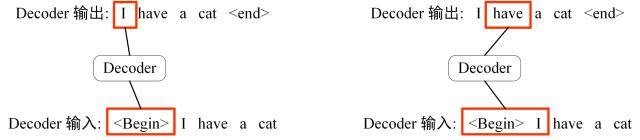

**解码器Decoder:受编码器编码出的输入(以及标准答案的词序列),自行生成文。**NMT中,Decoder的输出是预测出的词的序列,但输入在训练和预测时有所不同。

Encoder RNN负责对源语言进行编码,学习源语言的隐含特征。Encoder RNN的最后一个神经元的隐状态作为Decoder RNN的初始隐状态。

- **训练时:**受编码器给出的表示向量和“标准答案”作为输入。参考左图,根据第一个输入<start>符号和编码器送来的表示向量,先生成了预测结果。而后,根据第二个输入符号(而不是前一步的预测结果),我们生成预测结果.

很好理解,那么损失函数就是前一步最终生成的整个词表的概率分布与标准答案对应的one-hot向量的交叉熵函数,我们基于这个损失函数对RNN网络做梯度下降,从而让模型预测的越来越准。

- 预测时:自产自销,每一步预测的结果,都送给下一步作为输入。这样的输出方法我们称为自回归(Auto-regressive)。参考下图,根据第一个输入<start>符号和编码器送来的表示向量,先生成了预测结果。而后,根据前一步的输出(而不是标准答案),我们生成预测结果.后面我们会知道,GPT就是一个自回归的文本生成模型。自回归形式天然适合Generative的 场景,这不难理解,就像是我们写文章是从左往右边写边想的一样。

Decoder的初始隐状态是基于Encoder RNN的输出,所以我们把Decoder称为一个条件语言模型。

7.2 详解Decoder:他就是个语言模型

7.2.1 为什么训练和预测时的Decoder不一样?

Decoder在训练时是根据标准答案做输出,而预测时则是在自产自销。为什么要做这种区分呢?

这里其实涉及到两种不同的Decode方式:

-

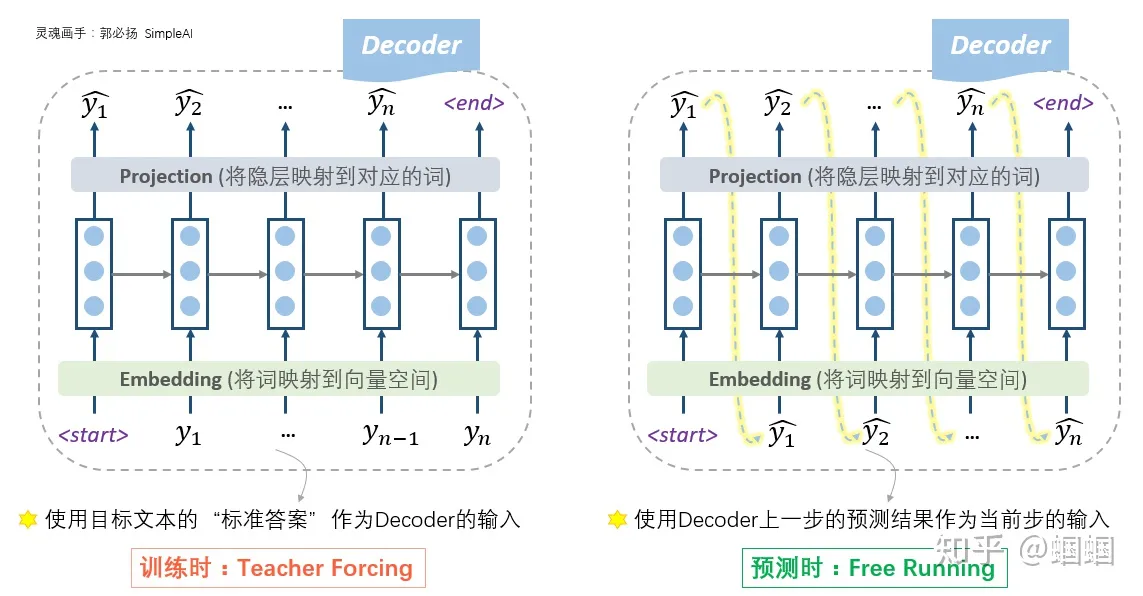

根据标准答案来Decode的方式,我们称为Teacher Forcing。

-

根据上一步的输出作为下一步输入的Decode方式,Free Running。

“其实,free running的模式真的不能在训练时使用吗?——当然是可以的!从理论上没有任何的问题,又不是不能跑。但是,在实践中人们发现,这样训练太南了。因为没有任何的引导,一开始会完全是瞎预测,正所谓“一步错,步步错”,而且越错越离谱,这样会导致训练时的累积损失太大(「误差爆炸」问题,exposure bias),训练起来就很费劲。这个时候,如果我们能够在每一步的预测时,让老师来指导一下,即提示一下上一个词的正确��答案,decoder就可以快速步入正轨,训练过程也可以更快收敛。因此大家把这种方法称为teacher forcing。所以,这种操作的目的就是为了使得训练过程更容易。”By 知乎用户

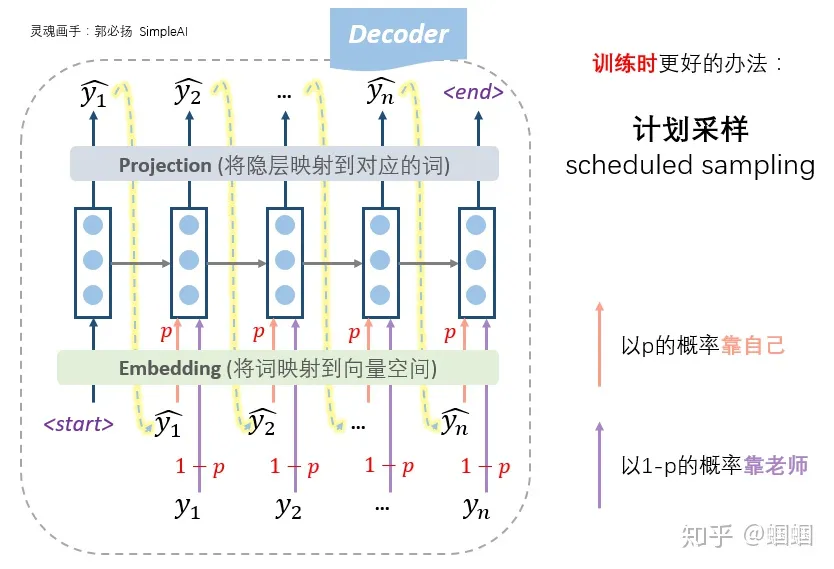

7.2.2 计划采样 Scheduled Sampling

Decoder一上来就瞎预测自己来跑,就像是我们高中盲目刷题,在完全没有老师指导的情况下不断积累自己瞎jb写题产生的经验,可能越走越偏;一直按照标准答案来训练,就像高中刷题时一直看着正确答案来写,如果真上了高考考场,没了标准答案,那就忽然蒙圈了。。

所以,更好的办法,也是更常用的办法,是老师只给适量的引导,学生也积极学习。

计划采样:我们设置一个概率p,每一步,以概率p靠自己上一步的输入来预测,以概率1-p根据标准答案来预测。

7.2.3 贪心算法 VS Beam Search

7.2.3.1 Greedy Decoding

如果我们每一步都预测出概率最大的那个词,而后输入给下一步,那么这种方式我们就称之为Greedy Decoding。

但是Greedy Decoding这件事情肯定存在一些问题。

比如,你用你的手机输入法去打字的时候,它也是会猜你的下一个词,并且按概率排序的!那如果我们一直点击输入法给你推荐的第一个词……

eg.我用iPhone打了“不要”两个字,而后一直只点击苹果系统自带输入法推荐的第一个词。就有了下面这段文字:

不要再来了,我们的生活方式是什么时候回来呢,我们的生活方式是什么时候回来呢,我们的生活方式是什么时候回来呢,我们的生活方式是什么时候回来呢,我们的生活方式

嗯,甚至还循环起来了。这可真蠢!

这其实体现了贪心算法的一个问题:Greedy只能保证每一步是最优的,但却无法保证预测出来的句子整体是最优的。特别是如果在时刻贪心选择的词不是全局最优,会导致时刻往后的所有预测词都是错误的,这样就没有回头路了。为了解决局部最优全局最优的问题,我们常常会采用Beam Search方案。

7.2.3.2 Beam Search

Beam Search的思想是每一步都多选几个可能的序列作为候选,最后综合考虑,选出最优组合。

具体方案如下:

-

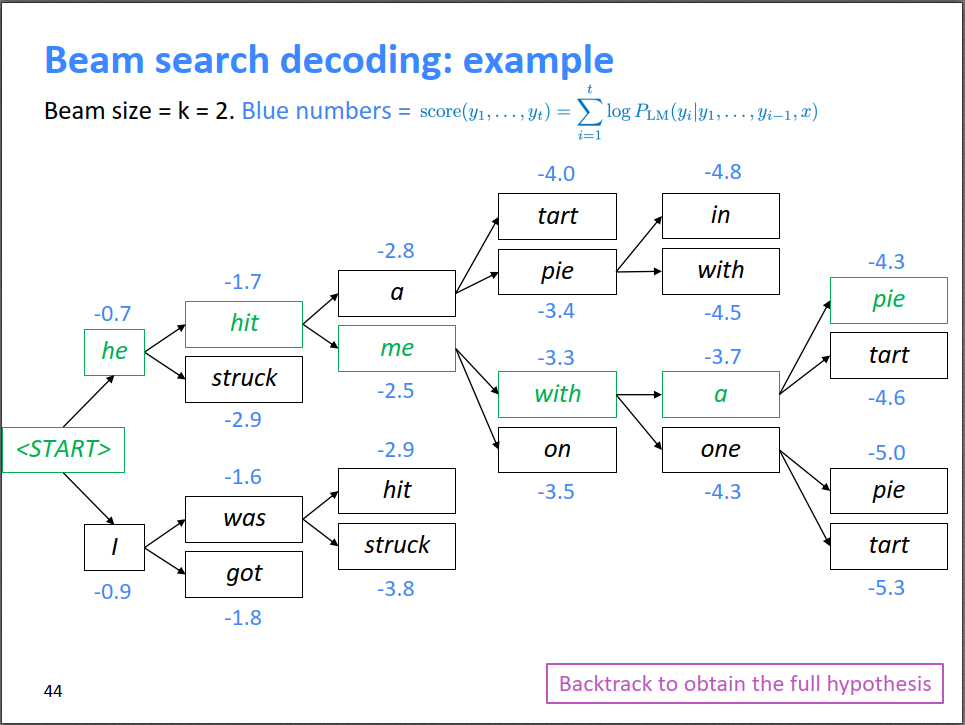

设定候选集大小 Beam size = k(右图中,k=2;实践中,k一般等于5~10)

-

对于每一个时间步,我们会以当前概率最高的k个序列集作为输入,各自预测概率top-k的下一个词,从而产生个候选序列。在这个候选中,我们留下k个概率上最有可能的序列集,作为下一步的输入。<一定要注意,这里的Top-k不仅是指一个序列集的k个最高概率的,还指最终会从的序列集中留下k个得分最高的序列>(参考右图,t=3的时间步时,top2是[he hit]和[I was],所以下一步时是这两个序列继续预测下一个词,并且产生四个概率最大的分支;[he stuck]和[I got]会被剪枝,保证beam search过程的复杂性不会指数放大)

-

在beam search的过程中,不同路径预测输出结束标志符<END>的时间点可能不一样,有些路径可能提前结束了,称为完全路径。我们会暂时把这些完全路径放一边,其他路径接着beam search。

-

Beam search的停止条件有很多种,可以设置一个最大的搜索时间步数,也可以设置收集到的最多的完全路径数。当beam search结束时,需要从n条完全路径中选一个打分最高的路径作为最终结果。

-

我们使用如下的score函数来定**「序列得分」:**。序列得分全都是负的,而且越高越好。Beam search打分是累加项,越长的序列会打分越低,所以在最终决定要选择哪一句时,需要用长度对打分进行归一化:。

-

Beam search作为一种剪枝策略,并不能保证得到全局最优解,但它能以较大的概率得到全局最优解,同时相比于穷举搜索极大的提高了搜索效率。

7.3 注意力机制 Attention

7.3.1 朴素seq2seq的信息瓶颈

朴素的seq2seq神经机器翻译模型中,我们用Encoder RNN的最后一个神经元的隐状态作为Decoder RNN的初始隐状态。这里存在一个问题:Encoder的最后一个隐状态(Context Vector)承载了源句子�的所有信息,成为整个模型的“信息”瓶颈。

其实不妨去想一想,在Encoder的RNN中,编码完il、a、m'的时候,中间都是有隐向量、、,但最后输入给解码器的只有最终的。有没有这么一种可能,在解码器输出“hit”这个词的时候,相比于用被更新过的,其实用原始的或者,效果反而会更好?

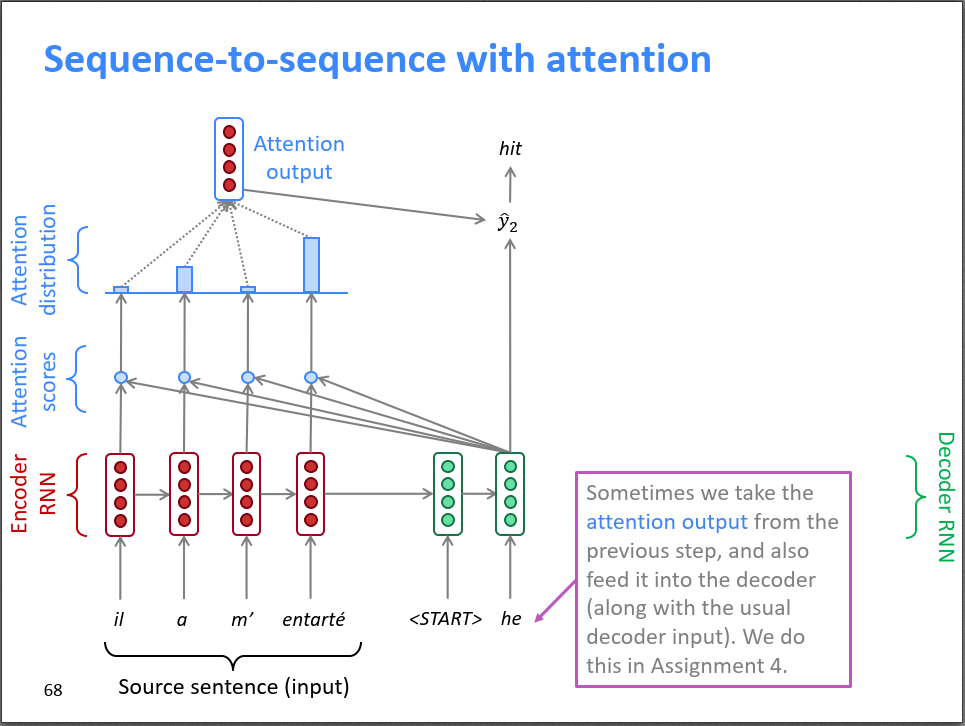

注意力机制就是希望打破这个信息瓶颈。宏观来看,Attention直接把Decoder中的每一个隐层,和Encoder中的每一个隐层,都连接起来了!

7.3.2 Attention机制的直观理解

*前面提到了,“Attention直接把Decoder中的每一个隐层,和Encoder中的每一个隐层,都连接起来了。”*样的话,Encoder RNN的最后一个隐状态就不再是“信息”瓶颈了。

我们在解码的时候,是一个词一个词生成的。对于每一个词,它不仅可以接受Context Vector作为辅助信息, 也可以通过“直连”线路去获取Encoder RNN中的其他的隐状态的信息,从而Decoder的解码进行辅助。

参考左图中的Decoder的第二个时间步,我们以he为输入,并且综合考虑了il、a、m'、entarte的隐状态。可见,"he"时刻的注意力主要分布在Encoder的第2和第4个词上,解码器最终做出了输出hit的决定。

7.3.3 Attention机制的数学表达

7.3.3.1 向量的点积操作

点积(Dot product)是线性代数中的一种运算,它是同维两个向量之间的一种运算方式,通常用符号“·”表示。

对于两个向量 和 ,它们的点积定义为: ,

也就是说,点积将两个向量中对应位置的元素相乘后再求和。因此,点积的结果是一个标量(Scalar),表示两个向量的相似程度或者两个向量在同一方向上的投影长度。

总之,我们需要知道两件事:1、点积的结果是一个标量 2、点积的结果反映了两个同维向量的相似程度

7.3.3.2 Attention机制的步骤

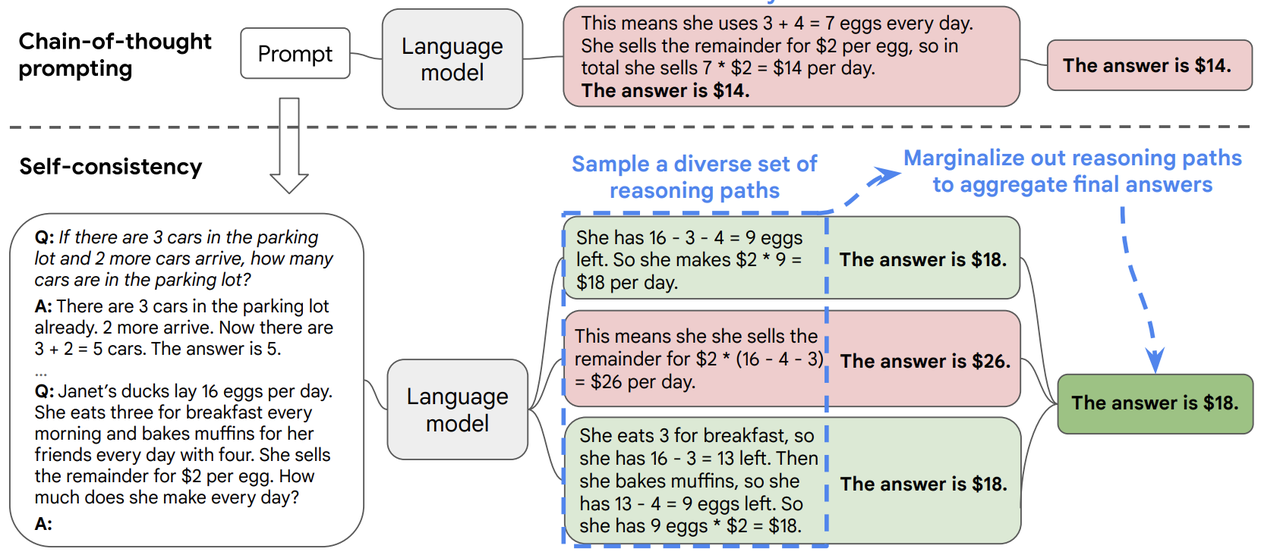

- 在时刻, Decoder有隐状态,同时也有Encoder所有时刻的隐状态。我们将和所有的编码器的隐状态分别做点积,得到N个标量Attention score(注意力得分)。这N个标量构成一个N维向量,它反映了解码器中当前时间步的隐状态与编码器中各个时间步的隐状态的相关性打分。

- 我们使用Softmax对这些权重进行归一化(这些隐状态的和为一),就得到Attention distribution(注意力分布)。就像任何通过Softmax函数得到的向量一样,Attention Distribution也是一个概率分布。这个Attention distribution告诉了Decoder在时刻,更应该把“注意力”放在Encoder的哪些隐状态上。

- 接下来,我们对Encoder所有隐状态使用Attention distribution进行加权求和,得到Attention output(注意力输出) 。<既然注意力分布是一个概率密度函数,那注意力输出其实很类似数学期望>。

解码器t时刻的注意力输出:

- 把注意力输出把和该时刻的隐状态拼起来,再进行非线性变换,就得到输出。

7.3.3.3 Attention机制带来的好处

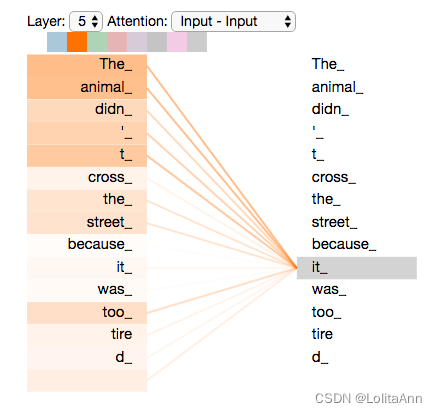

想象机器要翻译这么一句话:The animal didn't cross the street because it was too tired.

it指的是谁呢?是street,还是animal?根据下图,我们可以看到,解码器处理it这个词的时候,注意力机制能够让it和“The animal”关联起来,并将其融入到it的编码中。

在seq2seq架构中,Attention机制可以带来以下好处:

-

解决了信息瓶颈问题:在传统的seq2seq模型中,编码器将整个源序列编码为一个固定长度的向量;而Attention机制可以让解码器在每个时间步上,根据源序列中不同位置的信息进行不同程度的“聚焦”,充分利用源序列中的信息,提高模型的表现。

-

提高处理长序列的能力,提升模型的泛化性能:Attention机制可以使模型对输入序列的长度更加鲁棒,不会因为输入序列长度的变化而影响模型的性能。这是因为Attention机制会根据不同的输入序列长度自适应地调整“聚焦”的程度,使得模型可以有效地处理不同长度的输入序列。

-

增加模型的可解释性:Attention机制可以让我们更加直观地理解模型在生成每个输出时“关注”了源序列中的哪些部分,并且可以通过可视化Attention权重来直观地观察模型的注意力分配情况,从而更好地调试和优化模型。例子可以参考上面的可视化图。

-

提高翻译效果:在机器翻译任务中,Attention机制可以将源序列中与目标序列有关联的部分显式地“聚焦”,从而提高翻译效果。例子同样参考The animal didn't cross the street because it was too tired的翻译。

-

有助于缓解梯度消失问题,因为Decoder的每一时间步都和所有Encoder的隐状态相连了。

自从seq2seq和NMT横空出世以来,机器翻译取得了巨大的进展。从前的机器翻译的至高点——SMT(统计机器翻译)都是极其复杂的,涉及到大量的特征工程,海量的专家知识,无数的资源积累,繁多的功能模块,还需要庞大的人力去维护。现在直接被一个很深很深的神经网络干翻在地!大量特征工程师&语言专家失业SOS

7.4 还有一些想说的

7.4.1 NMT确实牛逼,但还有一些问题

seq2seq用于神经翻译,在性能上肯定是非常优秀的,但它依然存在一些问题:

领域不匹配。很多时候,我们在Wikipedia、论文、新闻稿等这种比较正式的语料库中训练,那么用来翻译Twitter,甚至在游戏国际服里和外国人的交流这种口语或者非正式语料时,就会有问题。

长文本的翻译,目前介绍的都只是翻译一个句子,句子相对来说还是比较短的,如果要翻译一篇论文或一本书,那么怎样考虑非常长距离的上下文依赖关系?

对一些惯用语、俚语等翻译容易闹笑话(说曹操,曹操到;笑死我了;等等)

讲这些的目的其实还是想要铺垫后面的预训练大语言模型。

7.4.2 Attention开始变为深度学习的一种通用技术

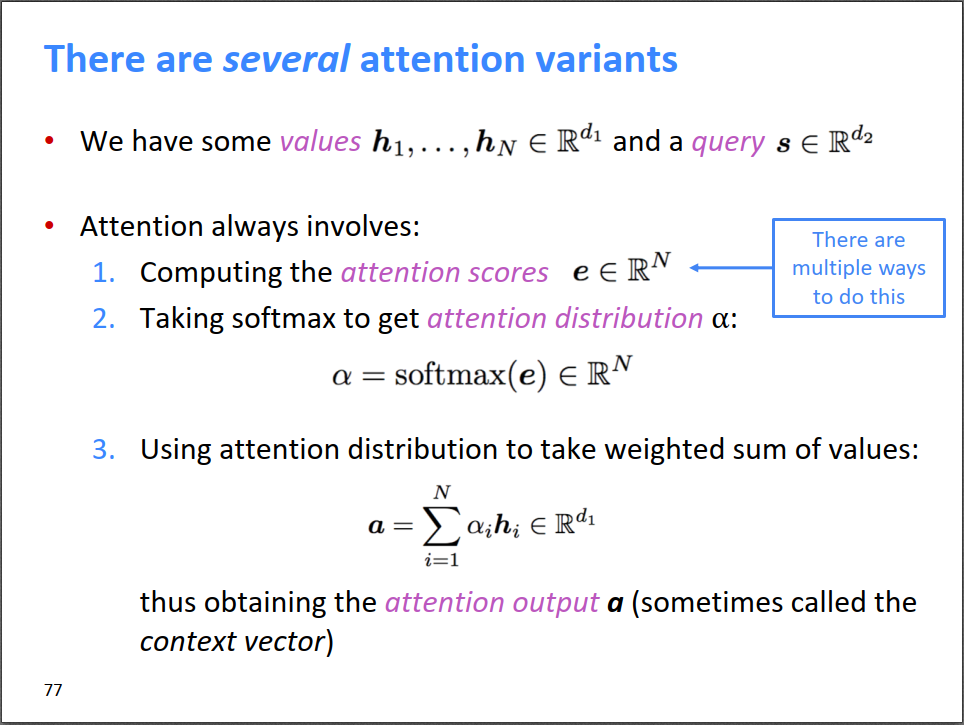

现在,Attention已经变成了DL的一个的通用技术,并不局限于seq2seq和机器翻译。其一般的定义是:

-

给定一系列values集合=[],和一个查询向量,用和中的每个向量做点积,得到对=[]的注意力得分;

-

对得分向量进行softmax运算,得到注意力分布。

-

用注意力分布对=[]进行加权平均得到Attention output,它是关于查询q的一个摘要summary。

-

Attention有很多变体,变体的关键在于注意力得分的计算机制。

我把Attention的矩阵运算给折叠了,因为基本是纯数学,感兴趣的话再自己打开看吧!

7.4.3 Attention机制中点积操作的矩阵运算

7.3中,我们在seq2seq里首次提到了注意力机制,我们知道了在Attention机制中,点积操作用于计算输入序列和输出序列中每个位置的相关性得分。在seq2seq里参与点积的分别是Encoder中每个时间步的隐状态和Decoder中每个时间步的隐状态。

假设我们有两个矩阵:目标序列构成的矩阵 和查询序列构成的矩阵,其中 和 分别表示两个序列中的向量。在更普遍的注意力机制中,我们需要计算每个查询向量 与目标序列中每个位置的相关性得分。为此,我们可以定义一个注意力得分矩阵 :

其中,矩阵的第一行的每一个元素分别代表分别和 中的每个元素做点积得到的标量,第k行的每一个元素就分别代表查询序列的分别和目标序列的元素们 做点积得到的标量了。

= *

前面提到了,点积的结果反映了两个同维向量的相似程度。那如果对矩阵 的每一行都做Softmax,每一行其实就是“查询序列的和目标序列的某一个元素是相关的”的概率的分布。

因此注意力机制的计算过程其实很简单,就是两个矩阵的乘法运算。

后续在Transformer的自注意力层中,我们还会再见到类似的操作,他们发生在Key矩阵和Query矩阵之间。

8. RNN时代的BERT和GPT!Semi-Supervised Sequence Learning: 怎么用大量无标注样本去做自监督学习?(2015)

自监督学习:对于样本x,自动生成一个输入x'和该输入理应对应的输出x''(往往是Ground Truth)。模型根据x'输出了y,而后y和Ground Truth x''做交叉熵损失函数,而后反向传播。

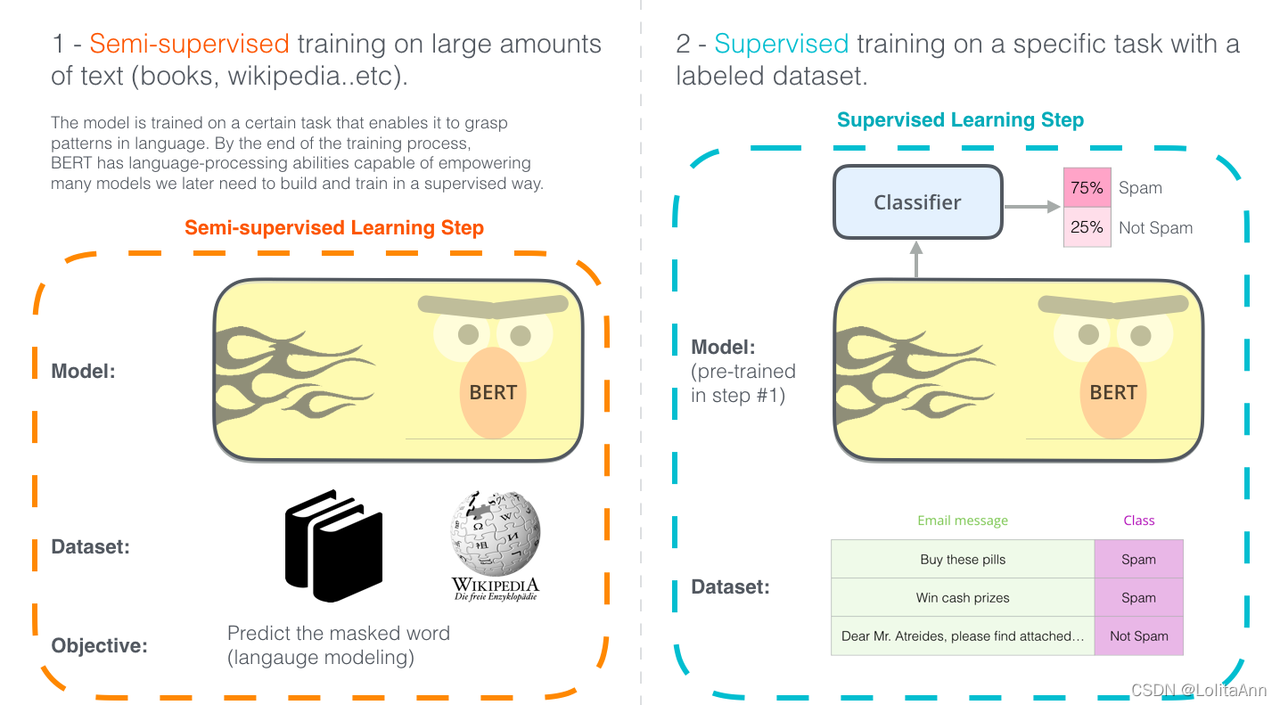

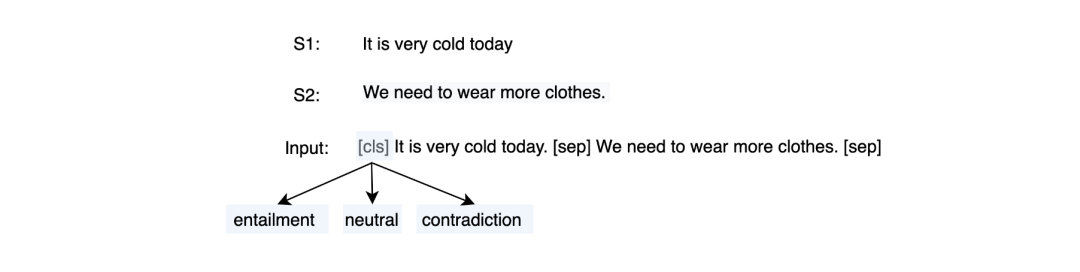

在这一章中我们要介绍一篇很重要的论文。我们知道,GPT的全称是Generative Pretrained Transformer;2018,GPT和BERT的提出把NLP带入了预训练的时代。那么什么是预训练?什么是我们经常说的预训练+微调(Fine-tuning)的范式?

用半监督学习/自监督学习去预训练一个语言模型是RNN时代NLP的一个非常天才的想法。具体论文参考:半监督学习(Semi-supervised Sequence Learning)。下面这段是文章的摘要:

We present two approaches that use unlabeled data to improve sequence learning with recurrent networks. The first approach is to predict what comes next in a sequence, which is a conventional language model in natural language processing. The second approach is to use a sequence autoencoder, which reads the input sequence into a vector and predicts the input sequence again. These two algorithms can be used as a "pretraining" step for a later supervised sequence learning algorithm. In other words, the parameters obtained from the unsupervised step can be used as a starting point for other supervised training models. In our experiments, we find that long short term memory recurrent networks after being pretrainedith the two approaches are more stable and generalize better. With pretraining, we are able to train long short term memory recurrent networks up to a few hundred timesteps, thereby achieving strong performance in many text classification tasks, such as IMDB, DBpedia and 20 Newsgroups.

这篇论文的价值非常高,在那个Transformer模型还没有出现的2015年,RNN统治NLP的年代,它率先给出了基于无标签样本做自监督学习从而预训练一个RNN的范式。我认为它就是RNN时代的BERT和GPT。

8.1 预训练模型(Pre-trained Model,PTM)

Note:预训练不一定是无监督的,但通常情况下预训练是指在大规模数据集上进行无监督的预训练。

8.1.1 迁移学习Transfer Learning

-

迁移学习(Transfer Learning)是一种机器学习技术,通过将在一个领域**(源领域)训练好的模型应用到另一个领域(目标领域)**,从而改善另一个�领域的学习性能,加速在新领域中的学习过程。

-

在传统机器学习中,通常需要在目标领域中收集大量的数据并训练针对目标场景模型,但目标场景的标注数据可能是稀缺的。迁移学习利用了在源领域中学到的知识,通过从一个领域向另一个领域传递知识,可以解决在目标领域数据稀缺、标注困难或者模型难以收敛等问题。

8.1.2 为什么要有预训练?

迁移学习和预训练是密切相关的概念,预训练可以被视为是迁移学习的一种特定形式。

预训练是指在一个大规模的数据集上训练一个神经网络,并将训练好的模型参数作为下游任务的初始参数。

其中,在大规模的数据集上,我们可以让神经网络学到很多共性信息;而后,在这些共性信息的基础上(以之前用共性信息训练出来的模型的参数,对现在的下游任务的模型进行参数初始化),再学习一些小规模的垂直细分的数据,从而让模型能够去胜任一些特定的任务。

下面的文字引自:【NLP预训练】深入理解“预训练”语言模型 By 潘小小

如果想用一句话讲清楚“预训练“做了一件什么事,那我想这句话应该是“使用尽可能多的训练数据,从中提取出尽可能多的共性特征,从而能让模型对特定任务的学习负担变轻。”

如果用一句话来概括“预训练”的思想,那么这�句话可以是:

模型参数不再是随机初始化,而是通过一些任务(如语言模型)进行预训练

将训练任务拆解成共性学习和特性学习两个步骤

8.1.3 预训练模型用于下游任务的策略:固定特征提取器

将预训练好的模型用于下游任务通常有两种策略,一种是固定特征提取器,一种是基于微调。

- 固定特征提取器(Fixed Feature Extractor),即将预训练好的模型的权重冻结,只使用其特征提取器提取下游任务数据的特征,然后将这些特征输入到下游任务的模型中进行训练。总之,冻结原来的参数,只训练一个新的分类层。这种策略适用于下游任务的数据量较少的情况,可以避免过拟合。

在CV里,大家经常把预训练好的CNN作为特征提取器用于各种下游任务场景。第三章里提到,CNN是一种CV里非常常用的模型,通常使用大规模的有标注图像数据集(eg. ImageNet)进行预训练,从而学习到通用的特征表示。

预训练好的CNN模型可以作为一种通用的特征提取器。做法如下:

-

在下游任务中,使用预训练好的CNN模型作为特征提取器,将输入图像经过CNN模型得到高维的特征向量。

-

在特征向量的基础上,训练一个新的分类器、检测器或分割器等,以适应新的任务要求。

-

对于图像分类任务,可以使用全连接层或者SVM等简单的分类器;对于��目标检测任务,可以使用锚框(anchor)和区域提取网络(Region Proposal Network,RPN)等技术;对于图像生成任务,可以使用生成对抗网络(Generative Adversarial Networks,GAN)等模型对特征向量进行生成。

8.1.4 预训练模型用于下游任务的策略:Fine-Tuning

**微调(Fine-tuning)**一种迁移学习方法,指在预训练模型的基础上,对部分或全部的参数进行微小的修改,以适应新的任务。微调一般是在有监督学习的框架下进行的。

微调过程通常包括:

-

预训练模型的参数通常被初始化为预训练时的值

-

使用下游垂直任务的标注数据来对模型进行进一步的训练,并调整模型的超参数和学习率等参数。以适应特定的任务模型。Note:这个过程中,我们会采用一些针对下游任务的目标函数。

-

在训练的过程中,逐步调整参数,以最小化下游任务的损失函数,从而在特定任务上表现更好。

预训练模型的权重在新数据上进行训练微调可以在整个神经网络上完成,也可以只在一部分神经网络层上完成。在这种情况下,我们称未被微调的层**“冻结”(Frozen),**在反向传播步骤中不更新。

微调是一个比较复杂的工程,需要很多工程know-how:

-

过拟合(主要挑战):微调通常涉及到在相对较小的数据集上训练预训练模型,因此很容易发生过拟合,从而在未见过的数据上产生较差的性能。

-

数据集:微调需要大量的标注数据,而这些数据应该具有代表性和多样性,能够充分反映下游任务的特征。

-

超参数调整:微调需要对模型的各种超参数进行调整,例如学习率、batch size、正则化等,以适应下游任务。

-

优化算法:优化算法就是决定在更新参数时如何调整步长、方向等因素,以最小化损失函数的值。随机梯度下降是最常见的优化算法。微调时,模型可以采用与预训练时相同的优化算法,或者根据下游任务的特点选择不同的优化算法。

8.1.5 为什么在NLP中迟迟没有出现类似CV预训练的范式?

Q:2018年前,迁移学习在NLP中的运用情况如何?

我们知道,直到2018年,ULM-FiT、GPT和BERT模型的出现才开启了NLP预训练模型的时代,才真正实现了CV领域那样的迁移学习方法在NLP领域的应用。那么,是不是说2018年前NLP领域就没有迁移学习呢?

答案是,这个说法是非常不准确的!就如我们在6.4.3里预告的,word2vec其实就是NLP中迁移学习运用的祖师爷,它可以利用大规模的未标注文本数据进行训练,从而可以学习到非常通用的单词向量表示。由于word2vec的成功,迁移学习范式已经成为了NLP领域的标配!

Q:那为什么我们会说,NLP一直没有一个类似CV的迁移学习范式?

- 这是因为,虽然word2vec是将迁移学习引��入NLP领域的先驱之一,但是它主要关注的是单词级别的表示学习,而不是针对具体任务的模型迁移。也就是说,在面对一个NLP任务的时候,word2vec可以让我们快速解决从词元到词嵌入的那两层神经网络(对于一个包含V个单词的词典,如果我们用N维稠密向量来表示每一个词,那么word2vec模型其实就是压迫去学习一个V×N的矩阵),但也仅此而已了。很长一段时间内,NLP研究者们依然需要针对每个具体的NLP任务训练不同的模型。

NLP中虽然也有一些预训练模块,比如预训练词向量,然后用到具体的NLP任务中,但也仅仅是将词向量作为下游模型的输入。在NLP中,并没有一个基础模型(包括模型的结构、权重等),能把整个基础模型迁移到下游任务进行微调,现在都是针对不同的问题设计专门的网络结构,比如POS、NER、NMT等,处于不同任务各自为政的局面。——Beeder in CS224N(3.5)Multitask Learning | bitJoy

- 相比之下,在CV中,迁移学习经常是基于模型层级的。在解决一个新的CV任务时,大部分特征提取的工作都可以用以前预训练完的CNN做完,工程师只需要给原来的CNN加一层全连接层,或者做Fine-tuning,就可以了。像CV领域那样如此方便的使用预训练模型来进行迁移学习一直是NLP领域研究人员的一个愿望。

Q:那为什么模型迁移这件事在NLP迟迟没有发生?

CV:图像数据集巨大,而且任务几乎都是以分类为基础

-

在计算机视觉领域中,图像数据集非常大且丰富,例如ImageNet数据集就包含了数百万张图像。很多模型都会在ImageNet上预训练,然后迁移到具体的任务中进行微调。

-

这种方式能够成功的原因是很多CV任务几乎都是以分类为基础任务,分类相当于CV的积木(building block),所以在ImageNet上训练的CNN分类模型迁移到其他CV任务中能起到很好的提升效果

NLP:预处理文本数据成本非常高,而且任务种类繁多

-

文本数据通常需要进行分词、词性标注、命名实体识别等预处理步骤,这成本实在是太高了,所以自然语言数据集往往都比较小。

-

语言本身的复杂性增加了预训练模型的训练难度。在6.2中我们提到了很多NLP的基本任务,在6.3.3中我们提出了对语言模型的诸多期待,这些都足以体现语言有多复杂,它不像CV一样几乎都以识别+分类为目的。

-

因此,在NLP领域中,早期的研究主要集中在手工设计特征和模型架构上,例如基于词袋模型和n-gram模型的文本分类方法,以及基于递归神经网络和长短时记忆网络的序列建模方法。由于没有一个普适的、可以即插即用的预训练模型,NLP的学者们花了很多时间重复造轮子,相较于CV,研究一直处在一个很初级的阶段。

8.2 论文模型结构:序列自编码器和语言模型

在我们要介绍的这篇论文中,作者设计了两个方法来预训练一个LSTM网络。

We present two approaches that use unlabeled data to improve sequence learning with recurrent networks. The first approach is to predict what comes next in a sequence, which is a conventional language model in natural language processing. The second approach is to use a sequence autoencoder, which reads the input sequence into a vector and predicts the input sequence again.

如果用语言模型的预训练参数来初始化LSTM,那么它就叫LM-LSTM;如果用序列自编码器的预训练参数来初始化LSTM,那么它就叫SA-LSTM。

8.2.1 语言模型 LM-LSTM

语言模型非常好理解,无非是基于一个已有的词序列,做下一个词的预测。

希望大家在这里不要混淆一个概念,即语言模型。语言模型不只是一个最终的模型(Like GPT-3),语言模型它就是预训练任务本身!语言模型即“预测下一词”,它本身就是一个很重要的预训练任务。

-

一个标准的LSTM语言模型由三个部分组成:输入层、LSTM层和输出层。输入层接收输入序列,将其转换为嵌入向量。LSTM层是一个标准的LSTM单元,它接收输入向量序列,生成相应的隐藏状态序列。输出层将LSTM层的隐藏状态作为输入,并生成每个时刻的下一词预测。

-

与标准的LSTM模型不同的是,LM-LSTM还包括一个语言模型的部分,用于在无监督的方式下预测文本序列。因为是自监督学习,一开始就有一个完整的词序列,所以LM-LSTM使用双向了LSTM来生成每个时刻的上下文向量,然后使用这些向量作为输入来预测当前时刻的单词。这个语言模型可以被用于在半监督学习中,利用未标注的文本数据来预训练LM-LSTM模型。

8.2.2 序列自编码器 Sequence Autoencoder

8.2.2.1 序列自编码受到了seq2seq的启发

序列自动编码方法受到seq2seq工作的启发。<前文提到了seq2seq在NMT的运用。事实上,seq2seq是一个很强大的方法,还可以用于文本解析、图像字幕、视频分析、语音识别和对话建模等等。>

seq2seq方法的关键是使用递归网络作为编码器,将输入序列读入隐状态,作为预测输出序列的解码器递归网络的输入。在中译英的神经机器翻译中,编码器编码中文,解码器试图重构原序列为英文。那么可不可以这样:不让解码器去生成一个新的东西,而是试图利用编码器编码的向量,去重构原来的序列自身呢?

序列自动编码器就是这样子的思路。相较于传统的seq2seq,序列自编码器是一个无监督的学习模型,其目的是重建输入序列本身(这样就可以在不需要任何额外标注的情况下计算出损失函数,进行梯度下降)。在序列自动编码器中,解码器网络和编码器网络的权重参数是共享(相同)的。

8.2.2.2 序列自编码器的无监督特性

序列自动编码器的一个重要特性是它是无监督的,因此可以用大量的未标记的数据来训练以提高其质量。论文的结果是,额外的无标签数据可以提高递归网络的概括能力。

序列自编码器产生了怎么样的效果呢?参考下文:

We find that the weights obtained from the sequence autoencoder can be used as an initialization of another supervised network, one which tries to classify the sequence. We hypothesize that this is because the network can already memorize the input sequence.

也就是说,通过无监督学习训练的序列自动编码器得到的权重,可以作为另一个基于有监督学习的序列分类网络的初始化参数,这可能是因为序列自编码器的RNN网络记住了喂给它的序列们。

8.2.3 半监督预训练:利用有标注和无标注数据联合训练

-

半监督(Semi-supervised)预训练,指同时利用有标注数据和无标注数据来进行预训练。半监督预训练的目标是利用有标注数据来辅助无标注数据的学习,从而提高模型的性能。

-

以LM-LSTM为例,LM-LSTM模型可以同时处理带标签和不带标签的数据,通过联合训练来提高模型性能。如果我们要训练一个用于序列标注的LSTM,那么LM-LSTM模型可以使用带标签的数据来训练序列标注任务,并使用未标注的数据来训练语言模型部分。通过联合训练,LM-LSTM模型可以从未标注的数据中学习到更多的特征表示,从而提高序列标注任务的性能。

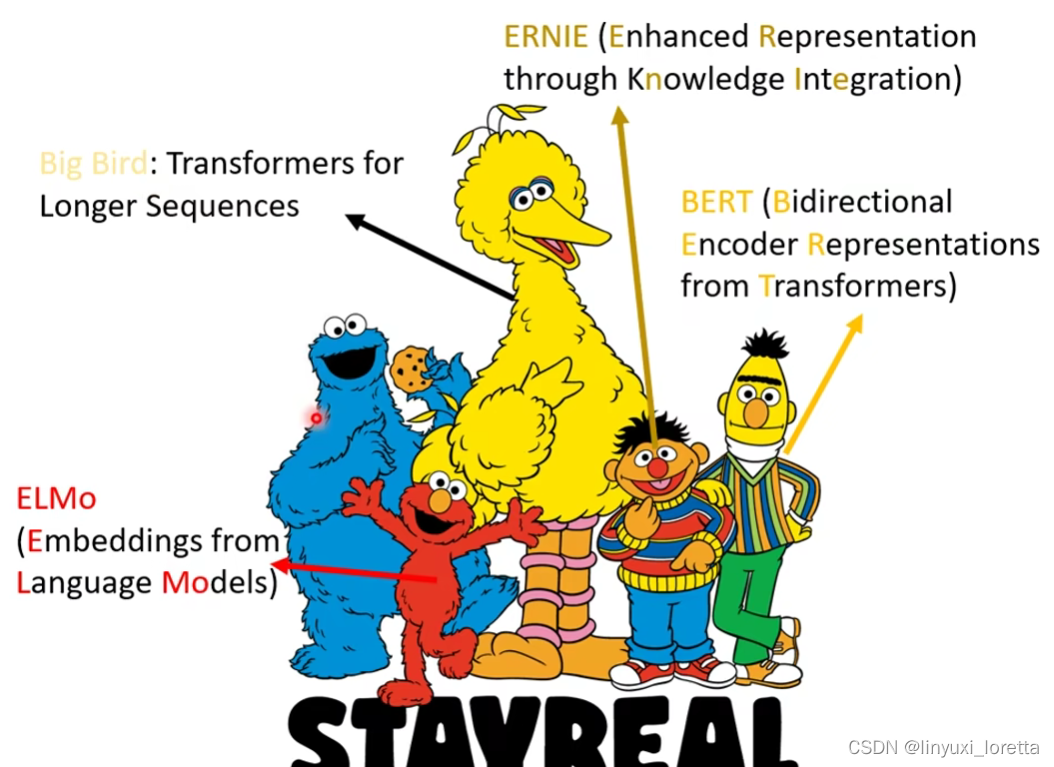

9. 图解 ELMo:Embedding的新纪元(2018.2)

图中这位就是大名鼎鼎的ELMo啦!ELMo的诞生:【arxiv】Deep contextualized word representations。

9.1 ELMo模型的意义

第二代预训练模型以context-aware为核心特征,也就是说“苹果”这个词在分别表示水果和公司时,对应output是不一样的,其中具有代表性的有ELMo, GPT, BERT等。

ELMo is short for Embeddings from Language Model。这个名字看起来真的很像是在硬凑,还是论文的标题Deep contextualized word representations更可以体现它的真正意义。

大量参考了CSDN用户@Anna翻译的这篇文章:图解BERT、ELMo(NLP中的迁移学习)| The Illustrated BERT, ELMo, and co._nlp 迁移学习_Ann's Blog的博客-CSDN博客

9.1.1 word2vec的局限性

前文提到了word2vec模型是一种可以用于各种任务的单词级别的表示学习。类似的还有GloVe。

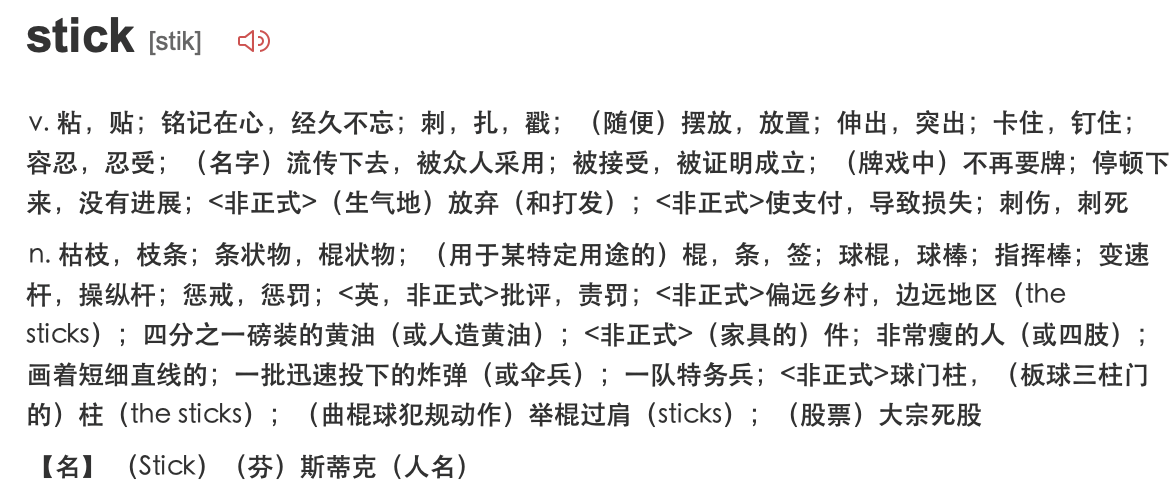

以单词stick为例子,它有非常非常多个意思:

如果我们使用word2vec、GloVe的那些词嵌入,那么不管stick的上下文是什么,单词stick都将由同一个向量表示。也就是说,我们对一个词只有一个词嵌入,哪怕这个词其实有超级多的意思。

这其实还挺蠢的。所以就有很多学者站出来说:“stick有多种意思,而它的意思则取决于他的上下文。“Let's stick to”和“he pick up a stick so that”中的stick显然是两个意思,却用了同一个词向量。为什么我们不根据上下文语境进行embedding呢?这样既能捕捉该语境中的含义,又捕捉其他语境信息。”

9.1.2 语境化词嵌入

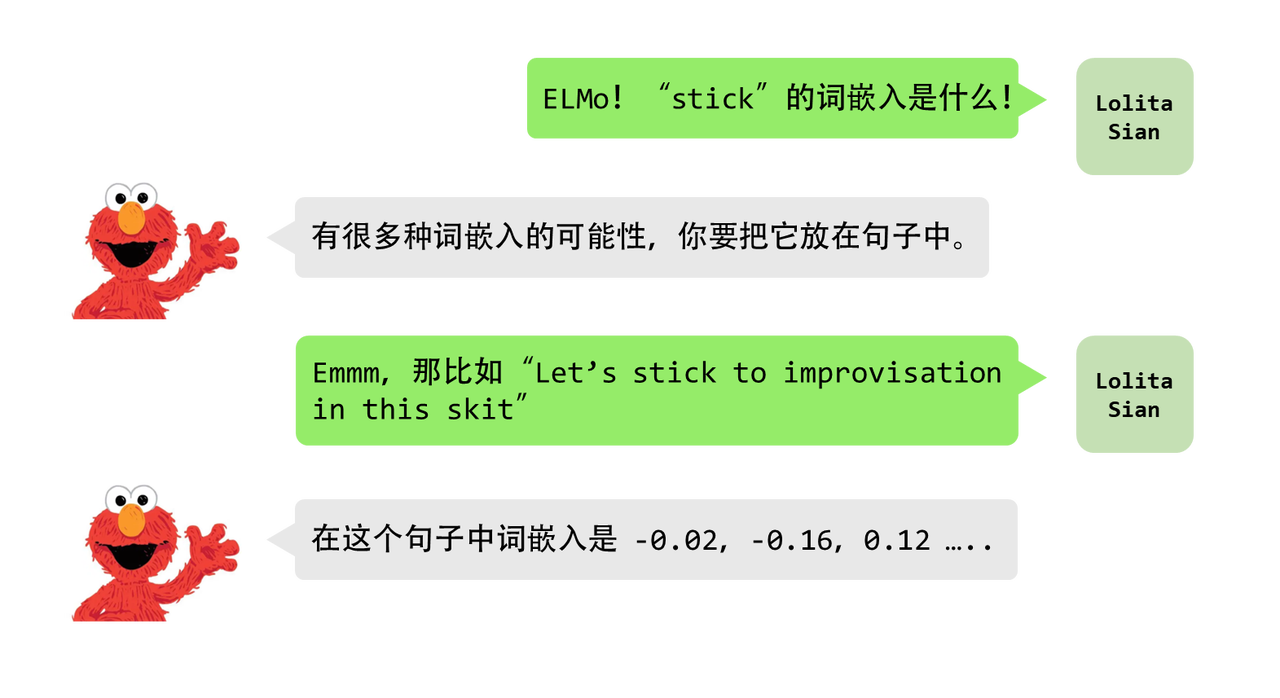

语境化词嵌入可以根据词语在句子语境中的含义赋予词语不同的embedding。

在问ELMo,stick的词嵌入是什么的时候,ELMo是不会像word2vec一样给我们一个肯定的答案的,因为ELMo没有对每个单词使用固定的词嵌入,而是在为每个单词计算embedding之前考虑整个句子。

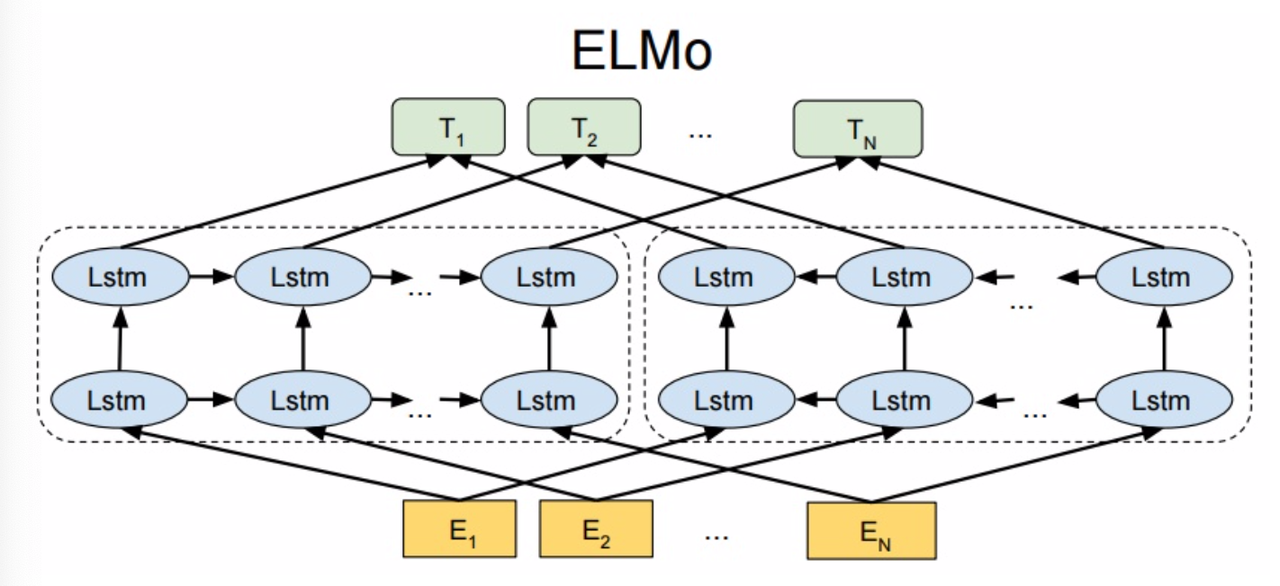

ELMo模型使用的是特定任务上训练好的双向LSTM(bi-LSTM)进行词嵌入。

9.2 ELMo模型的结构

参考资料:一个介绍ELMo论文的PPT

【自然语言处理】ELMo, GPT等经典模型的介绍与对比 By CSDN用户 张小猪的家

从上面的架构图中可以看到, 宏观上ELMo分三个主要模块:

最底层黄色标记的Embedding模块.

中间层蓝色标记的两部分双层LSTM模块.

最上层绿色标记的词向量表征模块.

9.2.1 字符嵌入层(Character Embeddings Layer)

ELMo模型使用字符嵌入来表示每个词语,这是通过卷积神经网络来实现的。

ELMo模型中的CNN主要用于从输入文本中提取字符级别的特征,这些特征可以捕捉到单词中的前缀和后缀信息,从而提高词向量的表达能力。具体来说,ELMo使用了一个具有多个卷积核的卷积层,每个卷积核对应一个不同的字符级别窗口大小,通过对输入文本进行卷积操作,可以提取出每个字符级别窗口中的特征。这些特征经过池化和拼接操作后,可以形成一个与输入文本相同长度的字符级别特征向量,作为LSTM网络的输入之一。

CNN在NLP中的应用可以见:CS224N(2.12)Convolutional Networks for NLP | bitJoy By Beeder。

9.2.2 双向LSTM层(Bidirectional LSTM Layer)

ELMo模型使用双向LSTM(Bi-LTSM)来捕捉词语在上下文中的语义信息。Bi-LSTM分别从左向右和从右向左对输入序列进行扫描,可以同时考虑到前向和后向的上下文信息,从而生成上下文相关的词向量。

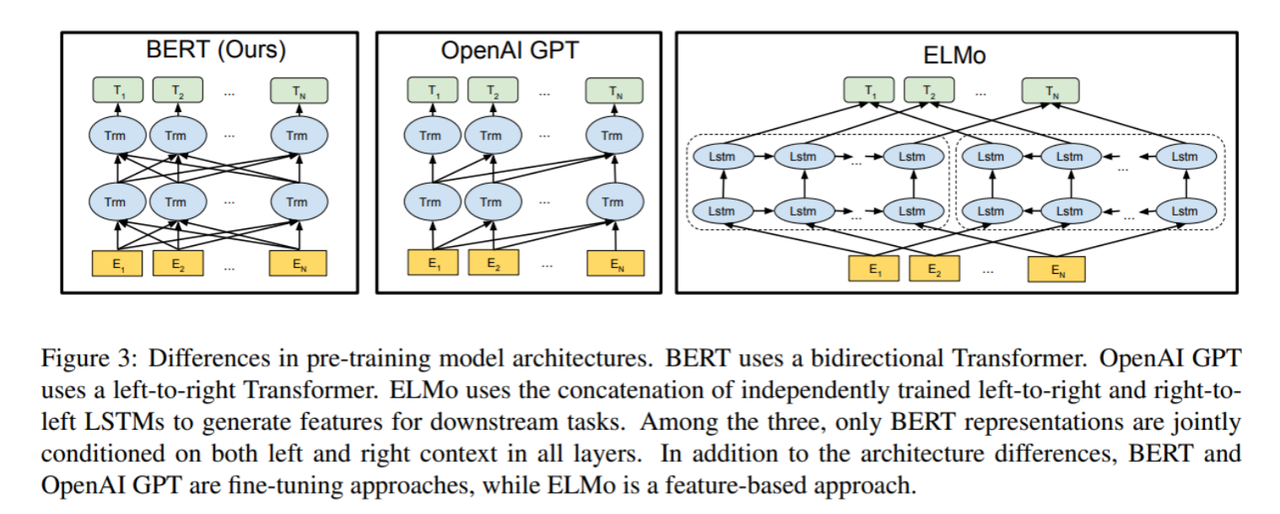

<注意,后面我们会提到的BERT也会是称为Bidirectional,但我们会发现这两者并不一样。>

在ELMo模型中,Bi-LSTM层由两个独立的LSTM单元组成,分别从前向和后向两个方向对输入文本进行建模,形成了两个独立的隐藏状态序列。

ELMo的这一模块分为左右两部分, 本质上就是一个双向LM:

对于左半部分, 给定了N个tokens, Language Model通过前面k-1个位置的token序列来计算第k个token出现的概率, 构成前向双层LSTM模型.

同理, 对于架构中的右半部分, 给定了N个tokens, Language Model通过后面N-k个位置的token序列来计算第k个token出现的概率, 构成后向双层LSTM模型.

而后,将前向和后向LSTM单元的隐藏状态序列进行合并,形成了一个包含了双向上下文信息的隐藏状态序列。

9.2.3 上下文相关词向量层(Contextualized Word Embeddings Layer)

ELMo模型通过将字符嵌入和双向LSTM层的输出进行拼接,并通过一个线性变换得到最终的上下文相关词向量。这些词向量可以根据输入句子的不同上下文进行调整,从而捕捉到不同上下文中词语的语义信息。

9.2.4 输出层(Output Layer)

ELMo模型可以通过在上下文相关词向量上添加任务特定的输出层,如全连接层、Softmax层等,来进行具体的NLP任务,如文本分类、命名实体识别等。

因为ELMo给下游提供的是每个单词的特征形式, 所以这一类预训练方法被称为"Feature-based Pre-Training".

9.3 总结ELMo

ELMo的本质思想就是根据当前上下文对word embedding进行动态调整的语言模型。它总体上采用了双向双层LSTM的结构,而且用了一个两阶段过程来做预训练:

第一阶段: 利用语言模型进行预训练, 得到基础静态词向量和双向双层LSTM网络.

第二阶段: 在拥有上下文的环境中, 将上下文输入双向双层LSTM中, 得到动态调整后的word embedding, 等于将单词融合进了上下文的语义, 可以更准确的表达单词的真实含义。

ELMo在传统静态word embedding方法(Word2Vec, GloVe)的基础上提升了很多, 但是依然存在缺陷, 有很大的改进余地。主要有以下两点:

第一点: 一个很明显的缺点在于特征提取器的选择上, ELMo使用了双向双层LSTM, 而不是现在横扫千军的Transformer, 在特征提取能力上肯定是要弱一些的. 设想如果ELMo的提升提取器选用Transformer, 那么后来的BERT的反响将远不如当时那么火爆了.

第二点: ELMo选用双向拼接的方式进行特征融合, 这种方法肯定不如BERT一体化的双向提取特征好.

By CSDN用户 张小猪的家

10. Attention is All You Need!大语言模型的基石Transformer(2017)

多年以后,面对AGI时,NLP从业者们会想起Google带他们去看变形金刚的那个遥远的下午。

你说的对,但「Transformer」是谷歌自主研发的一款全新开放世界冒险游戏,中间忘了,总之就是被AGI选中的人要导引多头注意力之力,逐步发掘「大力出奇迹」的真相。

说来,为什么发布Transformer的文章名字叫Attention Is All You Need 呢?这是因为,在seq2seq把Attention机制发扬光大后,NLP领域的模型的主流架构是递归神经网络(一般是LSTM)+注意力机制,后者起到一个辅助作用。然而,LSTM再怎么样都不过是一个变种RNN,难以并行训练、发挥GPU的优势这件事让他们训练效率很慢,自然不存在大力出奇迹造出一个超级大的语言模型的可能性。

Transformer模型非常非常的激进,他直接抛弃了作为模型主体的RNN,只保留了注意力机制。这就是这个标题的由来。不得不说搞NLP的研究者们还是很笨蛋的,Attention is All You Need这篇文章牛逼了之后,大家纷纷蹭热度发文XX is All You Need,发表的论文只要采取了这个格式的标题,就很容易上热榜🤯。拒绝蹭热度从我做起!

你就是那个解决了RNN串行训练的效率问题,在深度学习领域横扫千军的Transformer?(Google团队好像本来是想取变压器的意向。但是大家看到这词儿想到的都是变形金刚……)

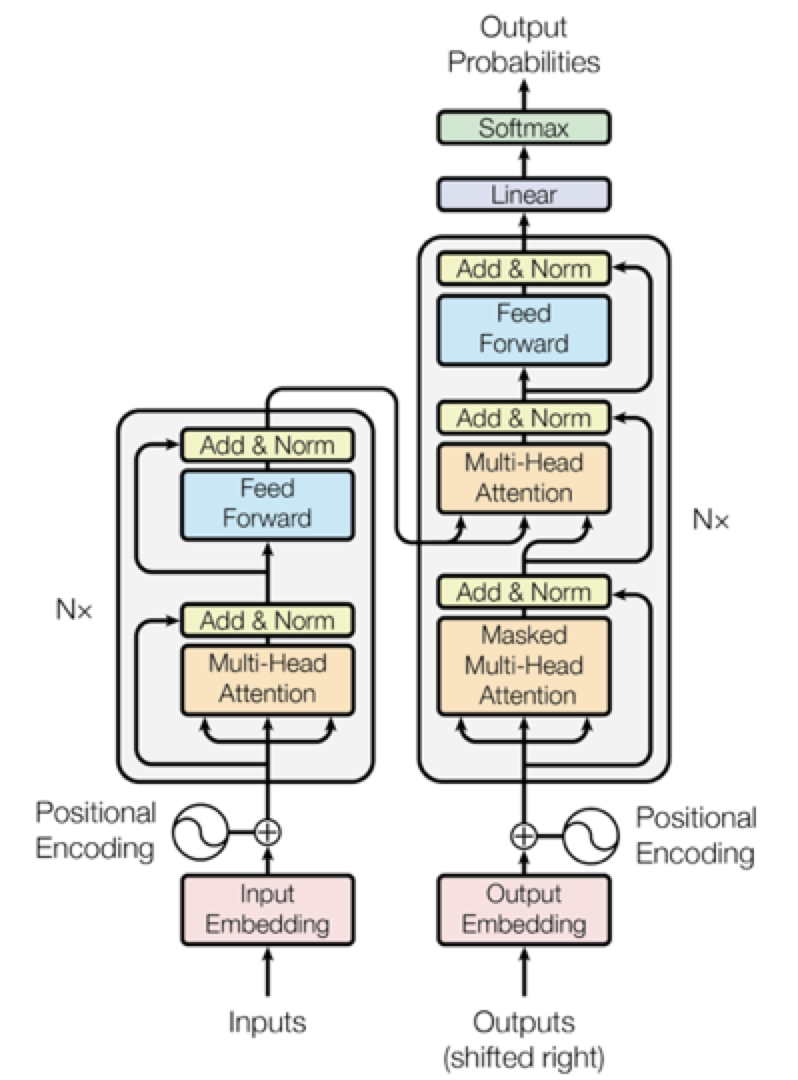

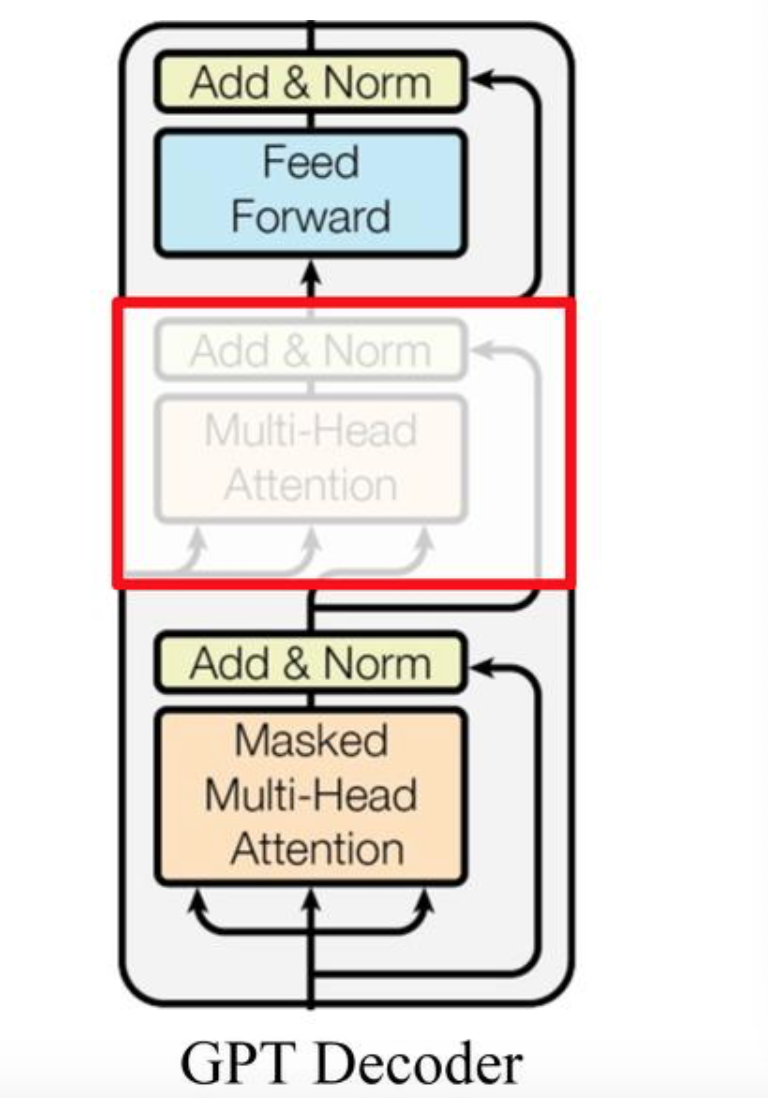

不好意思,打扰了,是这张!模型架构乍一看有点难懂,但是没关系,我们后面会把它给讲清楚的!

10.1 Transformer的整体结构

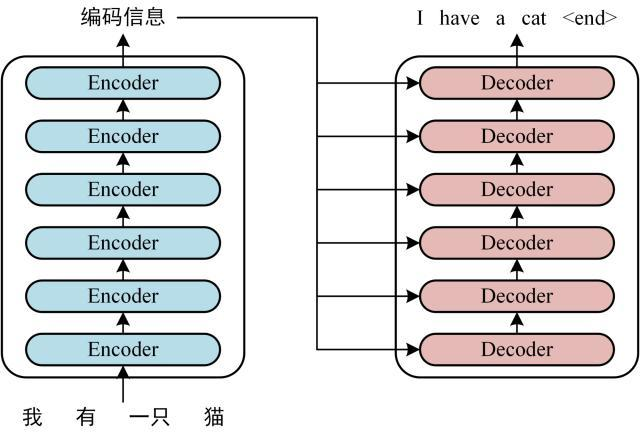

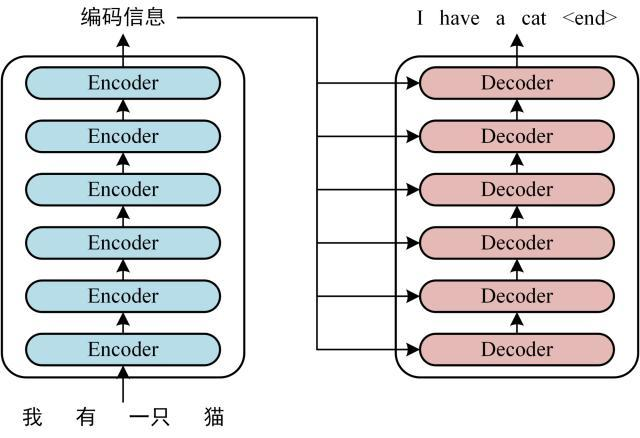

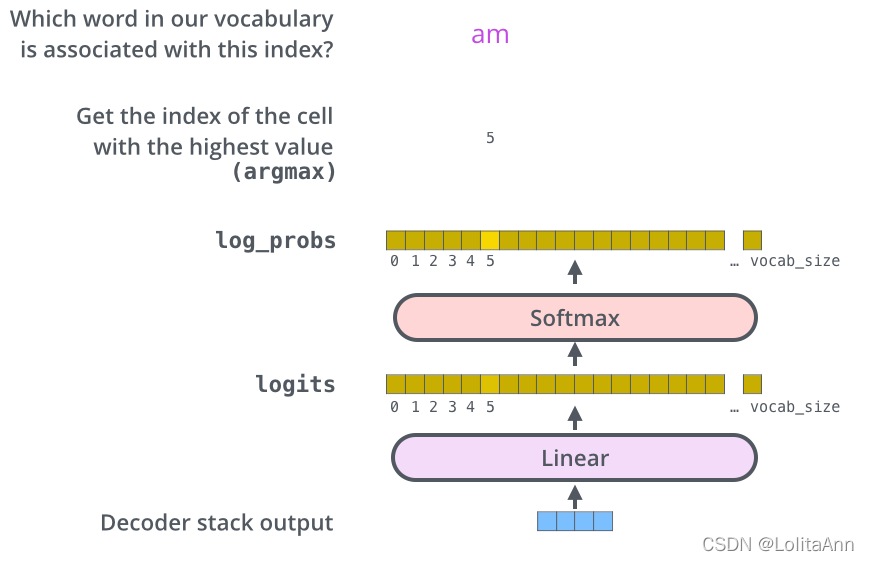

上面那张图展示的就是Transformer的整体结构了,但乍一看会太过复杂。让我们先看下面这张图:

图源【知乎】Transformer模型详解(图解最完整版),By 知乎用户初识CV

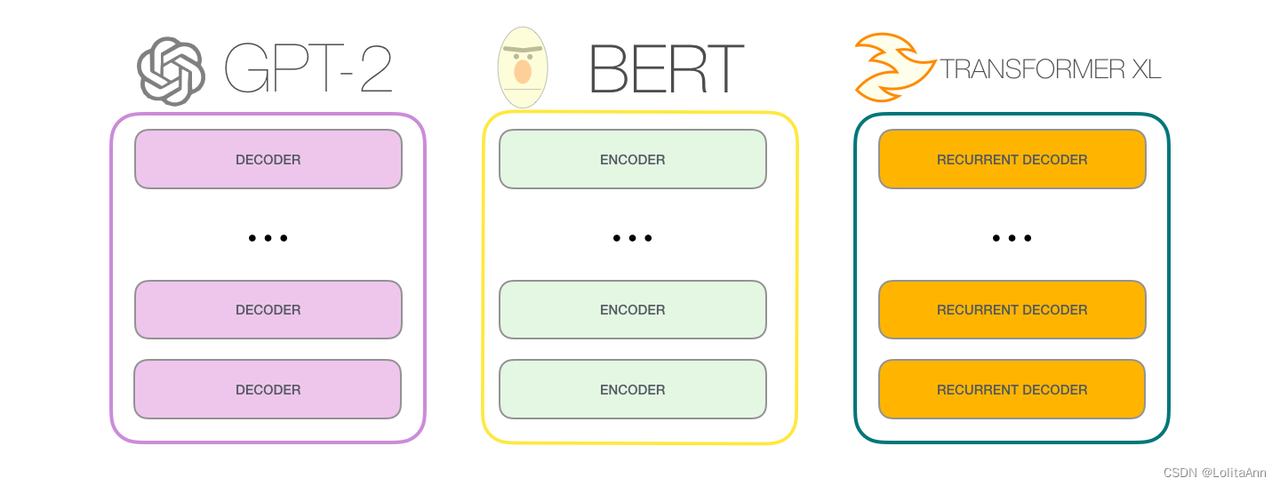

在万恶之源Attention Is All You Need 之中,原版的Transformer有六个编码器和六个解码器,是一个比较深的网络结构。可以看到,最开始的时候,Transformer主要用于神经翻译任务,所以这里先用神经翻译任务举例子。后面我们会看到对Transformer的一些魔改(Encoder-Only or Decoder-Only),从而将其用于文本生成(GPT)或者各种其他下游任务( BERT)。

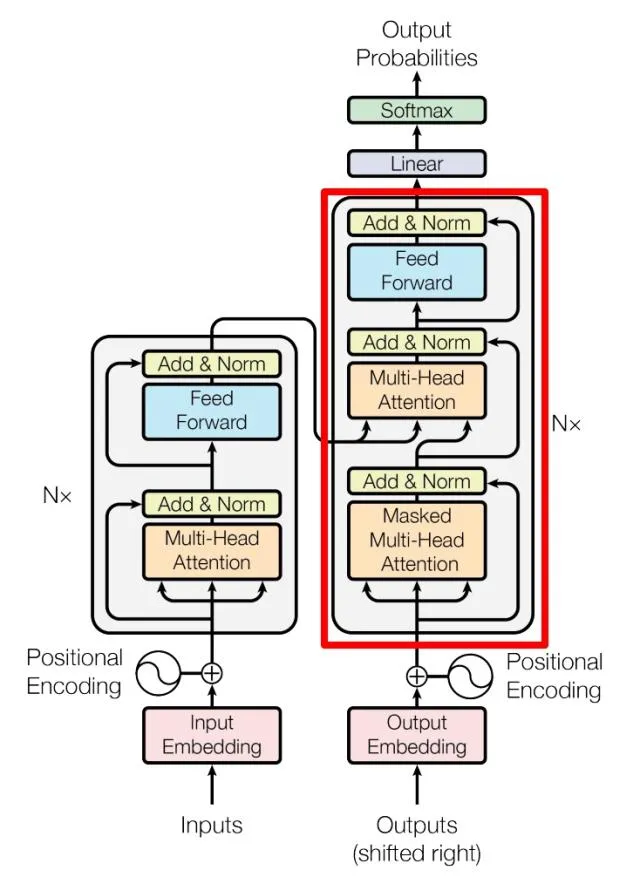

10.1.1 编码器结构:Self-Attention层 + 前馈神经网络层

从这里开始,我们引用的图基本都来自图解transformer | The Illustrated Transformer By Ann's Blog。

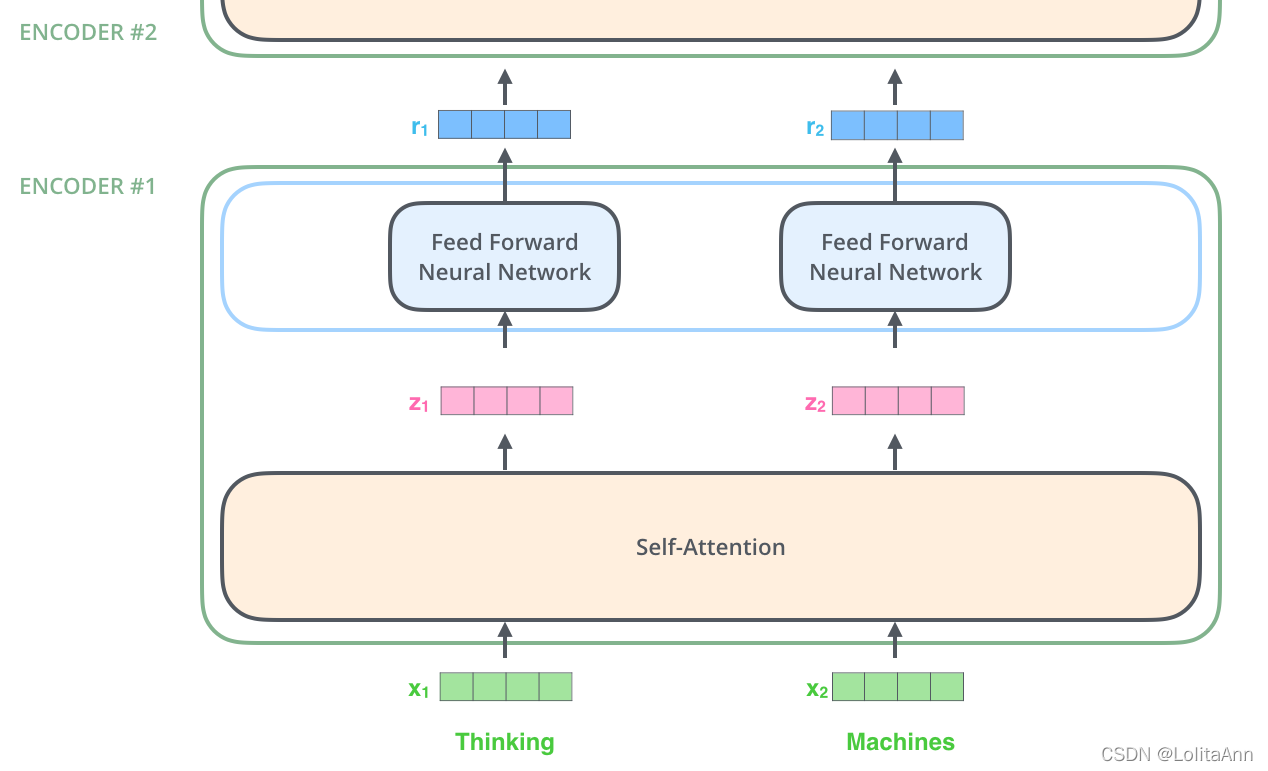

6个编码器组件的结构是相同的,但是他们之间的权重是不共享的,每个编码器都可以分为2个子层。

编码器的输入()首先会进入一个自注意力层,这个注意力层的作用是:当要编码某个特定的词汇的时候,它会帮助编码器关注句子中的其他词汇。之后会进行详细讲解。

自注意力层的输出()会传递给一个前馈神经网络,每个编码器组件都是在相同的位置使用**结构相同(每个Encoder中的FFNN结构相同但参数不同)**前馈神经网络。

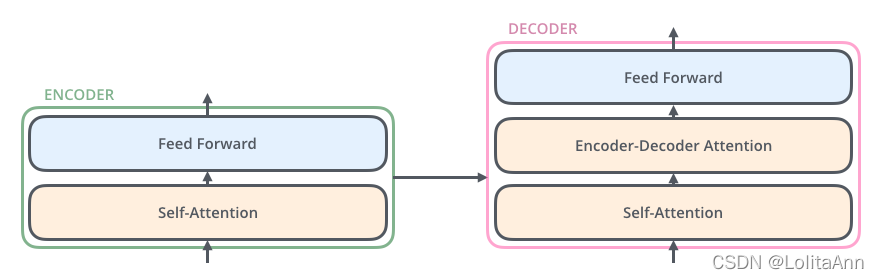

10.1.2 解码器结构:带掩码的Self-Attention层 + Self-Attention 层+一个前馈神经网络

解码器组件也含有前面编码器中提到的两个层,区别在于这两个层之间还夹了一个注意力层,多出来的这个自注意力层的连接了编码器输出的隐状态,起到了和seq2seq中的attention一样的作用(如果忘了也不一定要回去复习,后面会图解的非常清楚滴)。

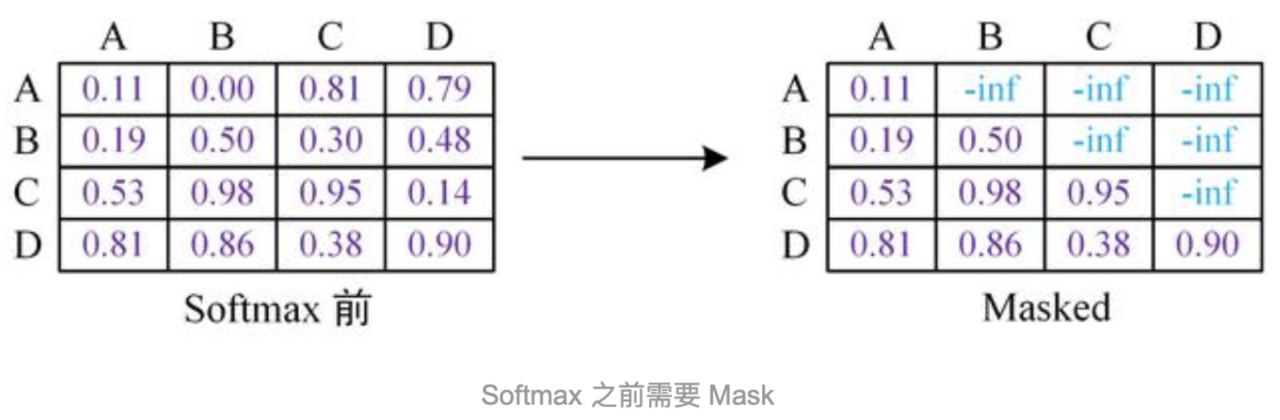

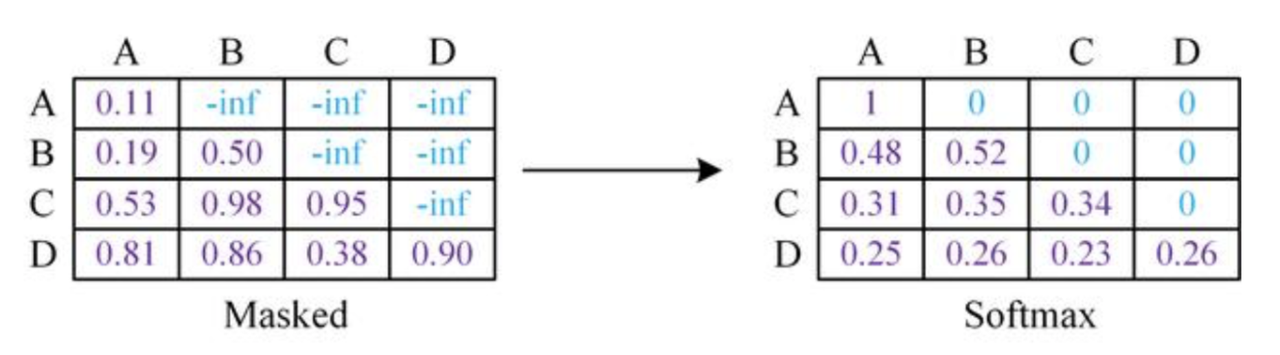

在解码器中,第一个Self-Attention和编码器的第一个自注意力层也是不同的。它是一个带掩码的自注意力层,带掩码的意思就是,对于一个总共有N个单词的词序列,在翻译到第K个单词时候,这个自注意力层只能注意到第1到第K个单词,而注意不到第K+1到第N个单词。后面我们会用一张图很清晰的展示什么是带掩码。

10.2 编码器介绍

10.2.1 Input Embedding: 怎么给Token进行编码?

10.2.1.1 Word Embedding

与其他的NLP项目一样,我们首先需要把输入的每个单词通过词嵌入(embedding)转化为对应的向量。

在Attention is All You Need原文中,他们采用了512维的词嵌入,这里为了方便展示,我们用4个格子来代表512维的词向量们。

10.2.1.2 Positional Encoding,PE

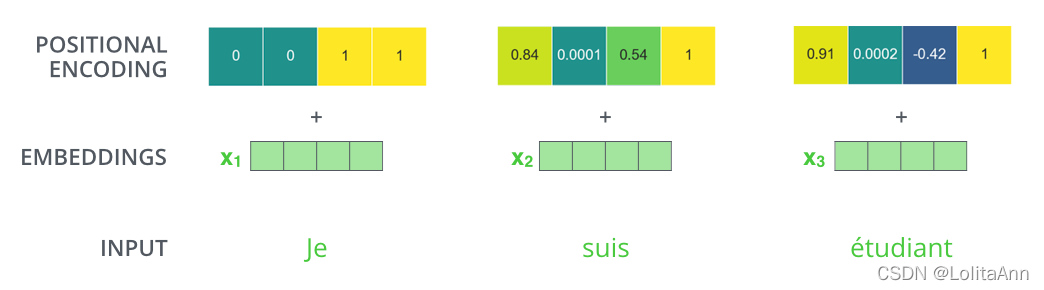

Transformer中的编码器不只采用了词嵌入本身的Embedding,还为每个词基于位置额外增加了一个Embedding(Positional Encoding),它的维度和词嵌入是一样的。最终输入给Transformer的是两个嵌入向量的和。

这是因为Transformer激进地放弃了自带时序处理能力的RNN,而Attention本身又是不会有时序信息的(用自注意力实现全局,不等于拥有时序信息!全局不等于时序)。

Transformer 不采用 RNN 的结构,使用全局信息,不能利用单词的顺序信息,而顺序信息对于 NLP 来说又非常重要。所以 Transformer 中使用位置 Embedding 保存单词在序列中的相对或绝对位置。

通过Positional Encoding,模型可以确定每个单词的位置或不同单词之间的距离。

位置编码需要做到:每个位置对应的编码唯一;不论句子有多长,每两个相邻位置之间的距离都一样;所有的编码都要在一个有限的区间内,编码用到的数字不能爆炸上升(这其实真的很难做到!)。

具体的,Transformer里的位置编码是这样做的:

它是一个和词嵌入同维的、sin和cos交替的向量。

更详细的解释可参考:Transforme 结构:位置编码详解 By Anna's Blog。不过我觉得不是搞学术的人就没必要特地去学这个了。

10.2.2 Self-Attention层:细说自注意力机制

7.3.3里,我们提到过注意力机制的作用。这里我们再提一次。

Say the following sentence is an input sentence we want to translate:

”

The animal didn't cross the street because it was too tired”What does “it” in this sentence refer to? Is it referring to the street or to the animal? It’s a simple question to a human, but not as simple to an algorithm.

When the model is processing the word “it”, self-attention allows it to associate “it” with “animal”.

As the model processes each word (each position in the input sequence), self attention allows it to look at other positions in the input sequence for clues that can help lead to a better encoding for this word.

If you’re familiar with RNNs, think of how maintaining a hidden state allows an RNN to incorporate its representation of previous words/vectors it has processed with the current one it’s processing. Self-attention is the method the Transformer uses to bake the “understanding” of other relevant words into the one we’re currently processing.

为了与Jammar的科普文The Illustrated Transformer保持同步,我们用原文举例子的短句(Thinking Machine)作为例子,看看在编码器的每个子层中发生了什么。

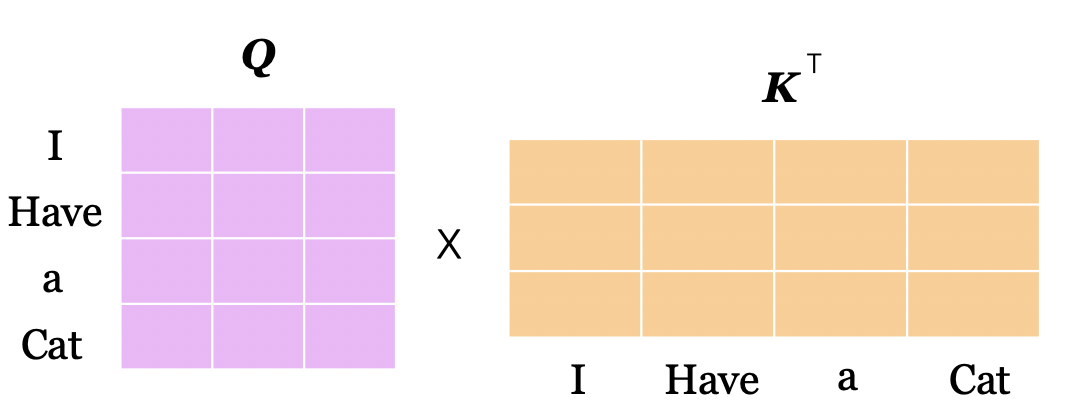

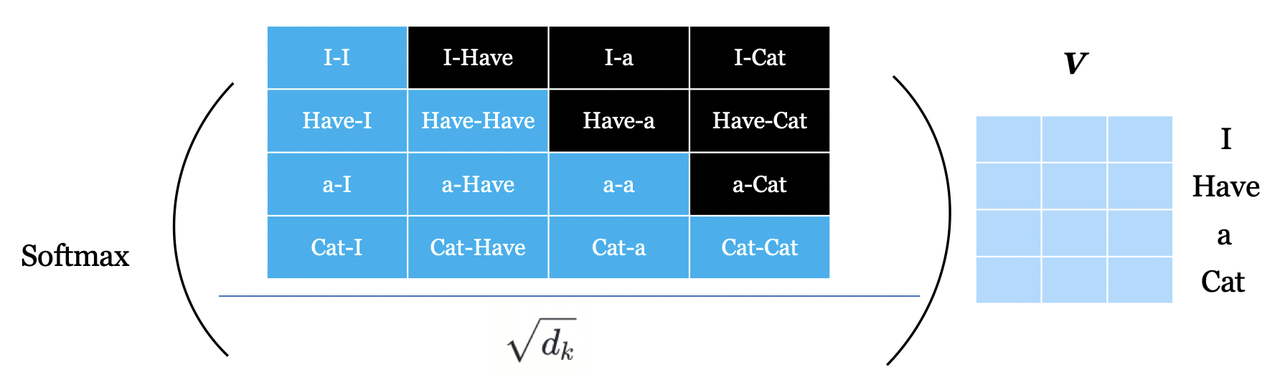

10.2.2.1 对Encoder的每个输入矩阵都计算三个矩阵:Query, Key,Value

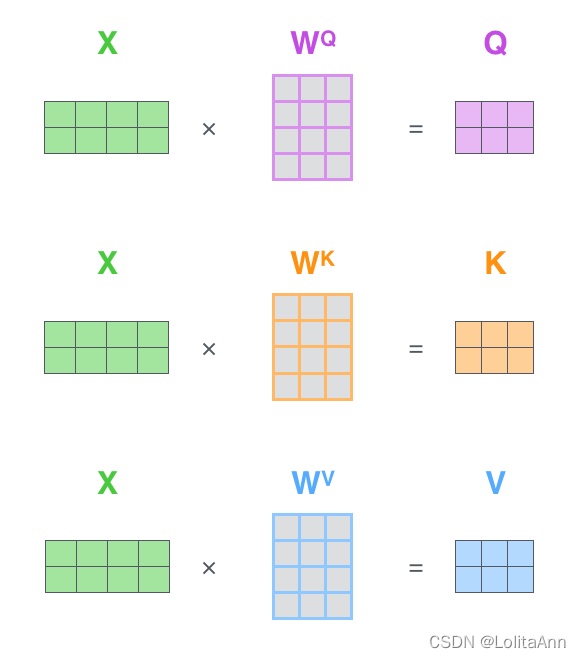

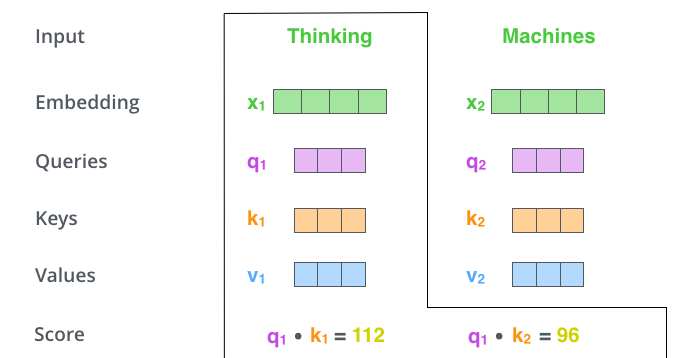

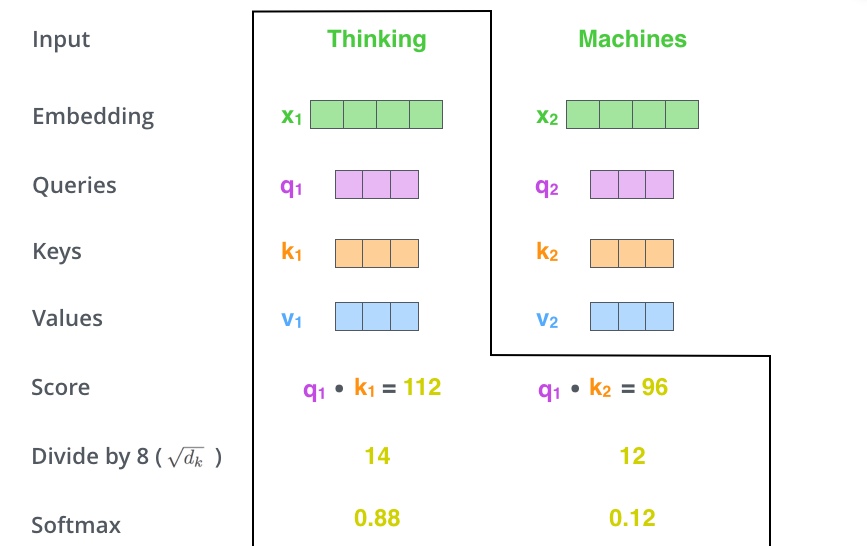

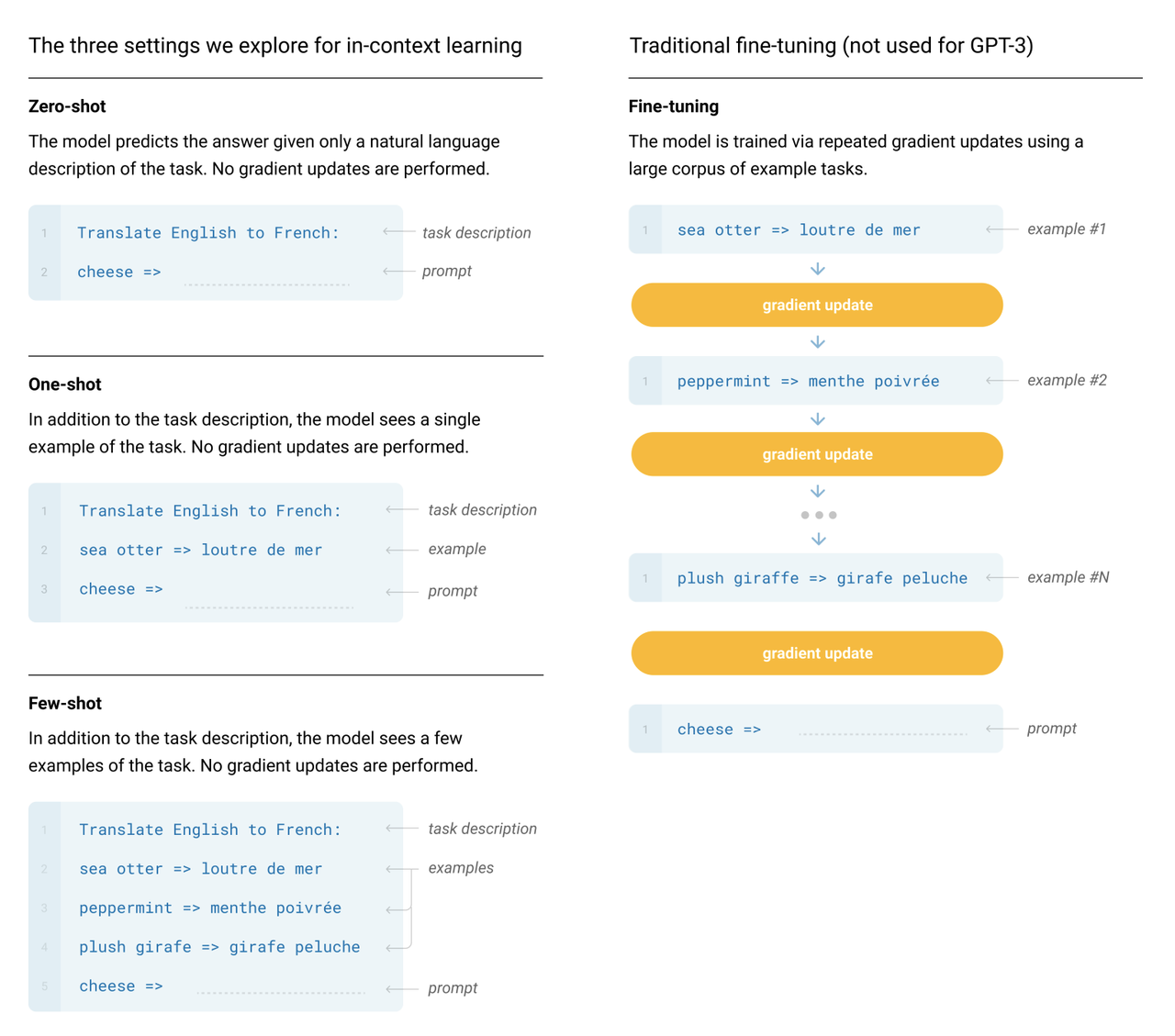

7.4.3中,我们介绍了注意力机制的点积操作本质上其实是两个矩阵的运算(而矩阵运算是高度并行的,在GPU上训练起来非常的快)。不过我们可以暂时忘掉矩阵的事情,先从向量层级去关注都发生了些什么。

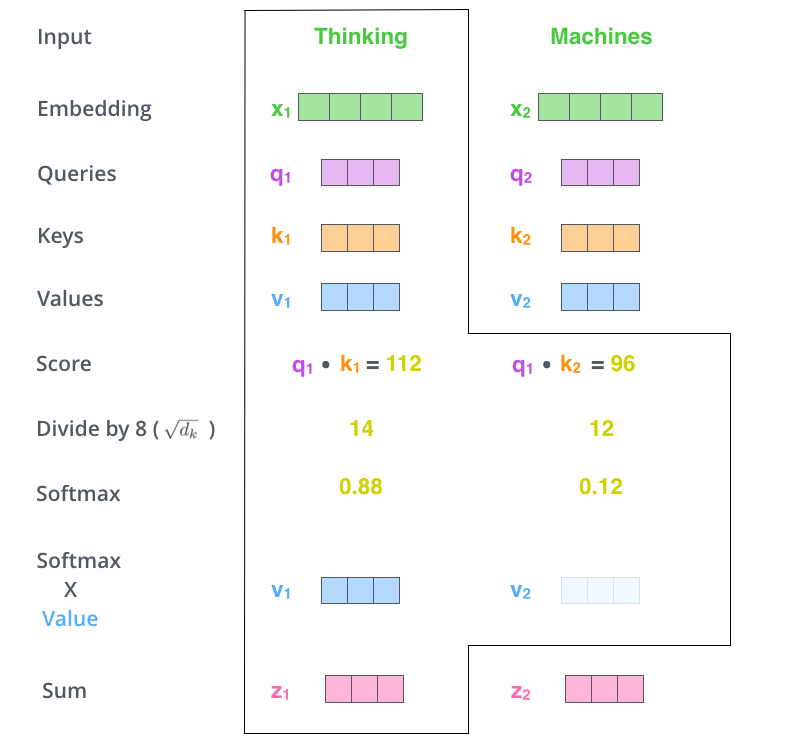

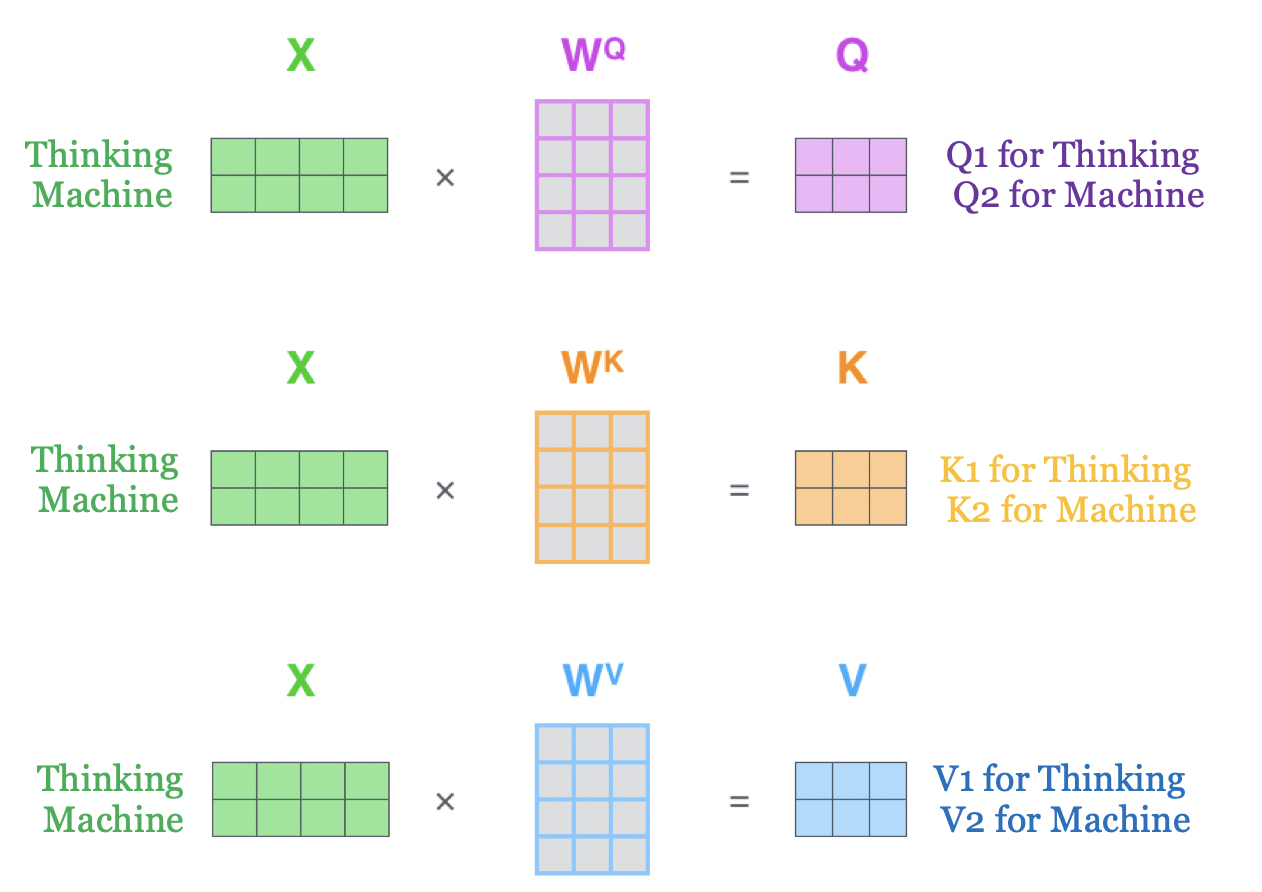

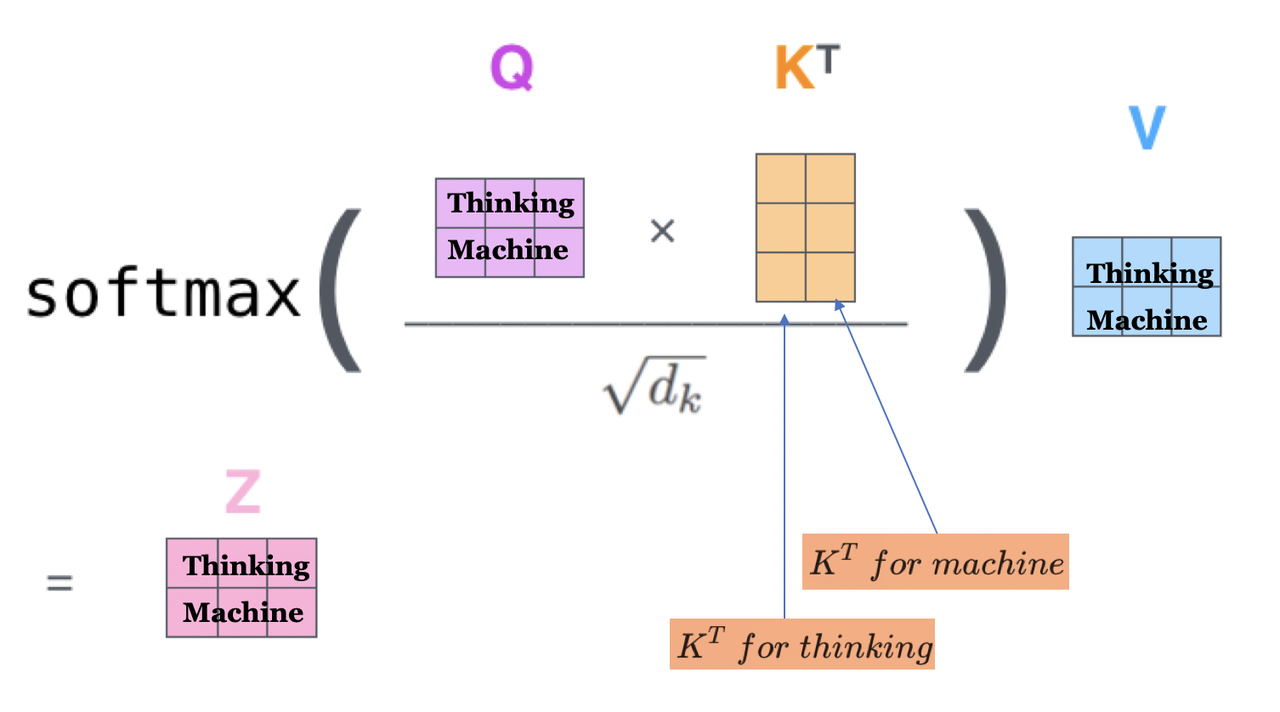

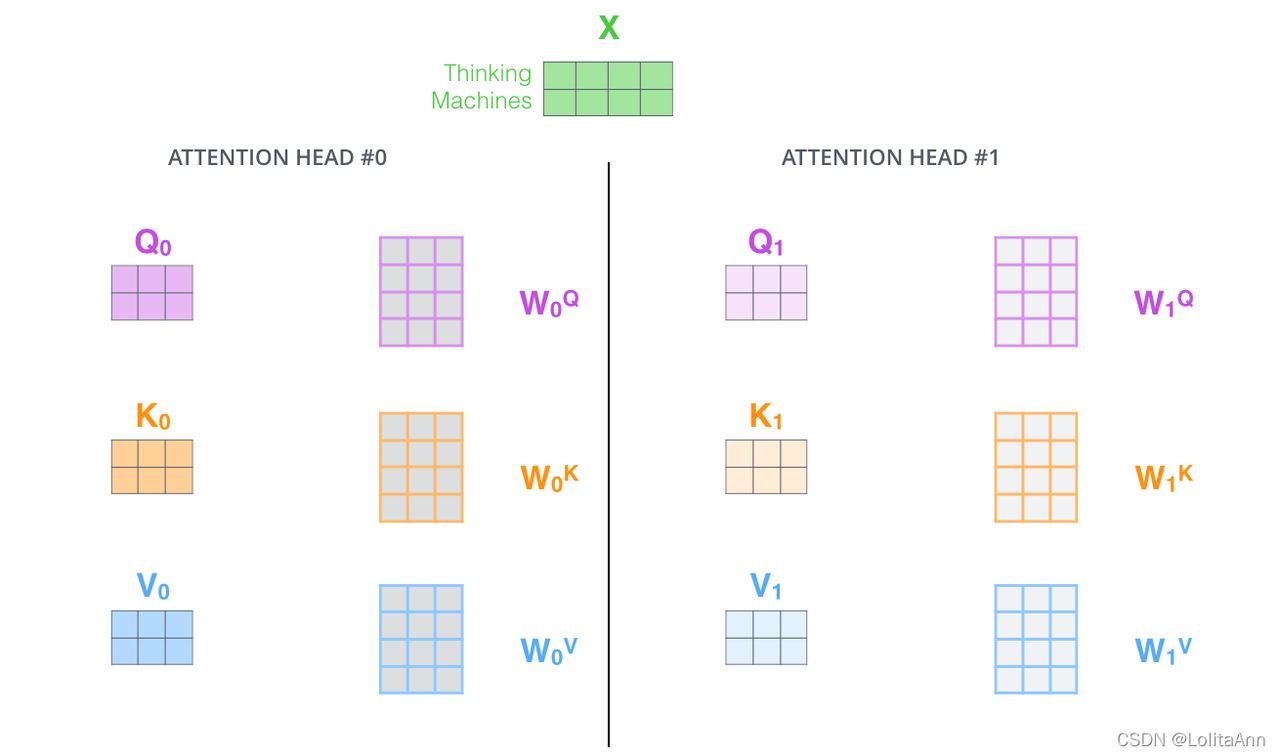

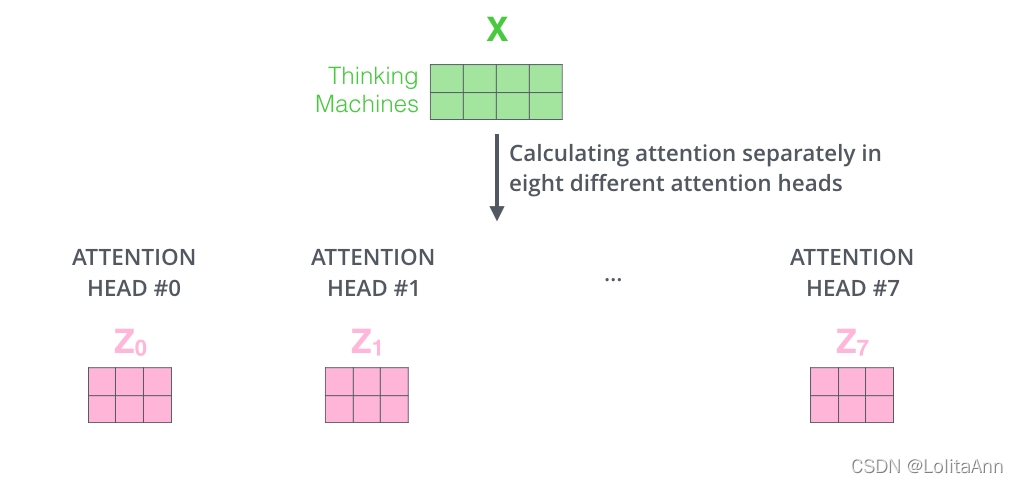

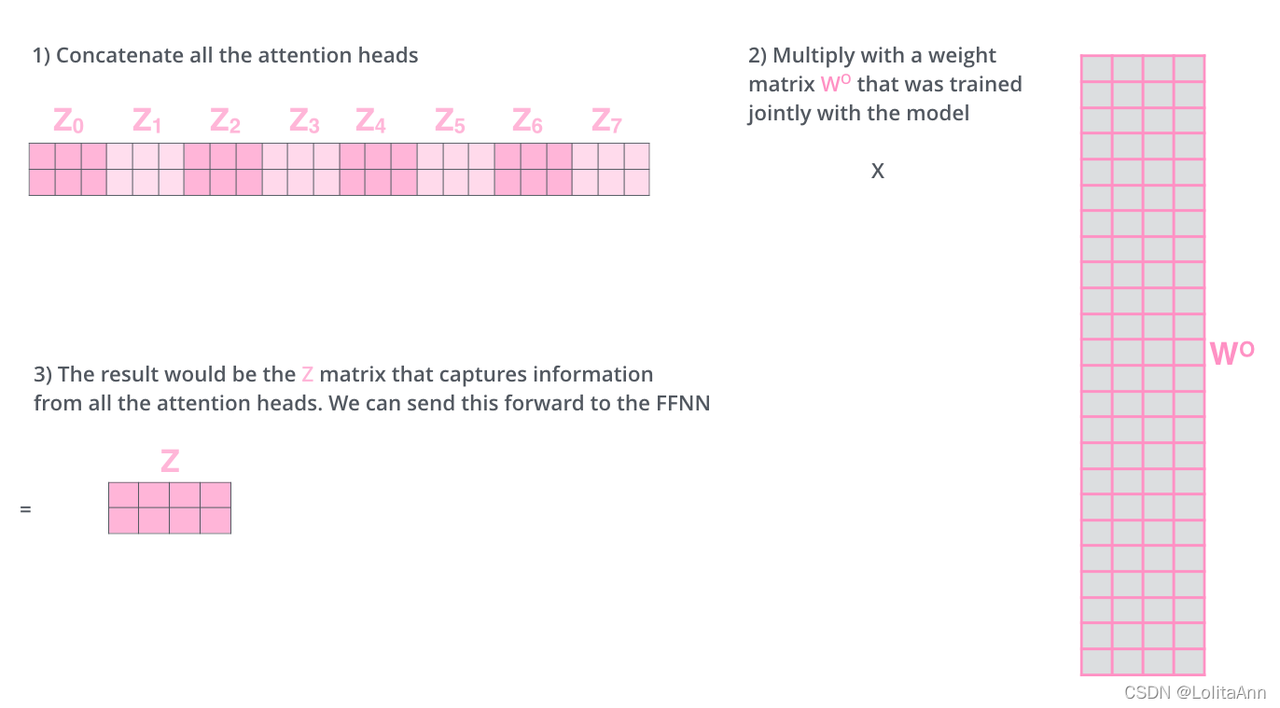

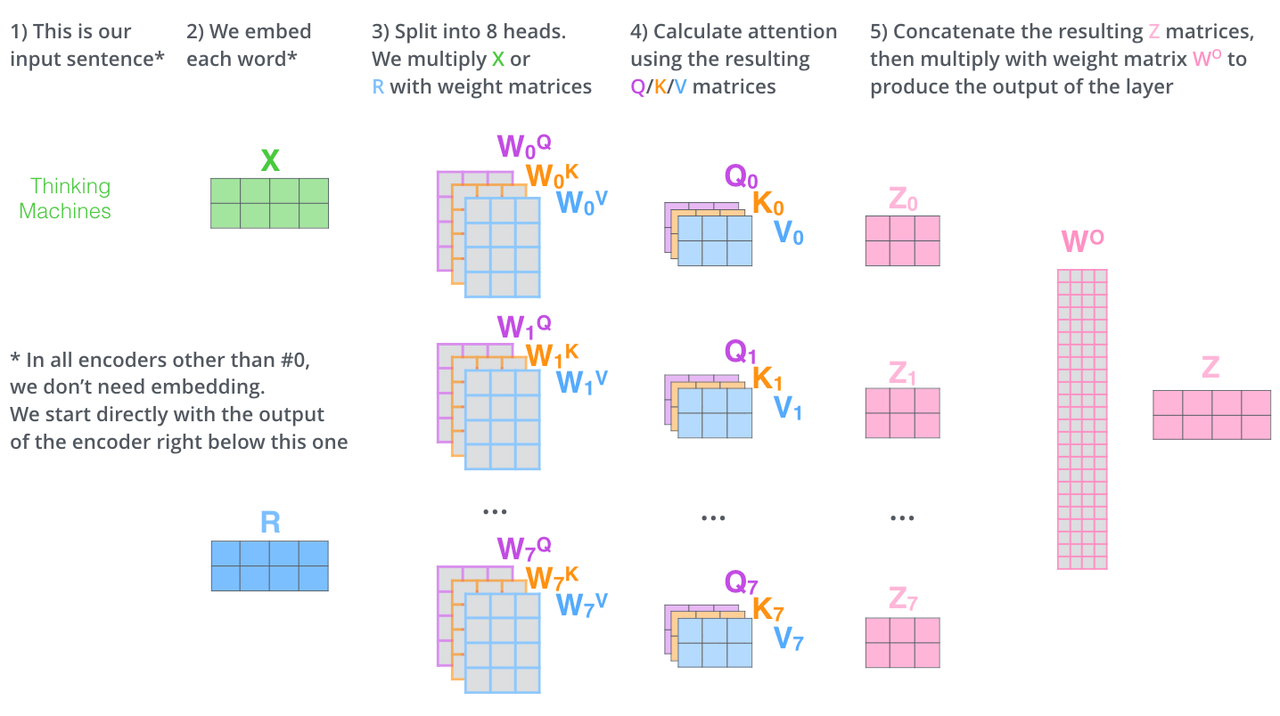

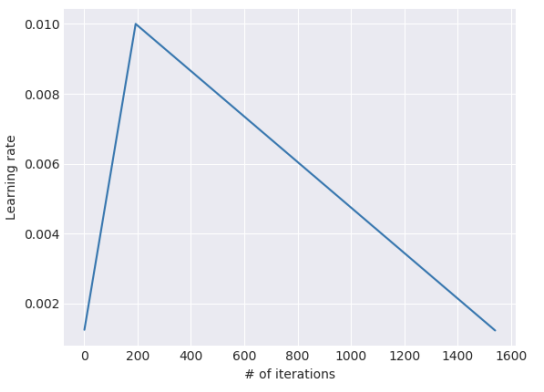

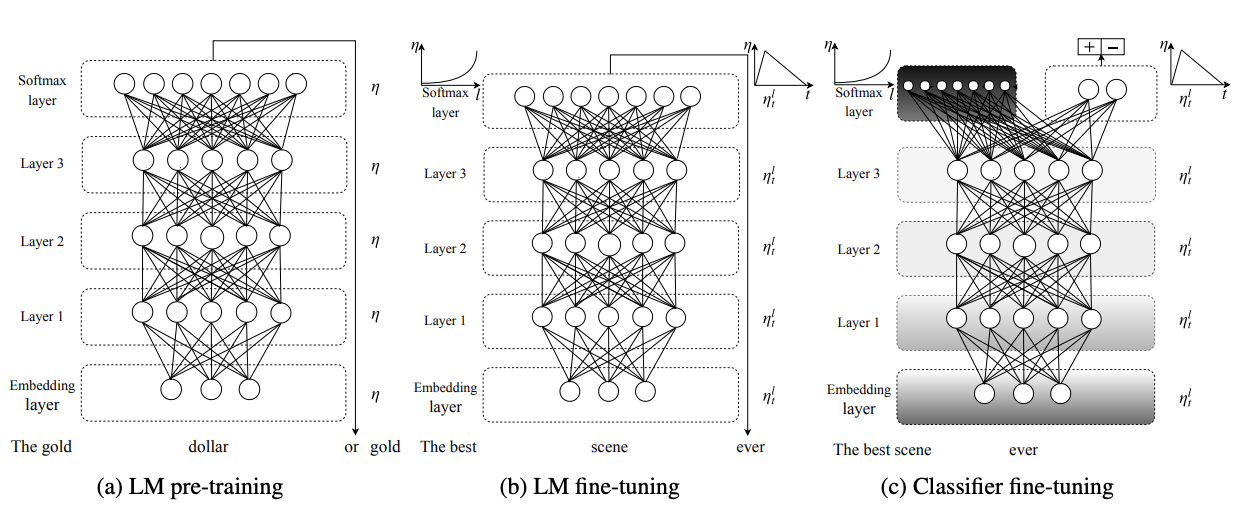

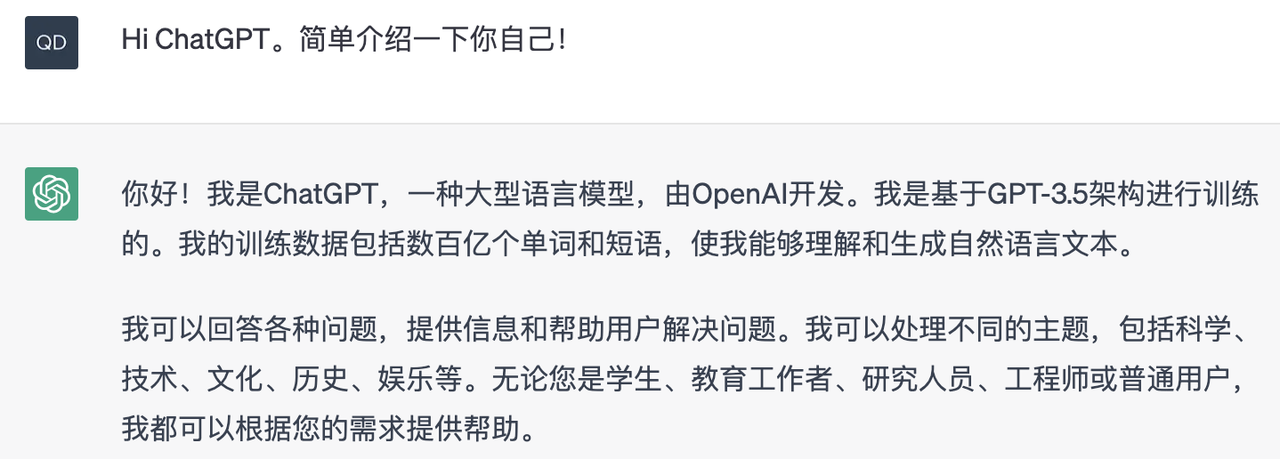

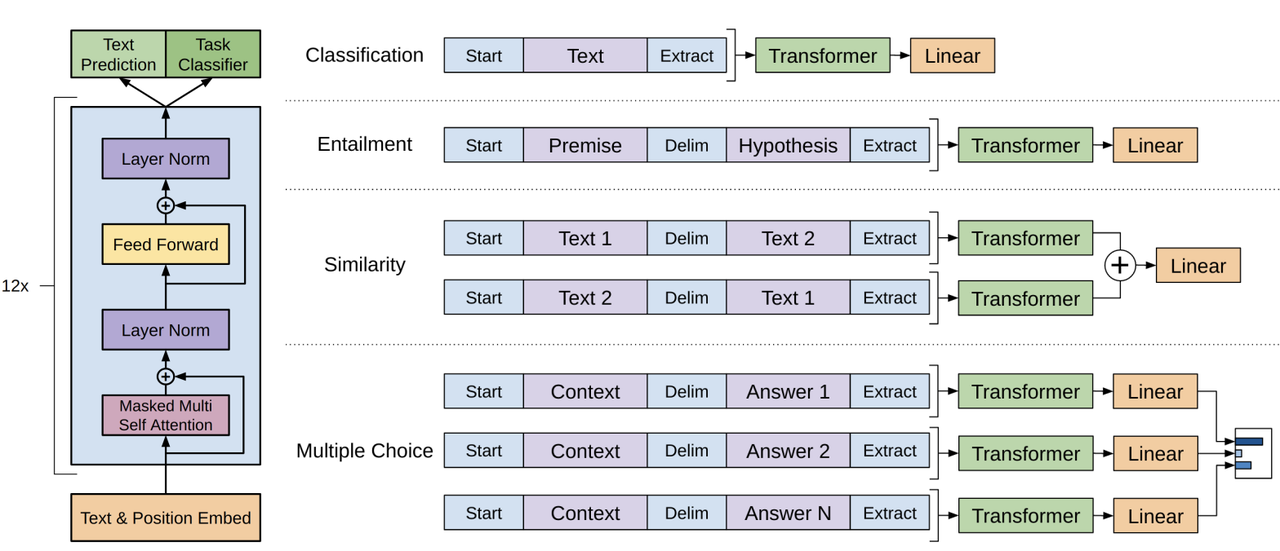

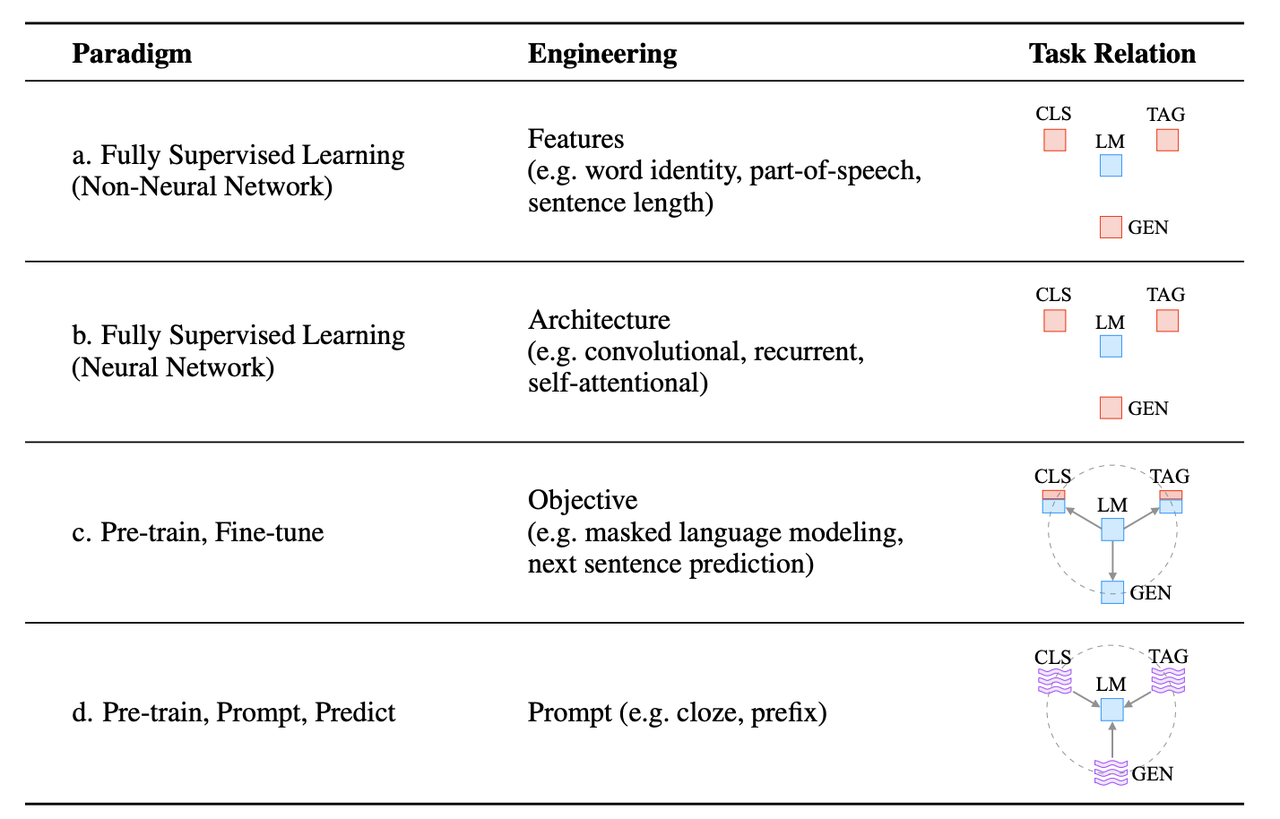

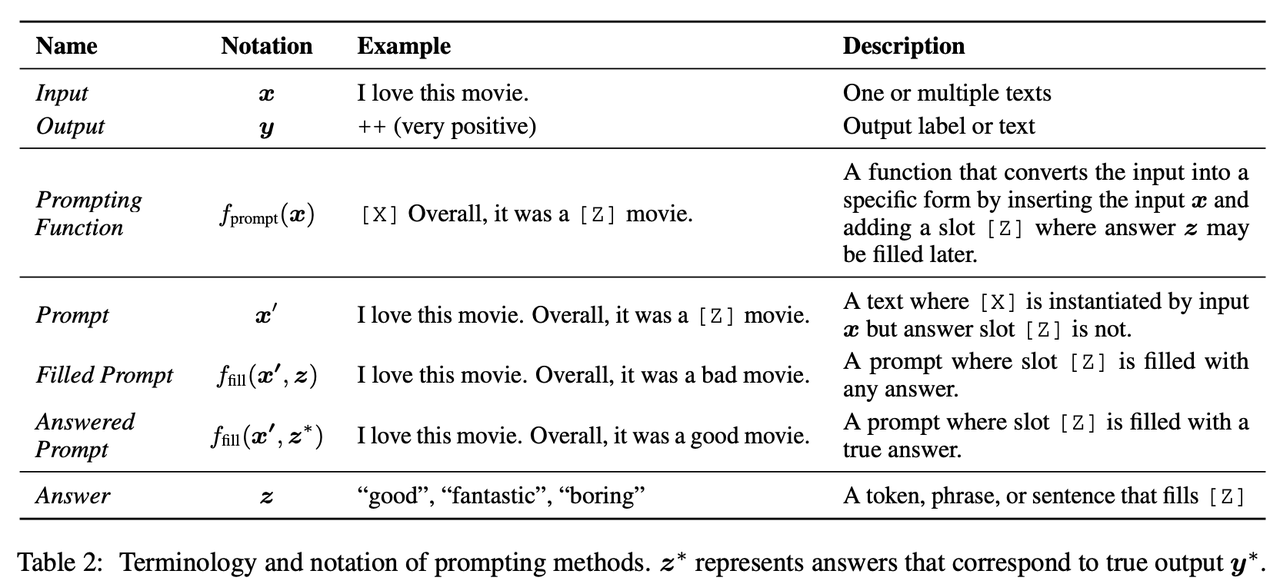

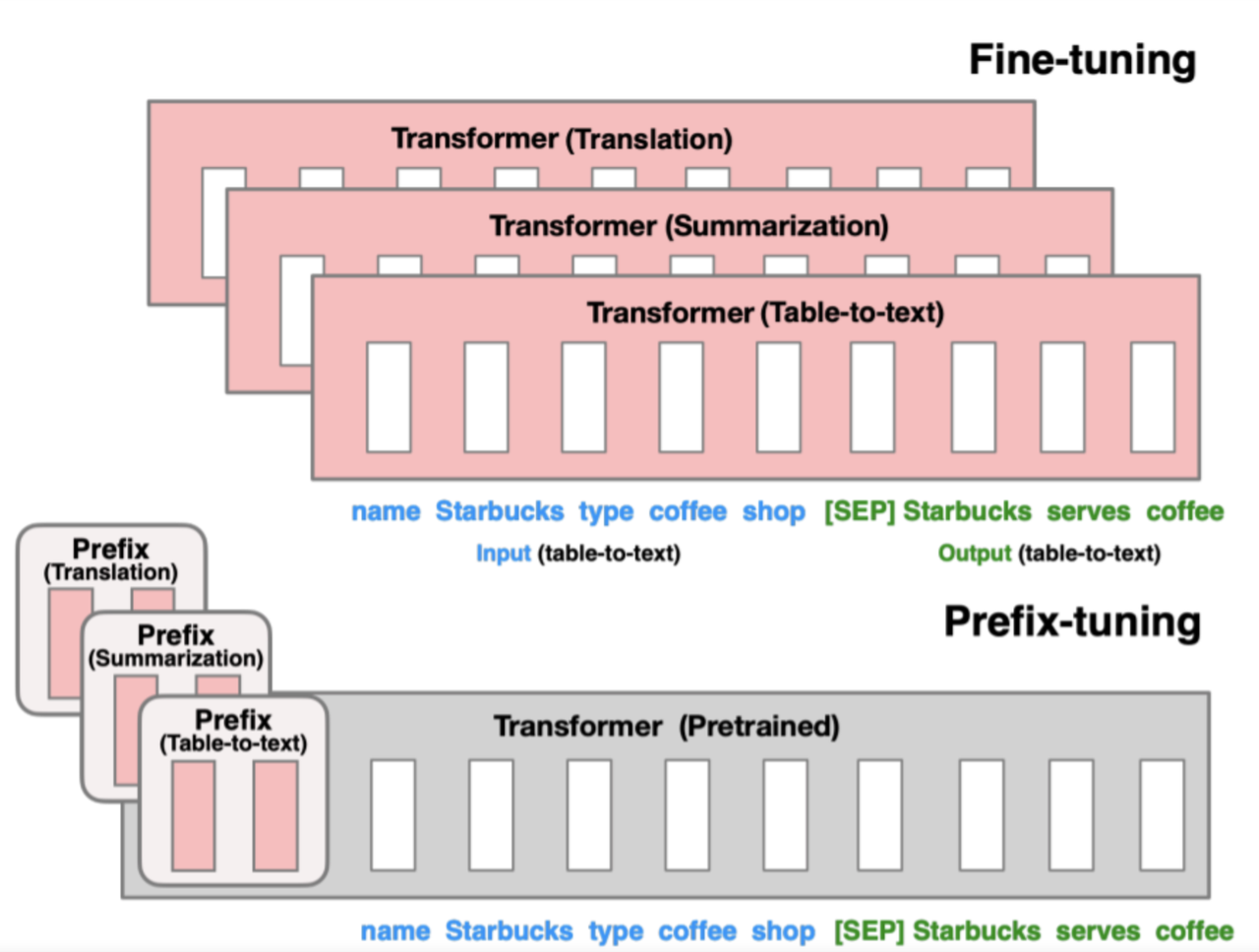

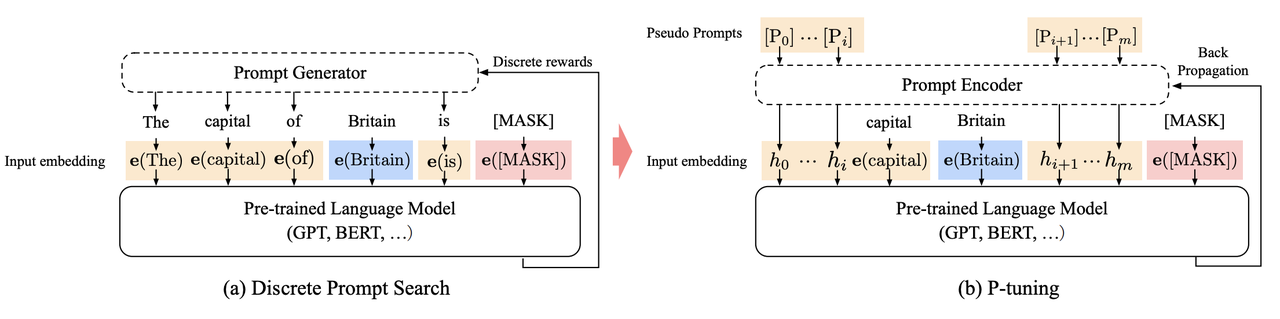

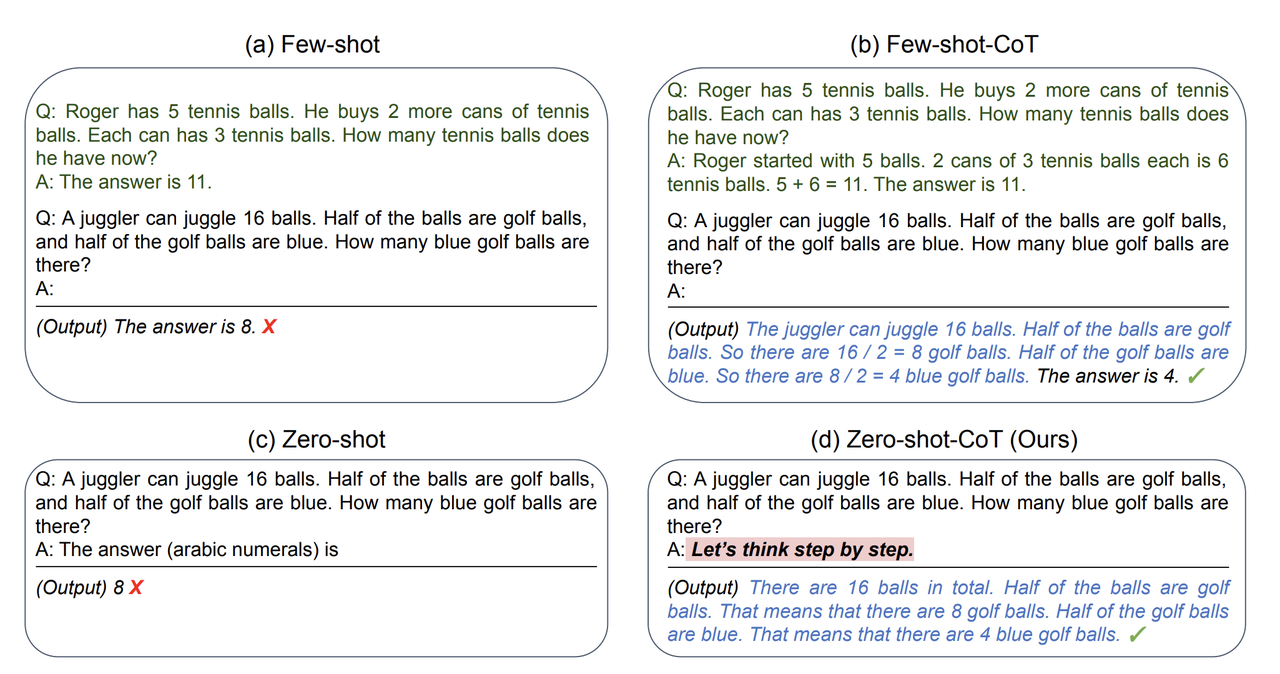

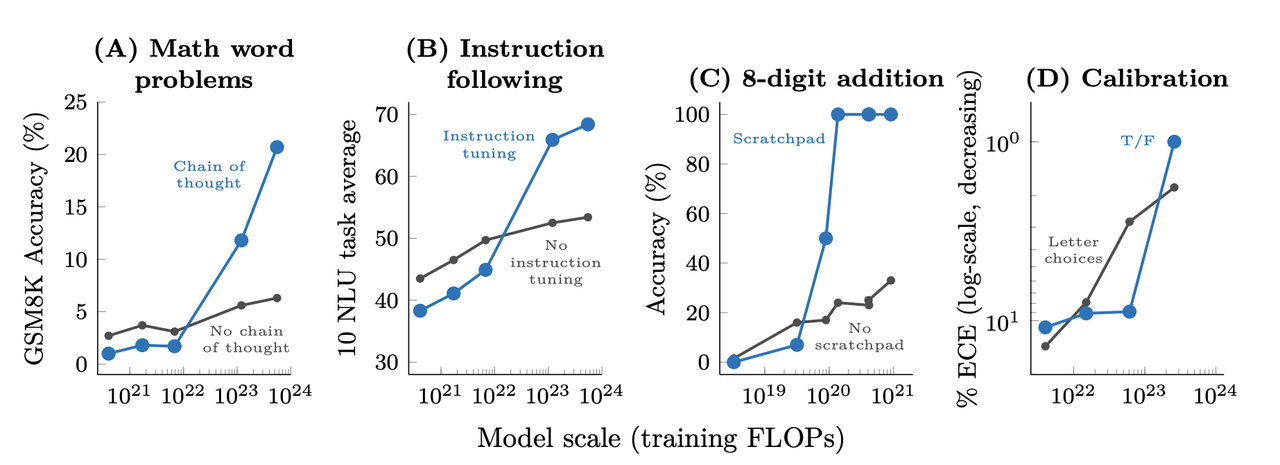

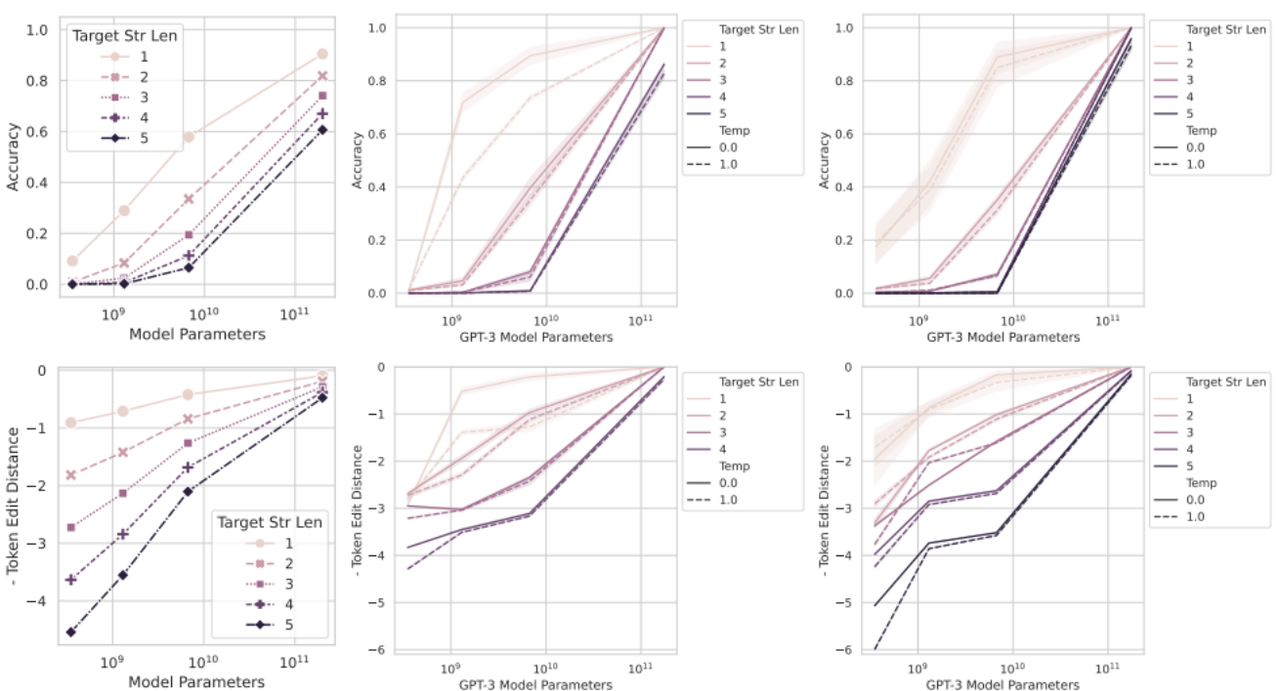

自注意力层为什么叫自注意力层呢?